Python Scrapy框架爬取豆瓣电影实战教程

134 浏览量

更新于2024-08-31

1

收藏 308KB PDF 举报

"Python利用Scrapy框架爬取豆瓣电影的实例教程"

在Python中,Scrapy是一个强大的网络爬虫框架,适用于高效地抓取网站数据并提取结构化信息。本教程将详细阐述如何使用Scrapy来爬取豆瓣电影的相关信息。

1、Scrapy框架介绍

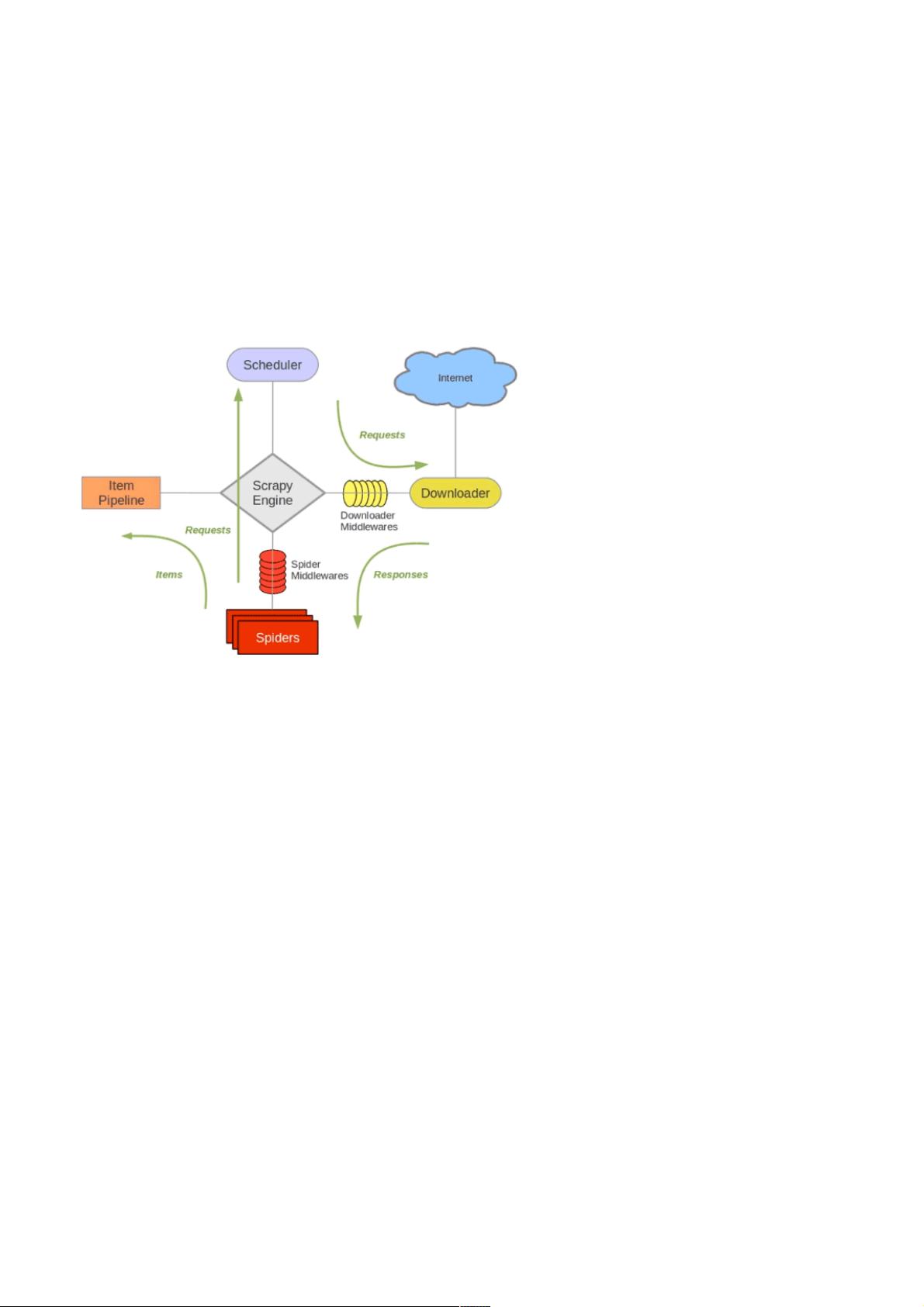

Scrapy是一个高度模块化的爬虫框架,它的核心组成部分包括:

- **引擎(Scrapy Engine)**:负责控制整个系统的数据流,调度请求(Requests)和分发响应(Responses)。

- **调度器(Scheduler)**:接收引擎发送的请求,并按照一定的策略进行队列管理,确保请求顺序执行。

- **下载器(Downloader)**:负责实际的网络交互,从互联网上下载网页内容,并将响应传递回引擎。

- **爬虫(Spiders)**:解析响应内容,提取所需数据,同时可能发现新的URL,将这些URL提交给引擎。

- **管道(Item Pipeline)**:对爬取到的数据进行清理、验证和持久化存储。

- **下载中间件(Downloader Middlewares)**:允许在请求(Requests)被下载器处理之前和响应(Responses)被传递给爬虫之后添加额外的功能,如设置代理、处理验证码等。

- **爬虫中间件(Spider Middlewares)**:在爬虫处理请求(Requests)和响应(Responses)之间添加功能,用于定制爬虫的行为。

Scrapy的工作流程如下:

1. 爬虫从入口URL开始,将URL提交给引擎。

2. 引擎将URL放入调度器。

3. 调度器按照策略返回下一个请求(Request)给引擎。

4. 引擎将请求发送给下载器。

5. 下载器下载网页内容,生成响应(Responses)返回给引擎。

6. 引擎将响应传递给爬虫进行解析。

7. 爬虫处理响应,提取数据,可能产生新的URL,再将数据和新URL提交给引擎。

8. 新URL进入调度器,重复上述过程,直到所有URL爬取完毕。

2、创建Scrapy项目

要开始使用Scrapy,首先需要在Python环境中创建一个新的Scrapy项目。在命令行中,导航到你的工作目录,然后运行以下命令:

```bash

scrapy startproject my_douban_movie

```

这将创建一个名为`my_douban_movie`的新Scrapy项目。接着,你需要创建一个爬虫,可以使用Scrapy的`genspider`命令:

```bash

cd my_douban_movie

scrapy genspider my_spider douban.com

```

这将生成一个名为`my_spider`的爬虫,用于爬取`douban.com`上的数据。接下来,你需要在`my_spider.py`文件中编写爬虫逻辑,包括如何启动爬取、如何解析HTML、如何提取所需数据等。

3、配置Scrapy

在项目目录下的`settings.py`文件中,你可以配置Scrapy的各种参数,如设置下载延迟以避免对目标网站造成过大的压力,或者定义中间件和管道。

4、编写爬虫逻辑

在`my_spider.py`中,你需要定义一个或多个爬虫类,继承自Scrapy的`Spider`基类。这里可以定义爬取的起始URL,以及如何解析HTML响应来提取数据。

5、运行爬虫

完成爬虫逻辑后,使用以下命令启动爬虫:

```bash

scrapy crawl my_spider

```

Scrapy将自动执行爬虫逻辑,抓取和处理数据。如果需要将数据保存到文件,可以配置`Item Pipeline`来处理。

通过理解Scrapy框架的基本原理和组件,以及掌握如何编写爬虫逻辑,你可以轻松地实现Python利用Scrapy框架爬取豆瓣电影信息。这个过程涉及到网络请求、HTML解析、数据提取等多个环节,需要结合Python基础知识和Web开发知识来完成。

5377 浏览量

2128 浏览量

193 浏览量

409 浏览量

137 浏览量

1741 浏览量

118 浏览量

409 浏览量

weixin_38622125

- 粉丝: 7

最新资源

- Spring-Struts-Hibernate集成应用教程

- 工作流基础与jBpm开源引擎解析

- JSP入门教程:基础语法与示例解析

- MD5加密算法详解与安全性分析

- Visual FoxPro 6.0 教程:从基础到面向对象编程

- 新型轴流压缩机防喘振控制系统设计与应用

- 软件开发编码规范与约定详解

- 麦肯锡方法与结构化问题解决

- Vim编辑器完全指南:动手实践版

- 富士变频器RS485通讯卡详细指南:远程操作与扩展功能

- Spring框架入门教程

- C++/C编程规范与指南

- Struts框架详解:构建高效Web应用

- 迈克尔·巴雷的C/C++嵌入式系统编程指南

- Google搜索技巧详解:从基础到高级

- Windows系统管理命令大全