Apache Flume 分布式日志收集教程

"Apache Flume 分布式日志收集用于Hadoop的教程,推荐英文版学习。"

Apache Flume 是一个高度可靠且灵活的数据收集系统,主要用于聚合、聚合和移动大量日志数据。它设计用于在分布式环境中高效地处理流式数据,是大数据生态系统中的重要组件,特别是与Hadoop相结合时。Flume 提供了简单易用的接口,允许用户配置数据源、通道和接收器,从而构建出复杂的数据流动路径。

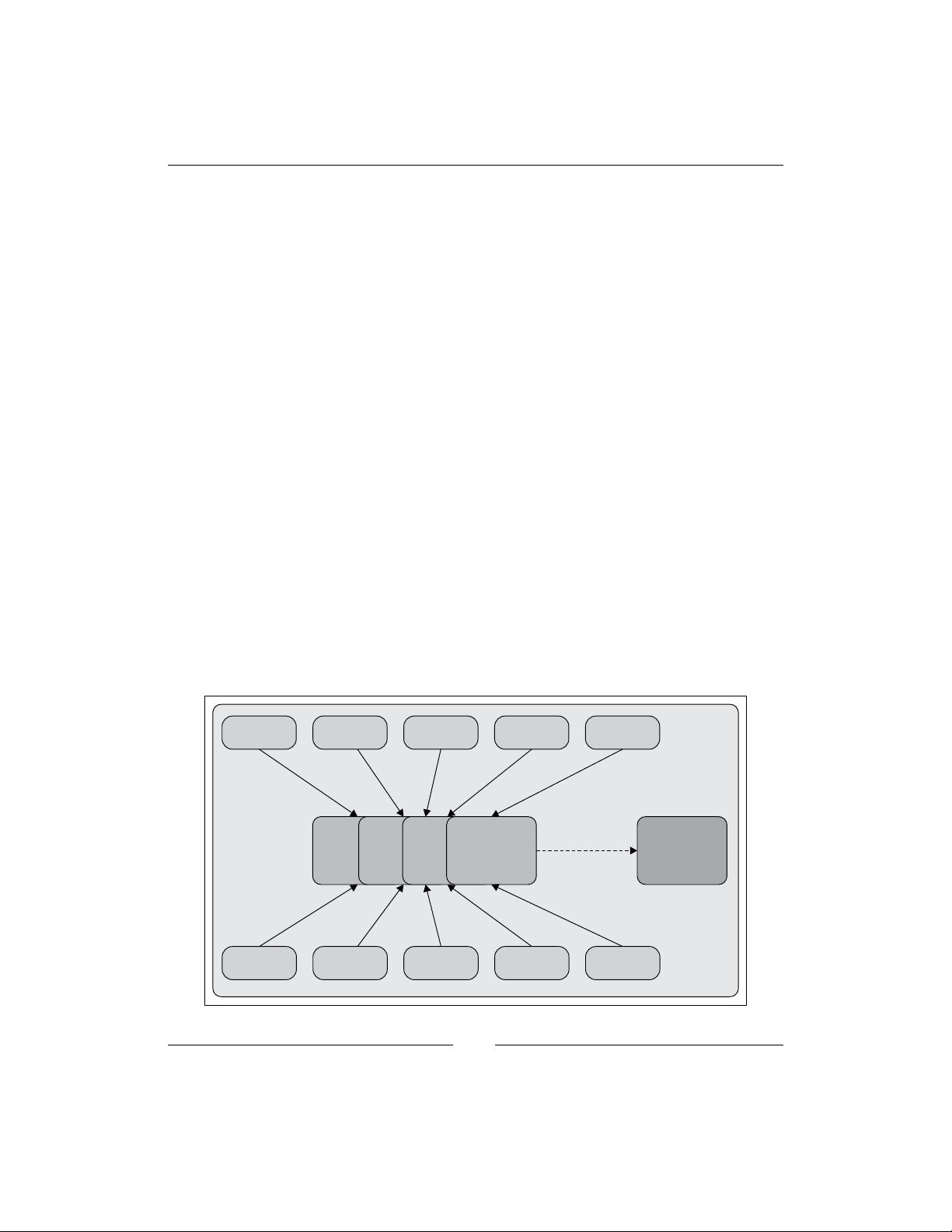

在这个教程中,你将深入理解如何设置和使用 Apache Flume。首先,你需要了解 Flume 的基本架构,它由三个主要组件构成:

1. **数据源(Sources)**:这是 Flume 流程的起点,负责从各种数据生成器获取数据,如日志文件、网络套接字或其他数据流。例如,你可以配置 Flume 来从 Web 服务器的日志文件中读取数据,或者从 Twitter API 直接抓取实时数据。

2. **通道(Channels)**:通道是临时存储数据的地方,确保在数据从源传输到接收器的过程中,即使在故障情况下也能保持数据的持久性和完整性。Flume 支持多种类型的通道,如内存通道(适合低延迟但不持久)、文件通道(持久化但可能影响性能)等。

3. **接收器(Sinks)**:接收器是流程的终点,负责将数据发送到目的地,如 HDFS(Hadoop 分布式文件系统)、数据库或其他 Flume 实例。你可以设置多个接收器来实现数据的多路复用,将数据分发到不同的目标。

此外,教程可能涵盖以下内容:

- 如何配置 Flume:通过编写简单的文本配置文件,定义数据源、通道和接收器之间的关系,以及它们的属性和行为。

- 容错和可靠性:Flume 的事务机制保证了数据的一致性,即使在节点故障时也能恢复。

- 动态扩展和监控:学习如何根据需求动态添加或移除 Flume 实例,以及如何监控和调整系统的性能。

- 集成 Apache Kafka:Kafka 是另一个流行的流处理平台,常用于构建实时数据管道。本教程可能会教你如何设置 Kafka 集群,以及开发自定义的消息生产者和消费者。Flume 可以与 Kafka 集成,作为数据流的中间层,提供更强大的数据处理能力。

最后,虽然这个教程可能涉及 Apache Kafka,但请注意,Kafka 是一个独立的产品,专注于实时消息传递,而 Flume 更侧重于数据收集和传输。两者在大数据生态系统中常常互补,共同构建高效的数据流水线。

在阅读和实践这个教程的过程中,你将掌握如何利用 Flume 设计和部署大规模的日志收集解决方案,这对于大数据分析和实时监控至关重要。同时,了解如何与 Apache Kafka 集成将进一步增强你的数据处理能力。

187 浏览量

2016-02-03 上传

2016-12-19 上传

258 浏览量

2018-01-22 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

BAD_BOY007

- 粉丝: 1

- 资源: 1

最新资源

- JavaScript实现的高效pomodoro时钟教程

- CMake 3.25.3版本发布:程序员必备构建工具

- 直流无刷电机控制技术项目源码集合

- Ak Kamal电子安全客户端加载器-CRX插件介绍

- 揭露流氓软件:月息背后的秘密

- 京东自动抢购茅台脚本指南:如何设置eid与fp参数

- 动态格式化Matlab轴刻度标签 - ticklabelformat实用教程

- DSTUHack2021后端接口与Go语言实现解析

- CMake 3.25.2版本Linux软件包发布

- Node.js网络数据抓取技术深入解析

- QRSorteios-crx扩展:优化税务文件扫描流程

- 掌握JavaScript中的算法技巧

- Rails+React打造MF员工租房解决方案

- Utsanjan:自学成才的UI/UX设计师与技术博客作者

- CMake 3.25.2版本发布,支持Windows x86_64架构

- AR_RENTAL平台:HTML技术在增强现实领域的应用