循环神经网络与LSTM在序列学习中的应用

需积分: 20 114 浏览量

更新于2024-07-18

收藏 16.51MB PDF 举报

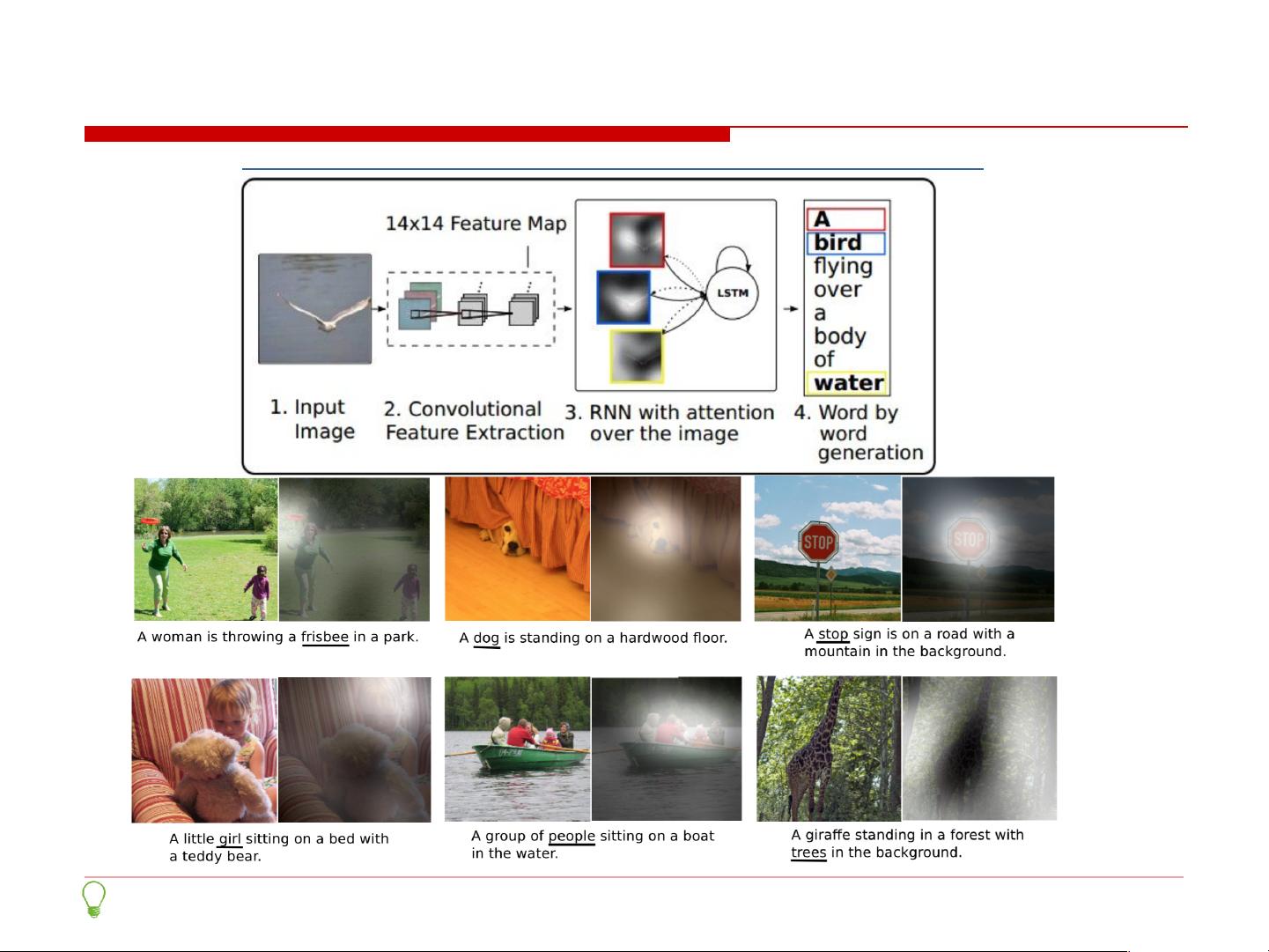

"循环神经网络(RNN)是深度学习领域中的一个重要模型,主要用来处理序列数据,如自然语言、时间序列等。RNN通过其特有的循环结构,能够捕获序列中的时间依赖关系。然而,传统的RNN在处理长距离依赖时会遇到梯度消失问题,这限制了其性能。为了解决这一问题,长短期记忆网络(LSTM)被引入,它通过门控机制有效地解决了梯度消失问题,使得RNN在语言模型、图像描述、文本生成等多个任务中表现出色。注意力模型进一步强化了RNN的能力,允许模型在处理序列时动态聚焦到关键信息上。此外,字符级别的生成模型和基于维基百科数据的训练展示了RNN在文本生成方面的潜力。"

循环神经网络(RNN)是一种专门设计用于处理序列数据的人工神经网络。它的核心特性在于其循环结构,使得网络能够在不同的时间步(t)之间传递信息,形成一种内部的“记忆”。在RNN中,每个时间步的输入(Xt)与前一时间步的状态(St-1)结合,通过非线性激活函数(f,如tanh)来更新状态,形成新的状态St。最终的输出(Ot)通常是基于状态St进行计算,例如在语言模型中,使用softmax层来预测下一个单词的概率。

然而,RNN在处理长期依赖时遇到了挑战,即著名的梯度消失问题,导致网络无法有效学习远距离的依赖关系。为了解决这一问题,长短期记忆网络(LSTM)被提出。LSTM引入了“门控”机制,包括遗忘门、输入门和输出门,这些门控单元分别负责控制信息的流动,从而避免了梯度消失,使网络能够记住更长时间的信息,增强对长期依赖的建模能力。

在实际应用中,RNN和LSTM被广泛应用于各种任务。例如,图像描述生成中,RNN可以从图像的特征向量中生成对应的描述文本;注意力模型进一步增强了这一能力,允许模型在生成描述时根据需要关注图像的不同部分。此外,RNN也被用于字符级别的文本生成,通过学习和理解输入序列的模式,生成新的、类似的人工文本,这在文本艺术和自动文本创作中具有潜力。

一个典型的例子是,通过训练一个RNN模型在维基百科的文本数据集上,可以生成新的文章片段,模拟人类的写作风格。通过开源代码和数据集,开发者可以自行实现并探索这些模型的性能和可能性。

循环神经网络及其变体,如LSTM和注意力模型,是深度学习中不可或缺的工具,它们在处理序列数据的任务中展现了强大的能力和广泛的应用前景。无论是自然语言处理、语音识别还是时间序列预测,RNN家族都扮演着关键角色,持续推动着人工智能技术的发展。

2023-05-30 上传

2023-04-03 上传

2023-06-04 上传

2023-06-10 上传

2023-09-08 上传

2023-10-01 上传

机器学习/亚萌

- 粉丝: 2

- 资源: 11

最新资源

- 天池大数据比赛:伪造人脸图像检测技术

- ADS1118数据手册中英文版合集

- Laravel 4/5包增强Eloquent模型本地化功能

- UCOSII 2.91版成功移植至STM8L平台

- 蓝色细线风格的PPT鱼骨图设计

- 基于Python的抖音舆情数据可视化分析系统

- C语言双人版游戏设计:别踩白块儿

- 创新色彩搭配的PPT鱼骨图设计展示

- SPICE公共代码库:综合资源管理

- 大气蓝灰配色PPT鱼骨图设计技巧

- 绿色风格四原因分析PPT鱼骨图设计

- 恺撒密码:古老而经典的替换加密技术解析

- C语言超市管理系统课程设计详细解析

- 深入分析:黑色因素的PPT鱼骨图应用

- 创新彩色圆点PPT鱼骨图制作与分析

- C语言课程设计:吃逗游戏源码分享