端上智能:深度学习模型压缩与加速技术探讨

需积分: 9 5 浏览量

更新于2024-07-17

收藏 1.36MB PDF 举报

"辽玥端上智能云栖大讲堂的编程语言专场专注于深度学习模型在移动设备上的应用挑战。演讲者李昊介绍了端上智能领域的关键议题——深度学习模型压缩与加速。随着深度学习网络规模的扩大和计算需求的增长,这些模型在智能手机等终端设备上的部署面临性能瓶颈,因此,如何在保持准确度的同时减小模型大小和计算负担成为亟待解决的问题。

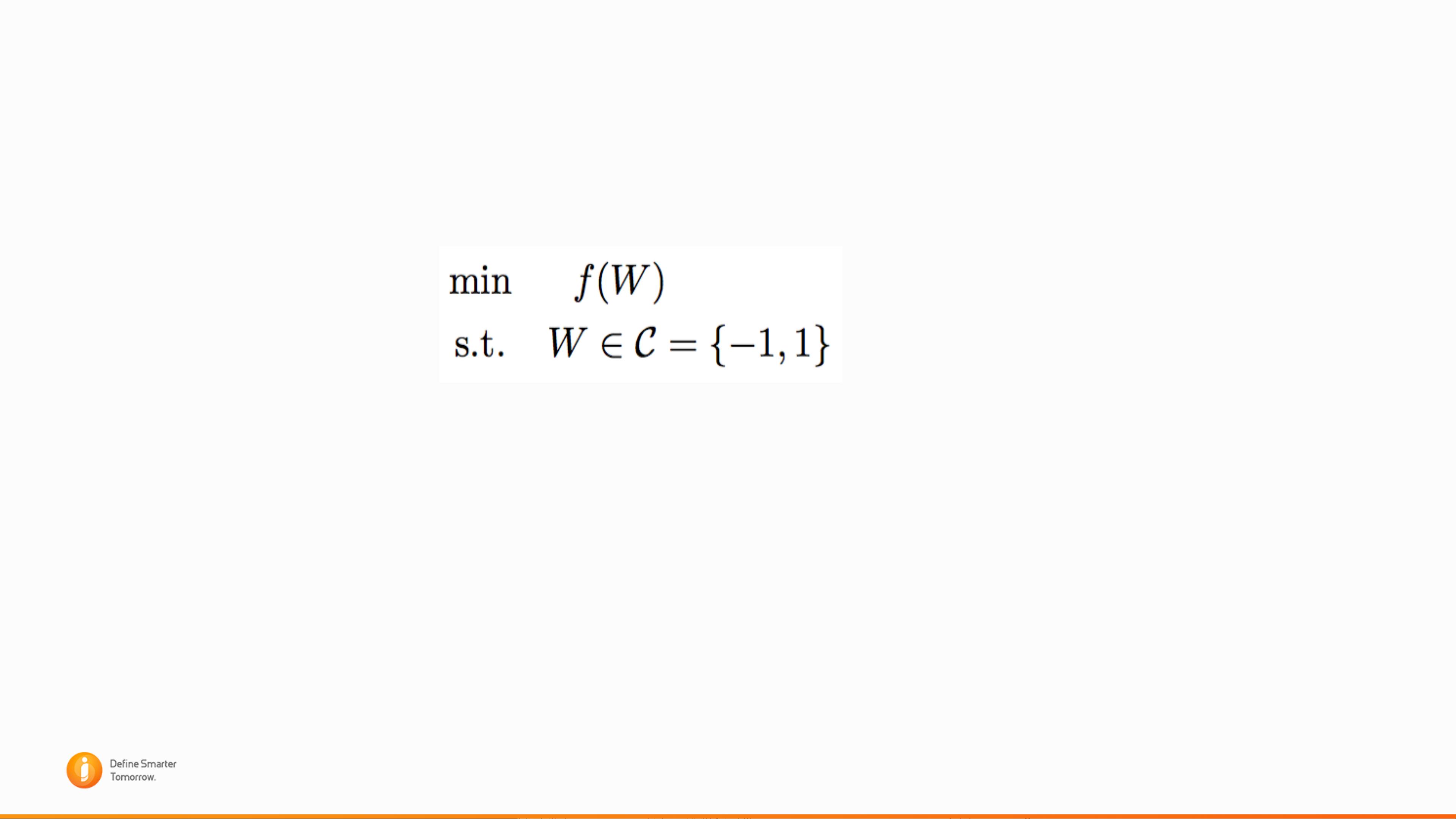

深度学习模型压缩主要涉及低比特(LowBit)模型技术,如ExtremelyLowBitNeuralNetworks(ELBNN),通过将连续的权重转换为离散的低精度权重,例如二值化(Binary)、三值化(Ternary)、多值量化(如C=−8,−4等)。这一过程旨在通过ADMM(Alternating Direction Method of Multipliers,交替方向乘子法)这样的优化方法来解决非凸约束问题。ADMM是一种分布式优化工具,它允许我们将离散化问题转化为线性等式约束形式,便于求解。

在处理二值网络时,核心问题是找到一个有效的策略来求解目标函数,这个函数代表原始神经网络的损失函数。通过引入指示函数和指数函数,演讲者展示了如何将二值神经网络的目标函数转化为一个等价形式,便于通过Augmented Lagrangian(增广拉格朗日函数)来实施ADMM算法。在这个过程中,一致性约束(Consensus Constraints)被引入,通过引入辅助变量G来约束权重W等于G,从而简化问题。

ADMM算法在解决离散优化问题时,涉及到一系列的操作,如移位和加法操作,不同级别的量化(C的不同取值)对应不同的精度和复杂度。通过这种方法,可以在保证一定程度的模型性能的同时,显著降低存储和计算资源的需求,使得深度学习模型能够在移动设备上更加高效地运行,从而推动端上智能的发展。"

weixin_38744375

- 粉丝: 372

- 资源: 2万+

最新资源

- 解决Eclipse配置与导入Java工程常见问题

- 真空发生器:工作原理与抽吸性能分析

- 爱立信RBS6201开站流程详解

- 电脑开机声音解析:故障诊断指南

- JAVA实现贪吃蛇游戏

- 模糊神经网络实现与自学习能力探索

- PID型模糊神经网络控制器设计与学习算法

- 模糊神经网络在自适应PID控制器中的应用

- C++实现的学生成绩管理系统设计

- 802.1D STP 实现与优化:二层交换机中的生成树协议

- 解决Windows无法完成SD卡格式化的九种方法

- 软件测试方法:Beta与Alpha测试详解

- 软件测试周期详解:从需求分析到维护测试

- CMMI模型详解:软件企业能力提升的关键

- 移动Web开发框架选择:jQueryMobile、jQTouch、SenchaTouch对比

- Java程序设计试题与复习指南