弹性网:提升变量选择性能与组内关联的多变量方法

需积分: 10 135 浏览量

更新于2024-07-22

1

收藏 302KB PDF 举报

本文主要讨论了lasso变量选择方法及其在统计学中的应用,特别是通过弹性网(Elastic Net)进行特征选择和正则化的问题。由Hui Zou和Trevor Hastie在2005年发表于《英国皇家统计学会杂志》的一篇论文中提出,这项研究旨在改进传统的lasso方法,因为它在某些情况下表现更优,并且具有独特的优点。

Lasso(Least Absolute Shrinkage and Selection Operator)是一种常用的线性回归模型正则化技术,它通过添加L1范数惩罚项来鼓励模型参数的稀疏性,即在估计过程中,部分系数被压缩到零,实现变量选择。然而,当特征数量p远大于样本数量n(p>n)时,lasso可能无法有效处理,因为它倾向于完全剔除一组高度相关的特征,导致所谓的“弱选择”现象。

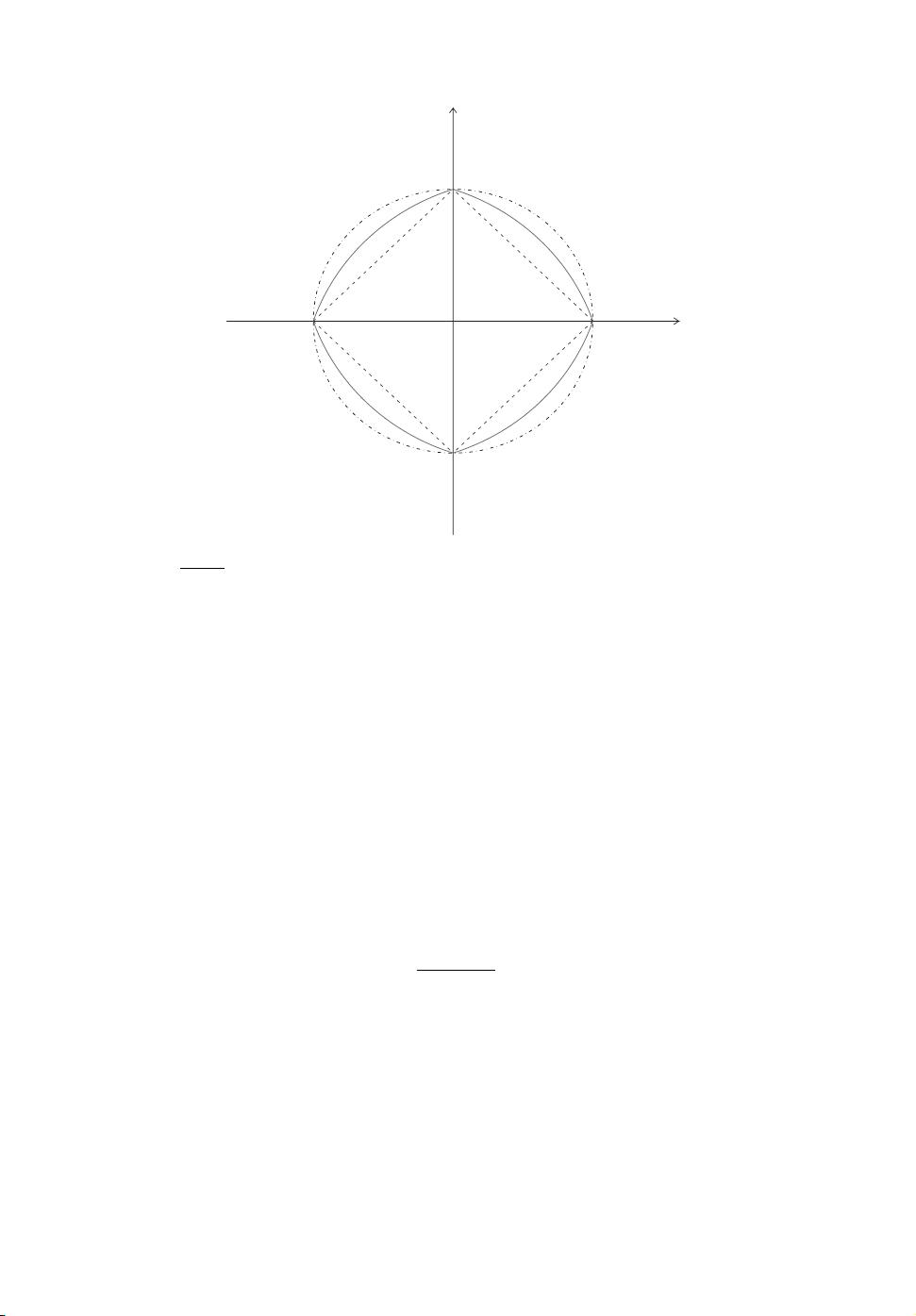

弹性网则是lasso的一个扩展,它同时使用L1和L2范数(也称为岭回归)的混合惩罚,以克服lasso在高维数据集中的局限性。L1惩罚依然鼓励稀疏性,而L2惩罚则有助于保持模型的稳定性和防止过拟合。这意味着弹性网可以在保持一部分系数接近零(类似lasso)的同时,允许其他相关特征保持非零值,这被称为“组选择”或“团体效应”。这种特性使得弹性网在高维场景下,如基因表达数据或经济预测模型中,表现更为出色。

论文的核心贡献是提出了LARS-EN算法,这是基于LARS (Least Angle Regression)算法的一种延伸,专门设计用于高效计算弹性网的正则化路径。LARS-EN算法能够快速地找到最优的模型组合,既考虑了变量的选择又保持了模型的稳定性,尤其是在特征数量庞大的情况下。

关键词包括:组选择效应、LARS算法、lasso、惩罚项、过度参数化问题(p>n问题)以及变量选择。这篇论文提供了在高维数据分析中一个实用且有效的工具,为统计学家和机器学习从业者提供了处理复杂模型和大量特征的有效策略。

2021-05-27 上传

2022-07-14 上传

2018-09-24 上传

2021-03-12 上传

点击了解资源详情

2020-01-29 上传

2022-07-15 上传

2019-12-03 上传

2021-10-04 上传

qq_22116391

- 粉丝: 0

- 资源: 1

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜