深度剖析:Spark性能调优实战——数据倾斜与shuffle优化

本文主要探讨的是Spark应用程序的高级调优策略,特别是针对数据倾斜和shuffle调优的问题。数据倾斜是Spark在处理大规模数据时常见的性能瓶颈,它会导致部分任务执行时间过长,严重影响整体作业的执行效率。当数据在分布式环境中不均匀分布,即某些键值对(key-value pairs)在某些节点上集中大量出现,而其他键值对则相对较少时,就会引发数据倾斜。

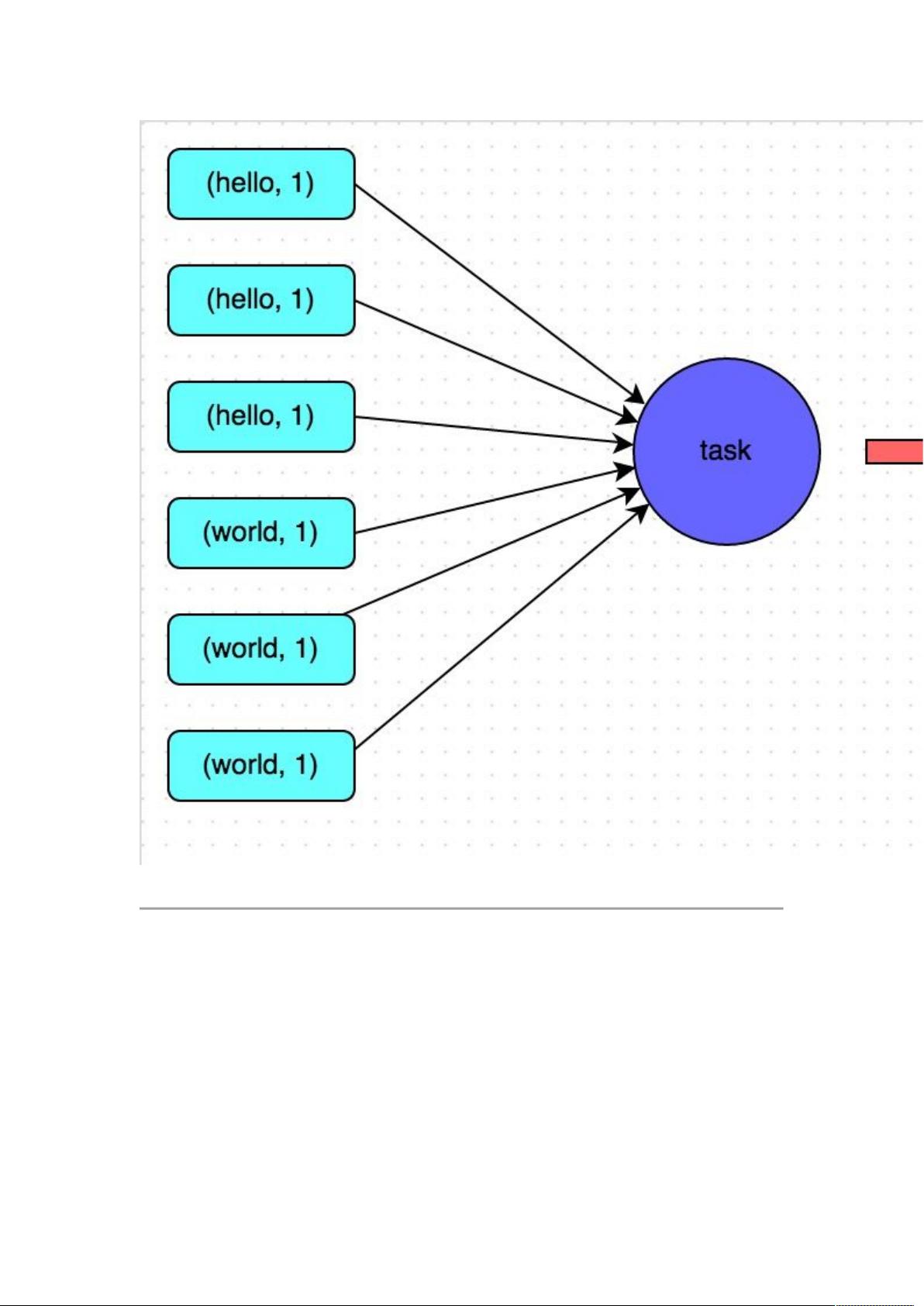

数据倾斜的具体表现通常包括大部分任务迅速完成,而少数任务长时间运行,甚至可能导致内存溢出。例如,一个包含1000个任务的作业中,997个任务在短时间内结束,但剩下的少数几个任务执行时间显著延长。这主要是因为在shuffle阶段,Spark尝试将相同键值的任务聚集到同一节点处理,如果数据量差距悬殊,就会形成性能瓶颈。

定位数据倾斜的关键在于理解数据流在Spark中的运作机制。shuffle操作通常由distinct、groupByKey、reduceByKey、aggregateByKey、join、cogroup等算子触发。要找出问题,需要检查这些操作的源代码,特别是那些可能导致数据分布不均的操作,如join操作中的一方数据过大,或者key-value数据的分布特性。

解决数据倾斜的方法通常包括但不限于以下几点:

1. **数据预处理**:在数据进入Spark之前,可以使用工具如Hive或Flink进行预处理,比如重采样或分区,确保数据在各个节点间的分布更加均衡。

2. **动态分区**:在shuffle前,可以调整Spark的分区策略,使数据更均匀地分布在各个分区中。

3. **数据倾斜检测**:使用内置的倾斜检测工具,如`spark.sql.shuffle.partitions`参数,来监控并调整任务分区数量,以便平衡负载。

4. **任务并行度调整**:根据实际情况,适当调整map和reduce阶段的并行度,避免过多的task集中在少数节点。

5. **使用局部性原则**:对于重复性较高的计算,尝试使用局部性优化,如广播变量或pipelining,减少远程数据交换。

6. **优化join操作**:如果是join操作导致的数据倾斜,可以通过改变join策略(如broadcast join、shuffled join)或调整join键的大小来减轻问题。

数据倾斜调优是Spark性能优化的重要环节,通过对数据分布和shuffle过程的深入理解,以及合理配置和优化代码,可以显著提升Spark作业的执行效率和稳定性。在实际应用中,需要根据具体场景灵活选择和组合这些策略。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-03-16 上传

2024-07-12 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

蚂蚁大哥大

- 粉丝: 150

- 资源: 3