云计算环境下的MapReduce文档去重实现

需积分: 18 18 浏览量

更新于2024-07-06

收藏 681KB DOCX 举报

"mapreduce实现文档数据去重"

MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算。它极大简化了大数据处理的复杂性,使得开发者能够编写简单的程序处理海量数据。在本项目中,MapReduce被用来解决文档数据去重的问题,这是一个常见的大数据清洗任务。

在云计算背景下,MapReduce成为了处理和分析大数据的有效工具。云计算通过网络连接大量分布式计算资源,提供按需服务,这种模式包括SaaS(Software as a Service),PaaS(Platform as a Service)和IaaS(Infrastructure as a Service)。在MapReduce中,数据被分发到多个节点进行并行处理,每个节点执行Map函数,将原始输入数据转换为键值对。随后,Reduce函数将这些键值对进行聚合,消除重复,最终得到去重后的文档数据。

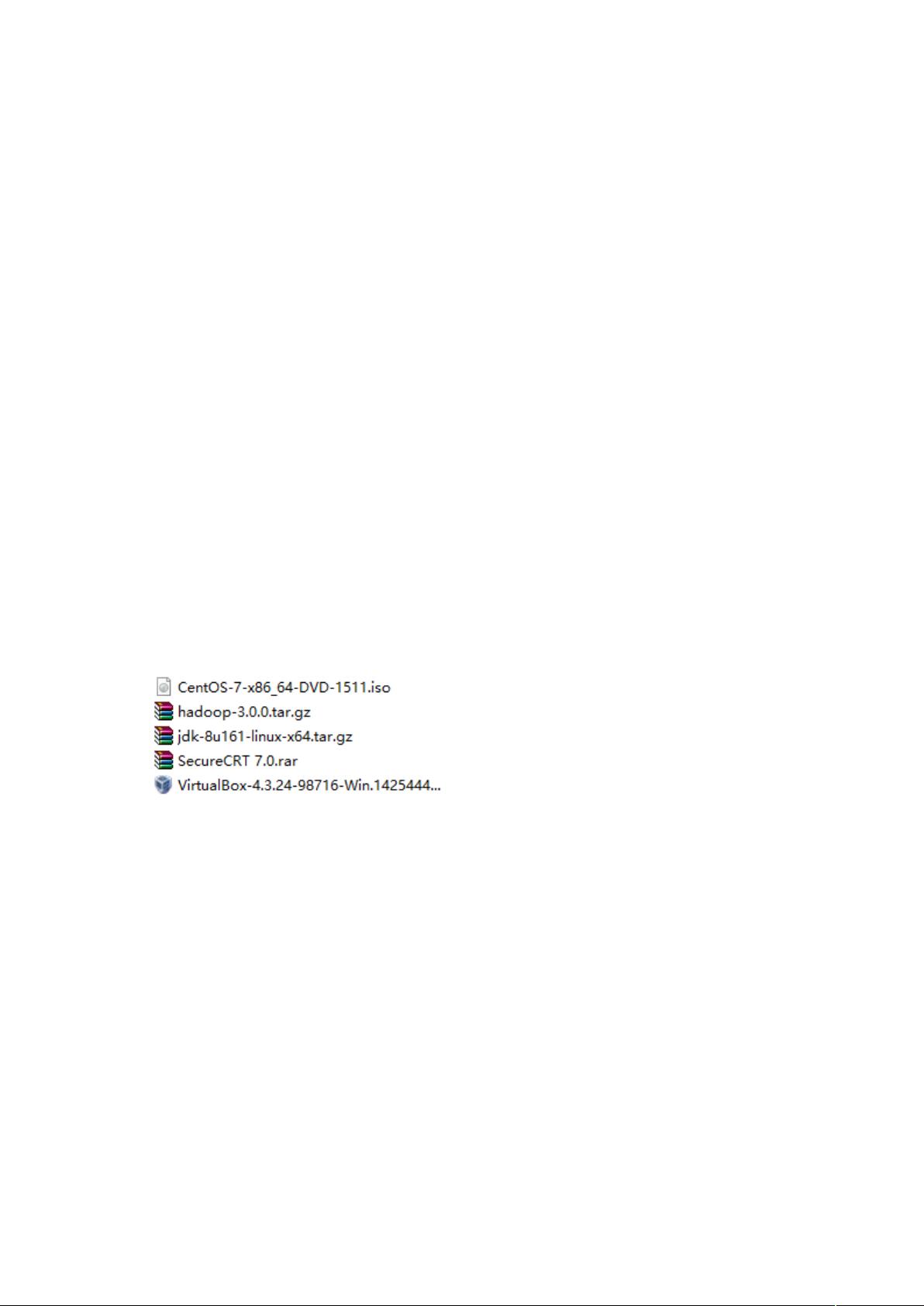

系统搭建的目标是配置一个支持MapReduce运行的环境,如Hadoop,它是一个开源的分布式计算框架,可以处理和存储海量数据。Hadoop环境的搭建通常涉及安装Hadoop集群,配置网络设置,以及优化系统参数以提高性能。

环境需求分析包括硬件资源(如CPU、内存、磁盘空间和网络带宽)和软件依赖(如Java环境、Hadoop版本和其他相关库)。环境配置分析则关注如何正确安装和配置这些组件,以确保MapReduce作业能高效运行。

在功能设计阶段,首先需要设计一个适合数据去重的算法。这可能涉及到哈希函数或排序-合并策略,以识别和剔除重复的文档。接着,根据算法设计编写MapReduce程序,Map部分负责将文档数据转换为键值对,Reduce部分则处理这些对,去除重复。步骤设计包括数据读取、处理、写回等环节,而功能测试验证则确保程序在不同数据集上都能正确运行,达到去重目的。

通过这个项目,开发者不仅能掌握MapReduce编程,还能深入理解云计算环境下的数据处理流程,以及如何利用分布式计算解决实际问题。同时,这也是对大数据处理能力的一次实践检验,有助于提升对大数据生态系统(如Hadoop、YARN等)的理解和应用能力。

2022-07-11 上传

2024-03-13 上传

2021-07-09 上传

2023-05-20 上传

2023-10-27 上传

2023-04-05 上传

在Hadoop环境下的Linux系统中,如何运用MapReduce技术实现数据去重、排序及挖掘?请结合《MapReduce编程实践:文件合并与去重、排序与信息挖掘》一书,提供具体的操作步骤和代码示例。

2024-11-11 上传

2024-05-23 上传

2023-10-24 上传

Largerstoremia

- 粉丝: 4

- 资源: 2