大数据基石:Hadoop技术详解与生态

需积分: 1 124 浏览量

更新于2024-09-13

收藏 190KB DOCX 举报

Hadoop是大数据技术领域的一项关键组件,由Apache Software Foundation 在2005年秋季作为Lucene子项目Nutch的一部分引入。它的诞生受到了Google实验室的两项重要创新——Map/Reduce和Google File System (GFS) 的深刻影响。Hadoop的名字来源于项目创始人Doug Cutting的儿子为一只棕黄色大象玩具起的名字,体现了其简洁而强大。

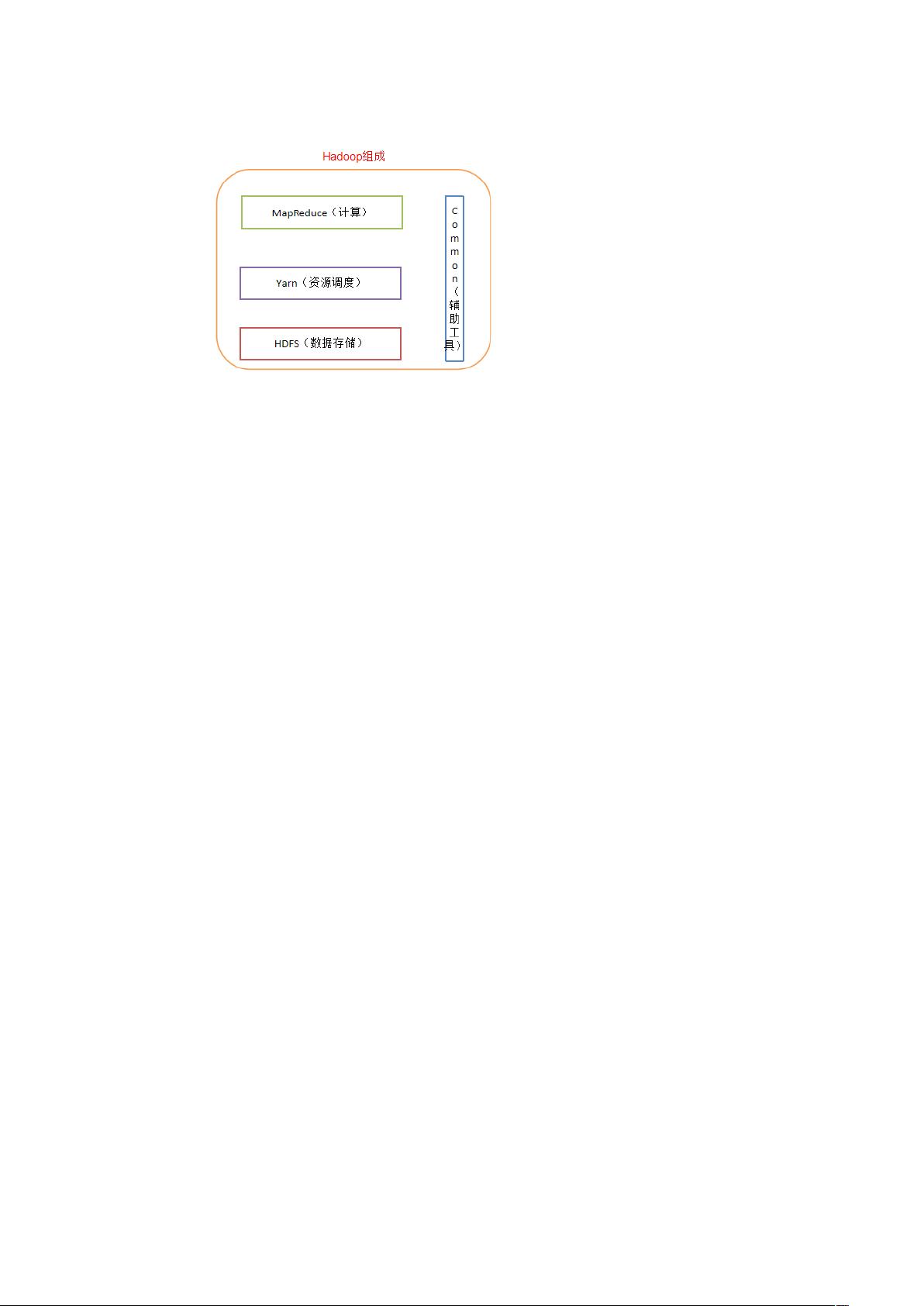

Hadoop的核心优势在于其高可靠性、高扩展性、高效性和高容错性。它假设硬件可能出现故障,因此通过维护多个数据副本来确保数据安全,并在节点故障时自动重分布处理。Hadoop的架构主要由以下几个关键部分组成:

1. **Hadoop Distributed File System (HDFS)**: 一个高可靠、高吞吐量的分布式文件系统,用于存储大规模数据,Namenode负责元数据的存储,而Datanode则存储数据并进行数据块的校验,Secondary Namenode则周期性地合并元数据以维护一致性。

2. **Hadoop MapReduce**: 分布式离线并行计算框架,基于Map/Reduce模型,允许大规模数据集的并行处理,提高了任务执行速度。

3. **YARN (Yet Another Resource Negotiator)**: 是Hadoop 2.0及后续版本引入的资源管理和调度框架,负责作业调度和集群资源的高效利用,包括ResourceManager和NodeManager两个主要角色。

4. **Hadoop Common**: 提供底层工具支持,如配置管理、远程过程调用、序列化机制和日志操作等,为其他模块提供基础功能。

在Hadoop生态系统中,还有其他扩展组件如HBase(类似于Google的BigTable,提供分布式列式数据库服务),这些组件共同构成了大数据处理的强大平台。Hadoop的出现使得企业能够有效地处理和分析大规模数据,成为现代数据密集型应用的基石。Google的原始论文对Hadoop的设计思想有着深远的影响,表明了Hadoop在遵循原有理念的基础上,适应了更广泛的商业环境和性能需求。

2023-08-04 上传

2020-03-19 上传

2023-05-06 上传

2020-01-19 上传

2020-10-10 上传

2020-10-10 上传

2020-01-19 上传

2020-10-10 上传

あ触动、

- 粉丝: 0

- 资源: 1

最新资源

- Fisher Iris Setosa数据的主成分分析及可视化- Matlab实现

- 深入理解JavaScript类与面向对象编程

- Argspect-0.0.1版本Python包发布与使用说明

- OpenNetAdmin v09.07.15 PHP项目源码下载

- 掌握Node.js: 构建高性能Web服务器与应用程序

- Matlab矢量绘图工具:polarG函数使用详解

- 实现Vue.js中PDF文件的签名显示功能

- 开源项目PSPSolver:资源约束调度问题求解器库

- 探索vwru系统:大众的虚拟现实招聘平台

- 深入理解cJSON:案例与源文件解析

- 多边形扩展算法在MATLAB中的应用与实现

- 用React类组件创建迷你待办事项列表指南

- Python库setuptools-58.5.3助力高效开发

- fmfiles工具:在MATLAB中查找丢失文件并列出错误

- 老枪二级域名系统PHP源码简易版发布

- 探索DOSGUI开源库:C/C++图形界面开发新篇章