Linux下Hadoop 2.6.3 + Spark 1.5.2 + HBase 1.1.2 + Hive 1.2.1 + Zo...

本指南详细介绍了如何在Linux 64位系统上安装Hadoop 2.6.3、Spark 1.5.2、HBase 1.1.2、Hive 1.2.1和Zookeeper 3.4.6的整合环境,适用于搭建一个三节点(worker1、worker2、worker3)的集群。以下是安装步骤和注意事项:

1. 软件下载:

- 从官方网站下载预先编译的Linux 64位版本的软件包,确保使用JDK 1.7或更高版本(推荐使用Oracle官方提供的历史版本),因为某些组件可能不支持JDK 1.6,需查看最新的官方文档确认。

2. 环境准备:

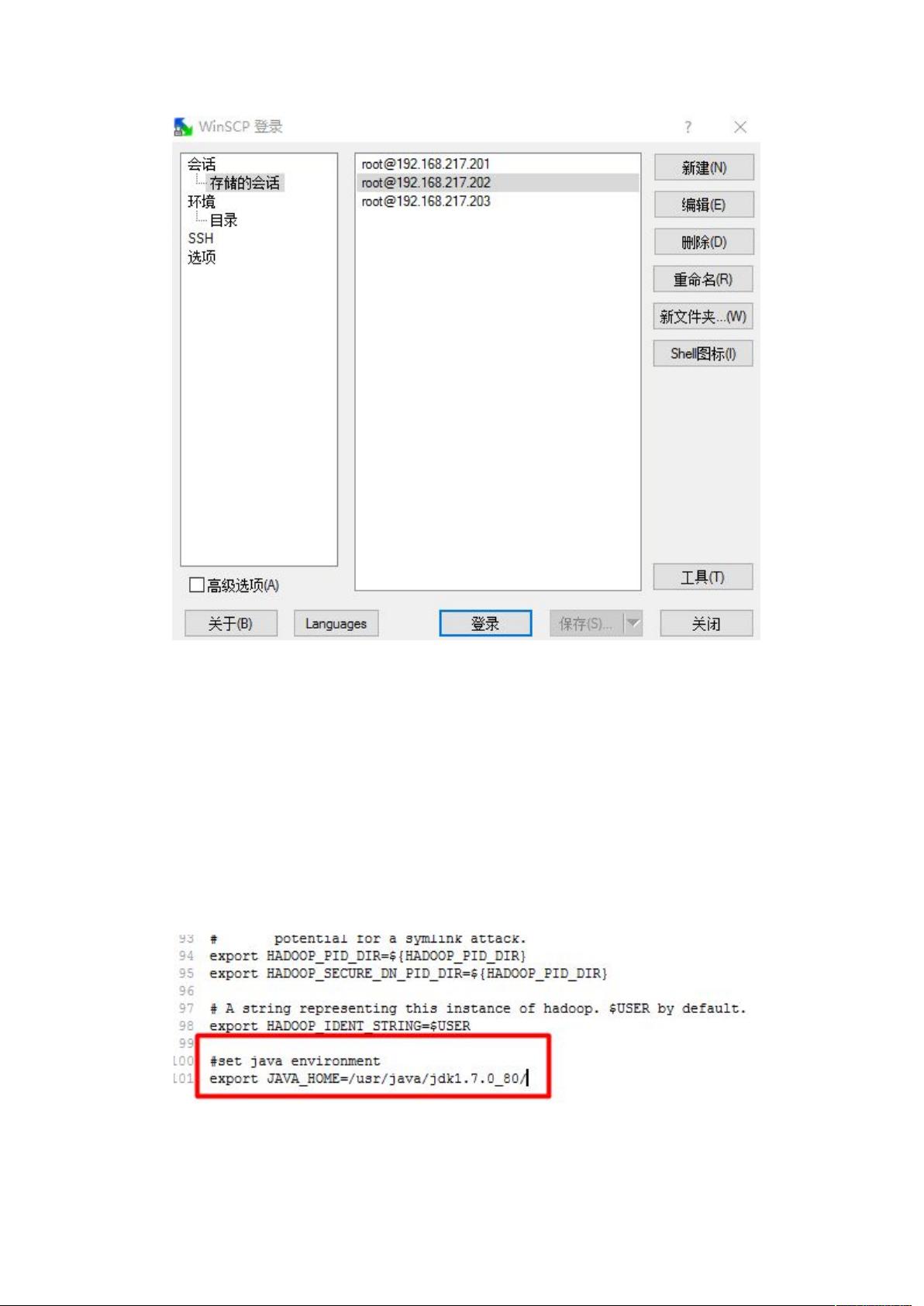

- 集群包含一个主节点(worker1)作为NameNode和ResourceManager,其他节点作为DataNode和NodeManager。所有节点通过局域网连接,并配置静态IP,以模拟真实的网络环境。例如,worker1的IP是192.168.217.201,其他节点依次类推。

- 对所有节点进行主机名修改(vim /etc/sysconfig/network)并配置静态IP,同时更新"/etc/hosts"文件,确保各节点间可通过IP和主机名互相访问。

3. 主机名和hosts文件配置:

- 在集群配置中,编辑"/etc/hosts"文件,将每个节点的主机名和IP对应起来,以便于内部通信。

4. Hadoop组件安装:

- 安装顺序可能为先安装Zookeeper,因为它通常作为其他服务的协调者;接着安装Hadoop HDFS(NameNode、DataNode)、YARN(ResourceManager、NodeManager)以及HBase和Hive,注意根据官方文档的要求进行版本兼容性检查。

5. 启动与配置:

- 安装完成后,启动各个守护进程,配置Hadoop和YARN的配置文件(如core-site.xml、hdfs-site.xml、yarn-site.xml等),确保正确设置核心参数和资源分配。

6. 测试和验证:

- 完成安装后,可以通过命令行工具(如hadoop fs、spark shell)来测试Hadoop和Spark的功能,比如查看文件系统、运行Spark作业等。

7. 注意事项:

- 在大规模部署时,可能还需要考虑网络隔离、安全性和性能优化等因素。

- 软件版本间的兼容性需要谨慎处理,以避免潜在的问题。

这个安装指南提供了搭建多节点Hadoop、Spark、HBase和Hive集群的详细步骤,有助于读者理解分布式计算环境的配置和管理。对于实际操作,务必遵循官方文档的指引,并根据实际情况调整配置。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2016-01-27 上传

2016-01-27 上传

2016-01-27 上传

2016-01-27 上传

2016-01-27 上传

h295203236

- 粉丝: 0

- 资源: 2

最新资源

- alkbot

- 飞翔的小鸟java源码-awesome-quora:Quora上有趣的问题/答案的集合

- SchoolAgent:既然如此就叫排课小帮手吧

- trailerplan-log-elk:带Python Django Rest API应用程序的trailerplan和将postrgresql记录到麋鹿堆栈

- ept_fota_robot

- izivan_flutter_test

- Clouderandroid:Cloudera安卓客户端

- tsetmc-daily-crawler

- CICD-integration

- wu-manber:Wu-Manber多字符串搜索算法的生锈实现

- Linked-lists

- 框内文字

- biglobby-master.7z

- groc

- 基于stm32步进电机T型加减速控制

- import-csv2:用于读取CSV文件的PowerShell模块