云计算实战:Linux与Apache Hadoop搭建MapReduce

151 浏览量

更新于2024-08-28

收藏 318KB PDF 举报

“用Linux和ApacheHadoop进行云计算”

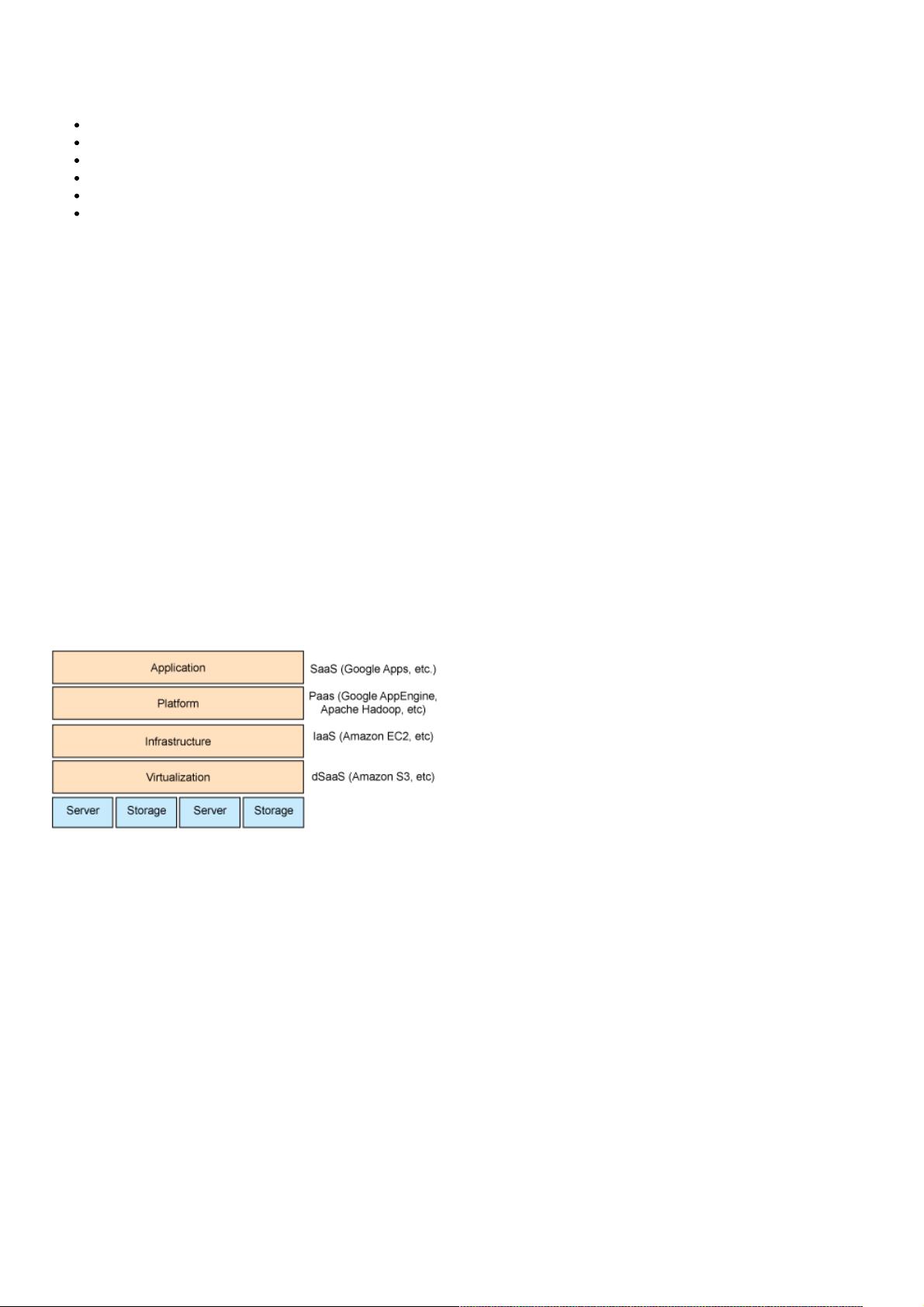

在当今的IT行业中,云计算已经成为一个重要的领域,被广泛视为信息技术的新趋势。它允许用户利用互联网访问并使用外部服务提供商的计算资源,如IBM、Google、VMWare和Amazon等公司的产品。云计算的核心特性在于其可伸缩性、按需付费模式,以及无需用户关心底层硬件、网络、存储和安全性的管理。

Amazon Elastic Compute Cloud (EC2) 是一种代表性的基础设施即服务(IaaS),它提供可定制的虚拟服务器实例,用户可以根据需要选择不同的计算能力、内存和存储空间。通过EC2,用户只需为实际使用的计算时间付费,这极大地降低了运营成本,尤其是对于那些需要大量计算资源但又不想投资昂贵硬件的企业来说。

Apache Hadoop 是一个开源的分布式计算框架,特别适合处理和存储大规模数据集。Hadoop基于MapReduce编程模型,它可以将复杂的计算任务分解成许多小任务,然后在多台服务器上并行处理,极大地提高了数据处理效率。Hadoop的另一个关键组件是Hadoop Distributed File System (HDFS),它设计用于跨大量廉价硬件节点存储数据,保证了数据的高可用性和容错性。

在云计算环境中部署Hadoop,可以进一步提升其性能和灵活性。通过在Amazon EC2上设置Hadoop集群,用户可以快速扩展或缩减计算资源,适应不断变化的工作负载。此外,由于Hadoop可以在虚拟机上运行,因此不仅限于Amazon的云环境,也可以部署在其他云提供商或本地的Linux环境中。

创建MapReduce应用程序是利用Hadoop进行大数据处理的关键步骤。MapReduce由两个主要阶段组成:Map阶段和Reduce阶段。Map阶段将输入数据分割,然后对每个分割应用用户定义的函数;Reduce阶段则聚合Map阶段的结果,生成最终输出。开发MapReduce程序需要理解这两个阶段的工作原理,并编写相应的Mapper和Reducer代码。

在云计算中,例如使用Amazon EC2设置Hadoop集群,可以采用以下步骤:

1. 创建EC2实例:根据需求选择适当的实例类型和配置。

2. 安装Hadoop:在实例上安装和配置Hadoop软件栈。

3. 配置集群:设置Hadoop的集群参数,如节点间通信、HDFS的存储配置等。

4. 上传数据:将数据集上传到HDFS。

5. 编写MapReduce程序:根据业务逻辑编写Mapper和Reducer代码。

6. 执行任务:提交MapReduce作业到Hadoop集群执行。

7. 监控和优化:通过Hadoop提供的监控工具跟踪任务进度,必要时调整配置以优化性能。

结合Linux和Apache Hadoop,企业可以构建一个高效且灵活的云计算解决方案,应对大数据处理和分析的需求。这使得即使小型企业也能利用云计算的强大功能,而无需投入大量的初期硬件成本。同时,随着技术的不断发展,使用Hadoop进行云计算的应用场景将继续扩展,为企业带来更多的可能性。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2013-11-04 上传

2021-05-20 上传

2021-05-24 上传

2021-05-19 上传

2024-12-08 上传

2021-05-19 上传