隐马尔科夫模型学习:前向-后向算法与EM算法解析

需积分: 14 133 浏览量

更新于2024-07-21

收藏 1.13MB PDF 举报

"该资源是关于HMM学习的课件,涵盖了如何根据观察序列构建隐马尔科夫模型,以及评估和解码模型的方法。主要讨论了前向-后向算法,包括前向算法、后向算法的概念和计算过程,并提及了与EM算法的关系。此外,还介绍了EM算法的基本原理和在处理不完全数据集中的应用。"

在HMM学习中,我们关注的核心是如何构建和学习模型的参数。隐马尔科夫模型(Hidden Markov Model, HMM)是一种统计建模工具,通常用于处理序列数据,其中一部分信息(隐藏状态)是不可见的,只能通过观察序列间接推断。

**前向算法** 是评估HMM模型适用性的关键工具。它计算了在给定模型和观察序列下,处于特定时间点每个隐藏状态的概率。前向变量`α_t(i)`表示在时间`t`观察到当前序列部分的情况下,处于状态`S_i`的概率。通过递归公式更新这些概率,从时间`1`到`T`,使得我们可以计算整个序列的总概率。

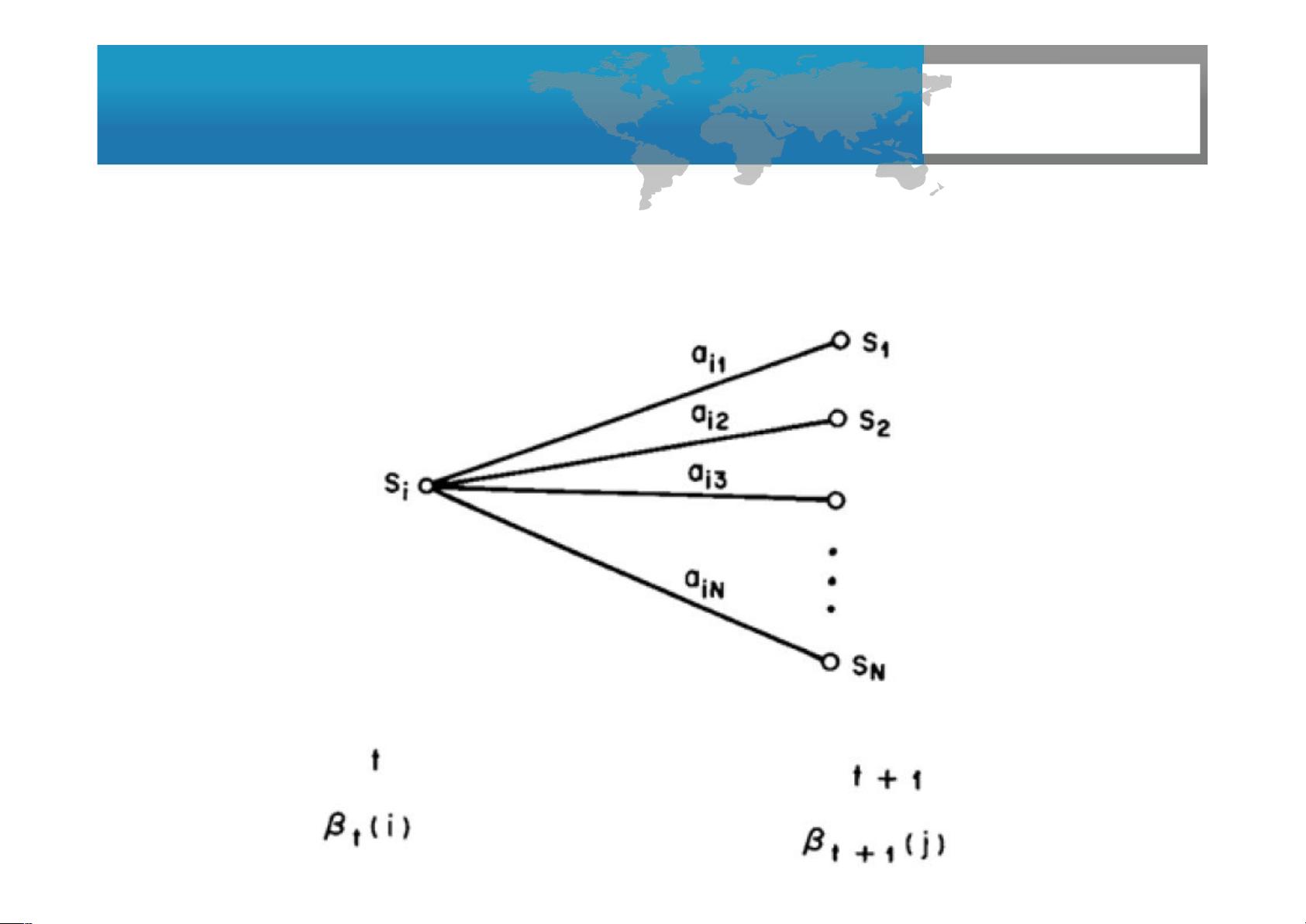

**后向算法** 则是从序列末尾开始反向计算每个状态的后向概率`β_t(i)`,即在时间`t`处于状态`S_i`且观察到后续序列的概率。后向算法的初始化从时间`T`开始,所有状态的`β_t(i)`设为1,然后通过反向传递计算之前的时间点。后向和前向概率结合,可以得到在给定观测序列下,从任意时间点到任意时间点的完整路径概率。

**前向-后向算法** 结合了两者,提供了一种在已知观测序列的情况下估计HMM参数的有效方法,特别是在Baum-Welch算法中。这是一种特殊形式的**期望最大化(Expectation-Maximization, EM)** 算法,用于找到模型参数的最大似然估计。EM算法在有缺失数据或隐藏变量的情况下非常有用,通过迭代E步(计算期望值)和M步(最大化期望值)来逐步优化模型参数。

**EM算法** 包含两个阶段:E步中,我们计算每个样本在当前参数下的期望值;M步中,我们用这些期望值来更新参数,使得数据的似然性增加。这个过程不断重复,直到参数的似然达到极大值,或者满足某个停止条件。

HMM学习问题涉及构建模型,评估模型的适用性,以及解码隐藏状态。前向-后向算法和EM算法是解决这些问题的关键技术,它们在自然语言处理、语音识别、生物信息学等领域有着广泛应用。

2024-08-25 上传

2024-01-06 上传

2023-10-08 上传

2023-08-01 上传

2023-09-06 上传

2024-01-10 上传

2023-09-26 上传

abcheny

- 粉丝: 1

- 资源: 14

最新资源

- C语言快速排序算法的实现与应用

- KityFormula 编辑器压缩包功能解析

- 离线搭建Kubernetes 1.17.0集群教程与资源包分享

- Java毕业设计教学平台完整教程与源码

- 综合数据集汇总:浏览记录与市场研究分析

- STM32智能家居控制系统:创新设计与无线通讯

- 深入浅出C++20标准:四大新特性解析

- Real-ESRGAN: 开源项目提升图像超分辨率技术

- 植物大战僵尸杂交版v2.0.88:新元素新挑战

- 掌握数据分析核心模型,预测未来不是梦

- Android平台蓝牙HC-06/08模块数据交互技巧

- Python源码分享:计算100至200之间的所有素数

- 免费视频修复利器:Digital Video Repair

- Chrome浏览器新版本Adblock Plus插件发布

- GifSplitter:Linux下GIF转BMP的核心工具

- Vue.js开发教程:全面学习资源指南