大规模图神经网络:挑战与优化策略

需积分: 0 197 浏览量

更新于2024-06-19

收藏 1.06MB PDF 举报

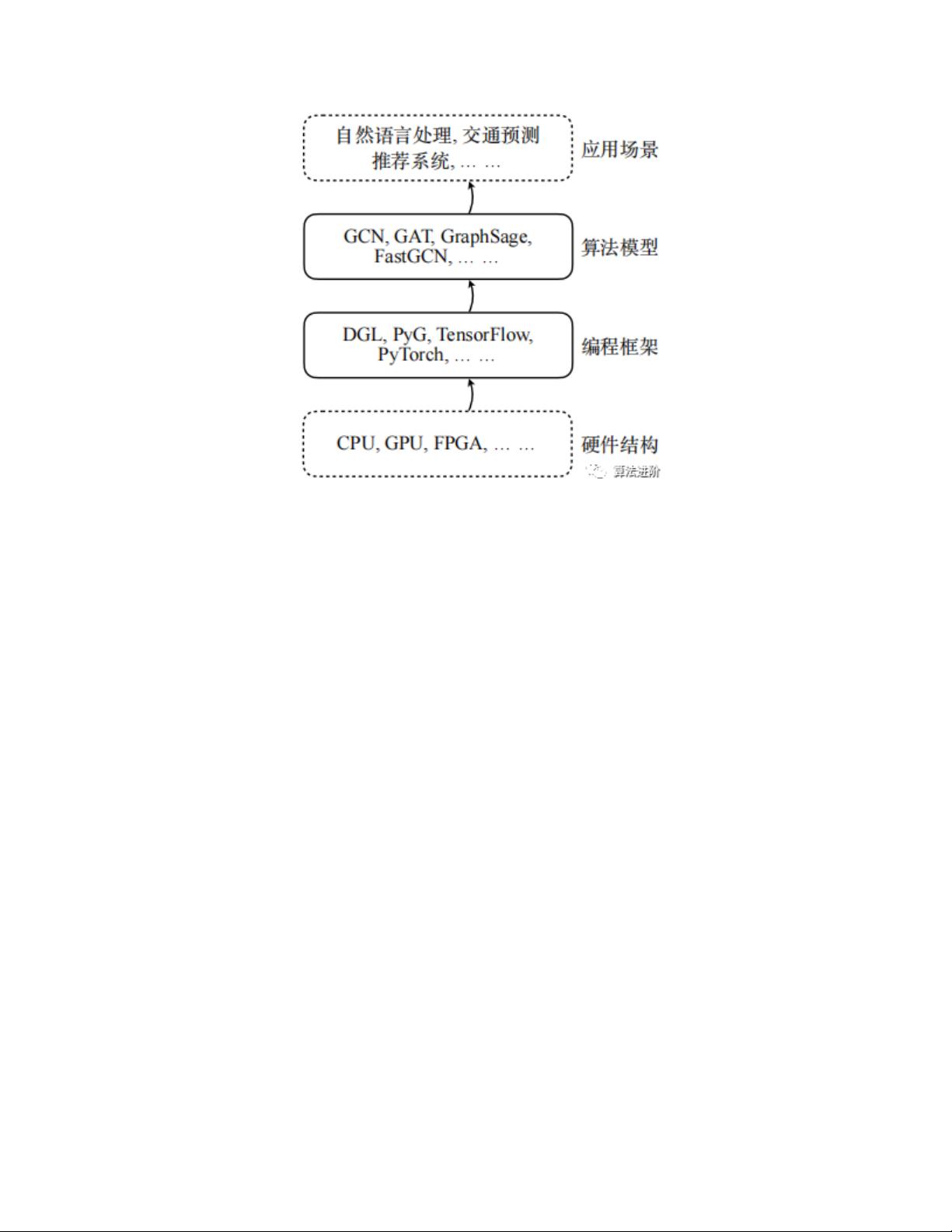

"这篇文档是2023年11月3日发布的关于图神经网络(GNN)的研究综述,主要探讨了GNN在处理非欧几里得空间数据和复杂特征上的应用,以及在大规模数据处理时所面临的挑战。文章提到了GNN在推荐系统、知识图谱和交通分析等领域的重要作用,并分析了模型计算效率、内存管理和分布式系统通信成本的问题。内容涵盖了图神经网络的基本原理、常见模型、大规模数据训练的困难、采样算法以及编程框架的优化技术。"

本文重点讨论了图神经网络在处理复杂图数据时的关键技术和面临的挑战。首先,文章介绍了GNN的核心——消息传递机制,这是一种通过节点之间的交互来传播和聚合信息的方法。常见的GNN模型如GCN(Graph Convolutional Network)、GAT(Graph Attention Network)等,它们在不同的任务中展现出强大的性能。然而,随着数据规模的增加,例如在包含数十亿节点和边的大型图中,GNN的计算和内存需求急剧上升,这导致了计算效率降低和内存管理困难。

在大规模数据训练中,文章提到了几个主要挑战:图数据结构的不规则性、稀疏性和动态性使得高效访问和计算变得复杂;高维节点表示虽然增强了模型表达力,但也增加了计算和内存负担,尤其是在深层网络中;整批训练受限于内存,而分批训练则增加了训练复杂性;现有的硬件平台,如CPU和GPU,难以同时满足不规则数据处理和高性能计算的需求。

为了解决这些问题,文章进一步探讨了针对大规模数据的采样算法,如节点采样、边采样和子图采样,这些方法可以减少计算量,提高训练速度。此外,文章还介绍了图神经网络编程框架的优化技术,包括主流框架的特性,以及如何通过并行计算、内存管理和分布式通信策略来加速GNN的训练。

这篇综述为读者提供了全面的GNN理论知识和实践挑战,对于研究和开发大规模图神经网络模型具有很高的参考价值。它不仅揭示了当前存在的问题,还指出了未来可能的研究方向,如新型采样策略、硬件优化和模型压缩技术,以提升GNN在现实世界复杂问题中的应用效能。

2020-03-31 上传

2023-12-04 上传

2019-10-29 上传

2021-09-21 上传

2022-01-14 上传

2021-09-25 上传

2021-09-25 上传

白话机器学习

- 粉丝: 1w+

- 资源: 7673

最新资源

- StarModAPI: StarMade 模组开发的Java API工具包

- PHP疫情上报管理系统开发与数据库实现详解

- 中秋节特献:明月祝福Flash动画素材

- Java GUI界面RPi-kee_Pilot:RPi-kee专用控制工具

- 电脑端APK信息提取工具APK Messenger功能介绍

- 探索矩阵连乘算法在C++中的应用

- Airflow教程:入门到工作流程创建

- MIP在Matlab中实现黑白图像处理的开源解决方案

- 图像切割感知分组框架:Matlab中的PG-framework实现

- 计算机科学中的经典算法与应用场景解析

- MiniZinc 编译器:高效解决离散优化问题

- MATLAB工具用于测量静态接触角的开源代码解析

- Python网络服务器项目合作指南

- 使用Matlab实现基础水族馆鱼类跟踪的代码解析

- vagga:基于Rust的用户空间容器化开发工具

- PPAP: 多语言支持的PHP邮政地址解析器项目

已收录资源合集

已收录资源合集