预训练模型在搜索与广告中自然语言生成的应用

版权申诉

148 浏览量

更新于2024-07-05

收藏 5.02MB PDF 举报

该文件主要探讨了基于预训练的自然语言生成技术在搜索与广告领域的应用,特别提到了几个关键的研究成果,包括ProphetNet、增强的知识注入模型、BANG模型、Poolingformer、EL-Attention以及GLGE评估基准。

在自然语言生成(NLG)领域,预训练模型已经成为推动其发展的核心力量。这些模型通过大规模的无监督学习,习得丰富的语言结构和语义知识,进而应用于各种任务,如搜索查询理解、广告文案生成等。以下将详细介绍这些模型和它们的应用:

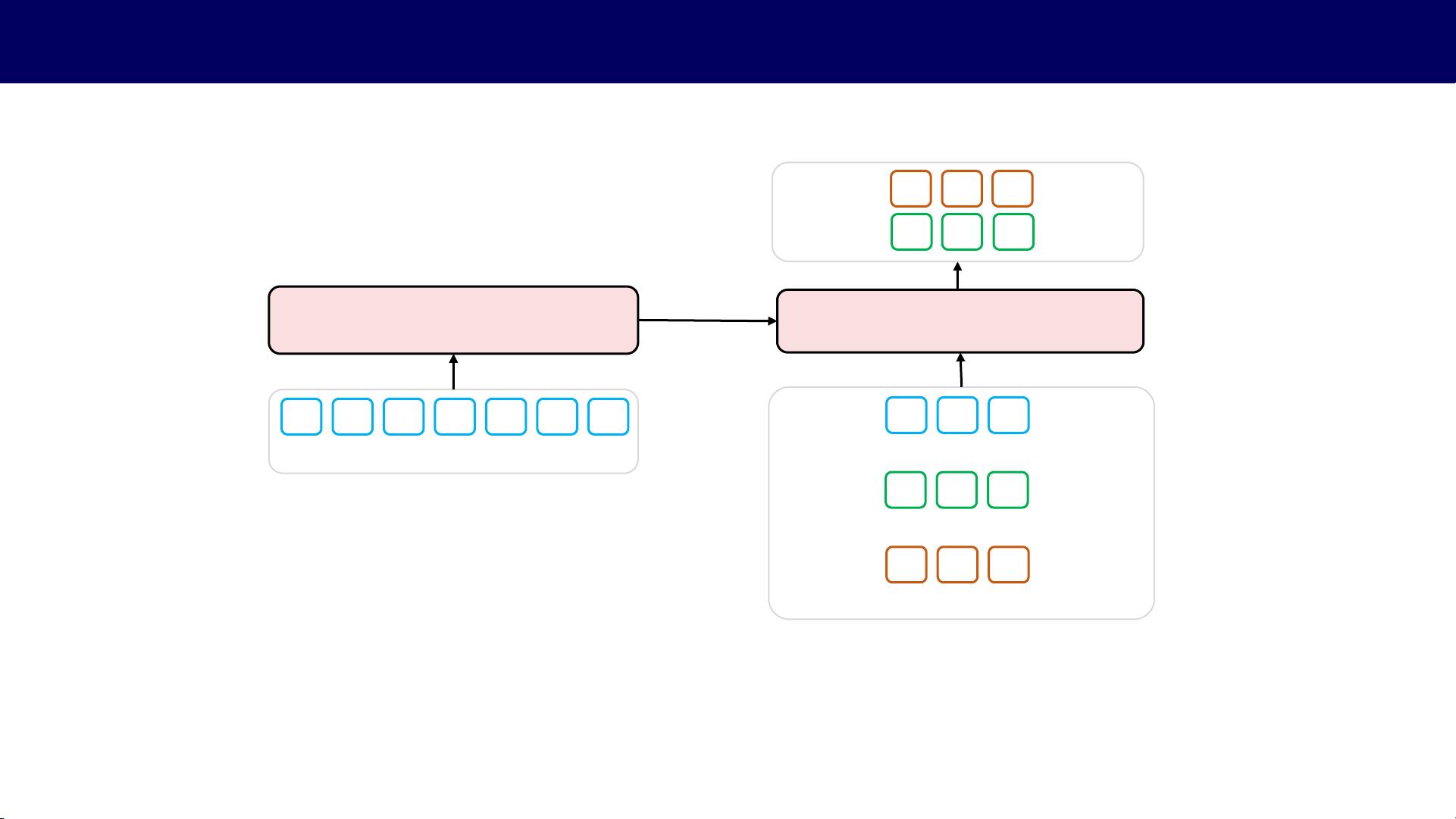

1. ProphetNet:由EMNLP-Findings 2020发表,ProphetNet提出了预测未来n-gram序列到序列预训练方法。它改进了传统的自回归模型,通过预测未来的多个词元,提高了生成的多样性和准确性,这对于搜索结果的个性化和广告创意的创新至关重要。

2. 增强的知识注入模型:在COLING 2020会议上提出,这个模型旨在提升常识生成的能力。在搜索和广告中,理解并利用常识可以提高用户体验,比如生成的广告语更贴近用户期望,搜索结果更准确。

3. BANG:在ICML 2021上介绍,Bridging Autoregressive and Non-autoregressive Generation with Large Scale Pre-training(BANG)模型结合了自回归和非自回归生成的优点,通过大规模预训练解决了长文本生成的效率和质量问题,对于生成长篇幅的搜索结果描述或广告内容非常有用。

4. Poolingformer:同样在ICML 2021上发布,Poolingformer专注于长文档建模,采用池化注意力机制,有效处理长序列信息,这对于理解和生成复杂的搜索查询和广告语境至关重要。

5. EL-Attention:内存高效且无损的注意力机制,用于生成任务。在搜索和广告场景中,快速而准确地处理大量数据是关键,EL-Attention提供了这样的可能性,提高了系统性能。

6. GLGE:一个通用的语言生成评估基准,由ACL-Findings 2021提出。GLGE提供了一套全面的评价标准,有助于评估预训练模型在搜索和广告中的实际效果,确保生成内容的质量和相关性。

总结来说,这些研究展示了预训练模型如何通过创新的架构和方法来提升自然语言生成的质量和效率,从而在搜索和广告领域创造更智能、更具吸引力的服务。从搜索查询的精确匹配到广告文案的创新生成,这些技术正在改变着信息检索和营销的方式。

2023-07-28 上传

2023-07-28 上传

2023-04-05 上传

2023-05-17 上传

2024-02-28 上传

2023-07-10 上传

2024-04-17 上传

普通网友

- 粉丝: 12w+

- 资源: 9195

最新资源

- Hadoop生态系统与MapReduce详解

- MDS系列三相整流桥模块技术规格与特性

- MFC编程:指针与句柄获取全面解析

- LM06:多模4G高速数据模块,支持GSM至TD-LTE

- 使用Gradle与Nexus构建私有仓库

- JAVA编程规范指南:命名规则与文件样式

- EMC VNX5500 存储系统日常维护指南

- 大数据驱动的互联网用户体验深度管理策略

- 改进型Booth算法:32位浮点阵列乘法器的高速设计与算法比较

- H3CNE网络认证重点知识整理

- Linux环境下MongoDB的详细安装教程

- 压缩文法的等价变换与多余规则删除

- BRMS入门指南:JBOSS安装与基础操作详解

- Win7环境下Android开发环境配置全攻略

- SHT10 C语言程序与LCD1602显示实例及精度校准

- 反垃圾邮件技术:现状与前景