神经网络引入与大脑学习机制探索

需积分: 0 42 浏览量

更新于2024-08-04

收藏 1.03MB DOCX 举报

“第4周笔记1,主要涵盖了线性回归、神经网络以及它们之间的对比,同时也涉及矩阵在计算机视觉中的应用、逻辑回归的实际局限性,并介绍了大脑学习与适应的案例。”

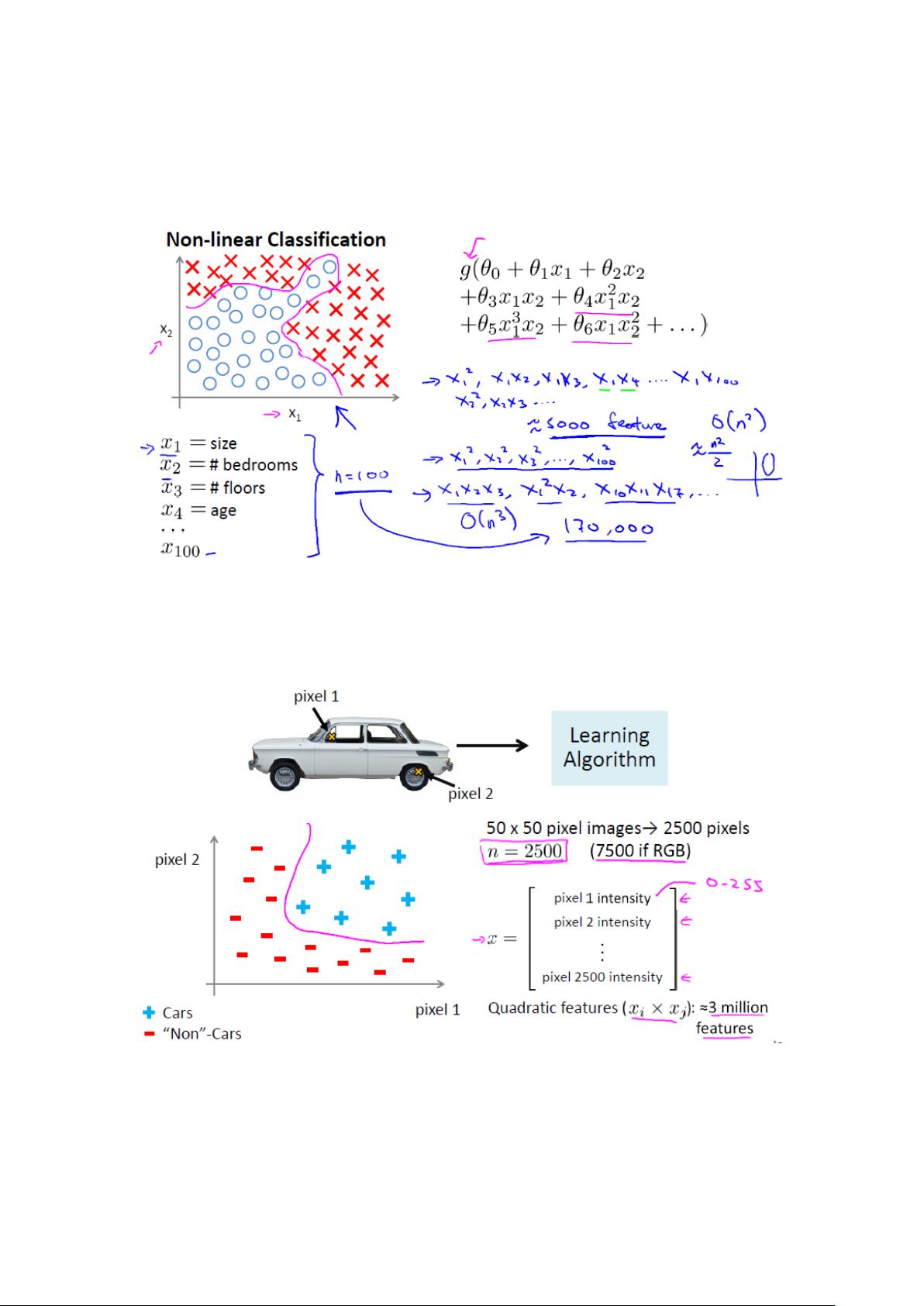

在这一周的学习中,我们深入理解了为什么从线性回归过渡到神经网络是必要的。线性回归虽然在处理简单的线性或近似线性关系时表现良好,但当数据具有非线性特征或者需要考虑多变量交互效应时,其效能便大打折扣。例如,在车辆识别问题中,如果仅依赖于几个特征(如车身的两个像素)进行模型构建,这类似线性回归中的x1和x2,可能还能够应付。然而,对于实际图像,即使是小尺寸的50*50灰度图,包含2500个像素点,直接使用逻辑回归进行分类将变得非常复杂且不可行。

神经网络的出现正是为了解决这个问题。受到大脑神经元结构的启发,神经网络通过多层非线性变换能够捕捉到复杂的模式和特征,使得处理高维度数据成为可能。在视频中提到,即使大脑中原本负责听觉信息的区域,经过重新连接和学习,也能处理视觉信息,这种可塑性揭示了神经网络潜在的强大适应能力。

视频二进一步探讨了神经网络的基本构建单元——神经元模型,其中每个神经元都有一个偏置常量,相当于线性回归中的theta0。通过这种方式,神经网络的每一层可以组合不同的输入,形成复杂的决策边界,从而有效地处理非线性问题。

在模型表示方面,神经网络的假设函数是由多个神经元组成的,每个神经元接收输入信号,经过加权和后通过激活函数转化为输出。神经网络的参数,即权重矩阵θ,其维度可以通过计算输入层和隐藏层节点数量来确定,这为构建和优化复杂模型提供了理论基础。

本周的学习内容强调了线性回归与神经网络的差异,神经网络在处理复杂问题上的优势,以及大脑学习和适应机制如何启发了神经网络的设计。同时,我们了解到在实际应用中,如何利用神经网络解决计算机视觉问题,以及如何通过调整和学习,使系统适应新的任务和挑战。

论文

2023-08-19 上传

2023-09-19 上传

2023-07-29 上传

2023-09-04 上传

2024-09-10 上传

2023-09-16 上传

2023-05-27 上传

郑华滨

- 粉丝: 27

- 资源: 296

最新资源

- Hadoop生态系统与MapReduce详解

- MDS系列三相整流桥模块技术规格与特性

- MFC编程:指针与句柄获取全面解析

- LM06:多模4G高速数据模块,支持GSM至TD-LTE

- 使用Gradle与Nexus构建私有仓库

- JAVA编程规范指南:命名规则与文件样式

- EMC VNX5500 存储系统日常维护指南

- 大数据驱动的互联网用户体验深度管理策略

- 改进型Booth算法:32位浮点阵列乘法器的高速设计与算法比较

- H3CNE网络认证重点知识整理

- Linux环境下MongoDB的详细安装教程

- 压缩文法的等价变换与多余规则删除

- BRMS入门指南:JBOSS安装与基础操作详解

- Win7环境下Android开发环境配置全攻略

- SHT10 C语言程序与LCD1602显示实例及精度校准

- 反垃圾邮件技术:现状与前景