"使用IDEA开发Scala程序,包括创建Spark应用程序,本地及分布式部署"

本文主要介绍了如何使用IntelliJ IDEA开发Spark应用程序,特别是在Scala环境下进行编程。实验目标旨在让学习者掌握IDEA的使用,以及如何开发和部署Spark应用。

首先,实验要求包括使用IntelliJ IDEA创建本地Spark应用程序,并进一步学习如何部署分布式Spark应用程序。这涉及到对IDEA的熟悉,Spark和Scala的集成,以及对分布式计算的理解。

实验环境设定为基于Ubuntu 16.04的操作系统,配备了JDK 1.8,Spark 2.1.0,Hadoop 2.7.1,IntelliJ IDEA版本3.7,以及Scala 2.11.8。这些是开发和运行Spark程序的基本软件需求。

在IDEA中开发Spark程序的步骤如下:

1. 启动IDEA:进入IDEA安装目录,例如`/usr/local/idea/`,运行`./bin/idea.sh`启动IDEA。

2. 创建新项目:选择“File” -> “New” -> “Project”,选择“Maven”,不勾选“Create from archetype”,然后点击“Next”。

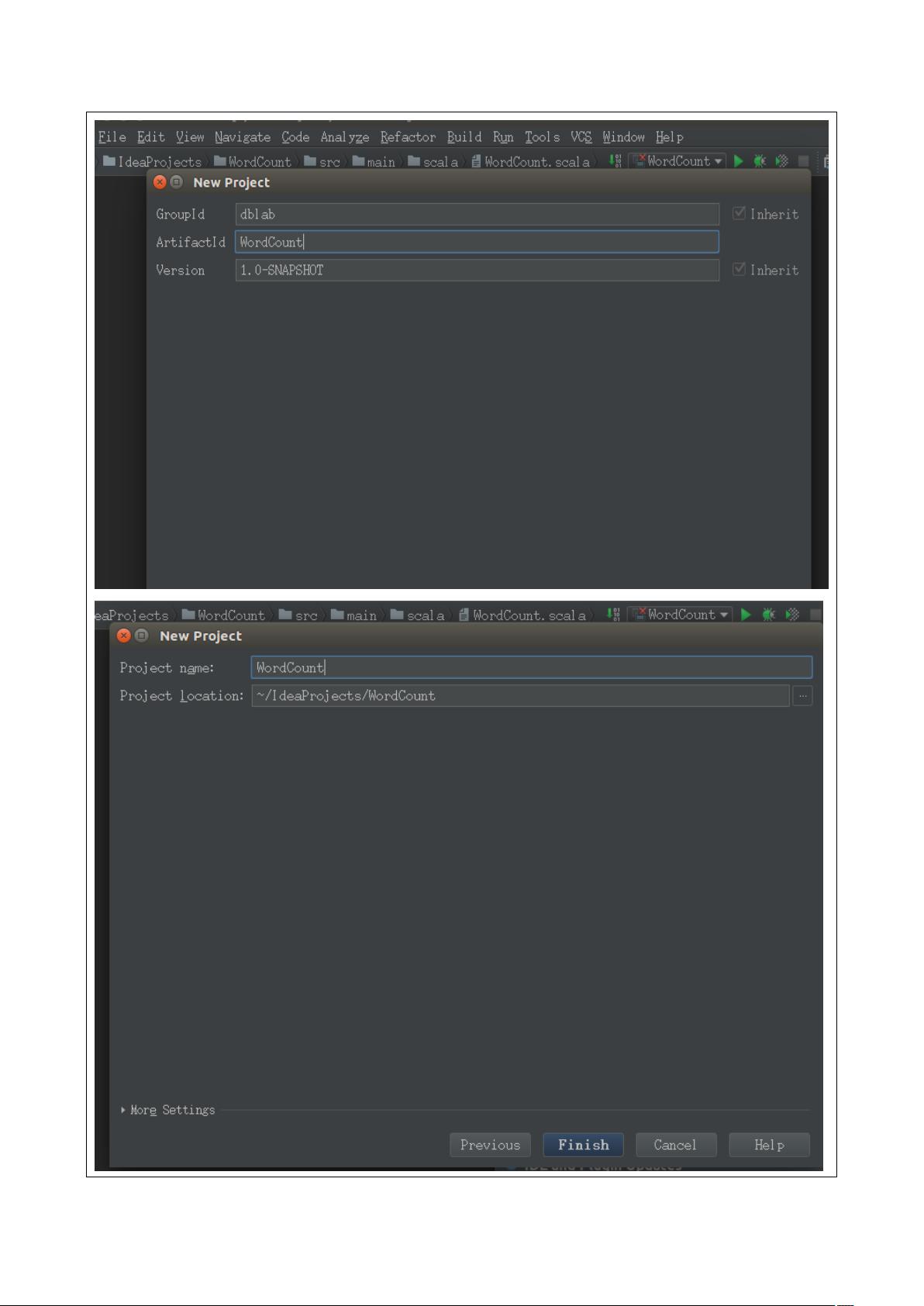

3. 填写项目信息:在“GroupId”中输入“dblab”,“ArtifactId”中输入“WordCount”,然后点击“Next”。确保选中“Enable Auto-Import”以自动处理Maven依赖。

4. 添加Maven配置文件:确保选用正确的Maven配置,以便IDEA能自动下载相关依赖。

5. 添加Scala框架支持:为了开发Spark程序,需要手动导入Spark的jar包。在IDEA中选择相应的选项,将Spark库添加到项目中。

6. 数据准备:在实验目录下(如`/usr/local/spark/mycode/wordcount/`)创建数据文件`word.txt`,用于WordCount示例。

7. 设置项目目录:在IDEA的项目结构中,于“src/main”目录下新建必要的Scala源代码文件夹。

接下来,开发Spark的WordCount程序,这是Spark入门的典型示例,用于统计文本文件中单词出现的次数。程序会读取`word.txt`文件,分词并计算每个单词的频率。

最后,部署Spark应用程序,可以分为本地模式和分布式模式。本地模式下,可以直接在IDEA中运行Spark应用。对于分布式部署,需要配置Spark的Master和Worker节点,通过提交Spark Job到集群来执行。这涉及到对Spark的提交命令(如`spark-submit`)的了解,以及对集群配置的熟悉。

通过这个实验,学生不仅可以学会使用IntelliJ IDEA进行Scala编程,还能理解Spark的本地和分布式运行机制,为后续的大数据处理打下坚实基础。