CentOS集群部署Hadoop详解

需积分: 9 89 浏览量

更新于2024-07-21

收藏 4.19MB DOC 举报

"在CentOS操作系统上安装和配置Hadoop分布式计算平台的过程,包括Hadoop的集群部署、角色划分以及环境说明。"

在安装配置Hadoop的过程中,首先要理解Hadoop的基本概念和架构。Hadoop是一个开源的分布式计算框架,由Apache软件基金会开发。它主要由两个关键组件构成:Hadoop分布式文件系统(HDFS)和MapReduce。HDFS提供了一个高容错性的文件存储系统,而MapReduce则用于处理和生成大数据集。Hadoop的设计目标是允许在廉价硬件上运行,提供高度可扩展性和高吞吐量的数据处理能力。

1. Hadoop集群部署

在一个典型的Hadoop集群中,有Master和Slave两种角色。Master节点包含NameNode和JobTracker,Slave节点包括DataNode和TaskTracker。NameNode是HDFS的元数据管理器,负责维护文件系统的命名空间和访问控制信息。DataNode则是实际存储数据的节点,它们向NameNode报告存储块的状态,并响应来自客户端或其它DataNode的读写请求。JobTracker在MapReduce中起主导作用,它负责任务调度和监控,TaskTracker则执行JobTracker分配的任务。

2. 集群环境说明

这里提到的集群包括1个Master节点和3个Slave节点,所有节点都运行在CentOS6操作系统上,且彼此通过局域网连接,可以互相通信。在配置Hadoop时,必须确保所有节点间网络通畅,且每个节点的IP地址已知。例如,Master节点的IP地址是192.168.1.2,而Slave节点的IP地址分别为192.168.1.3、192.168.1.4和192.168.1.5。

3. 安装步骤

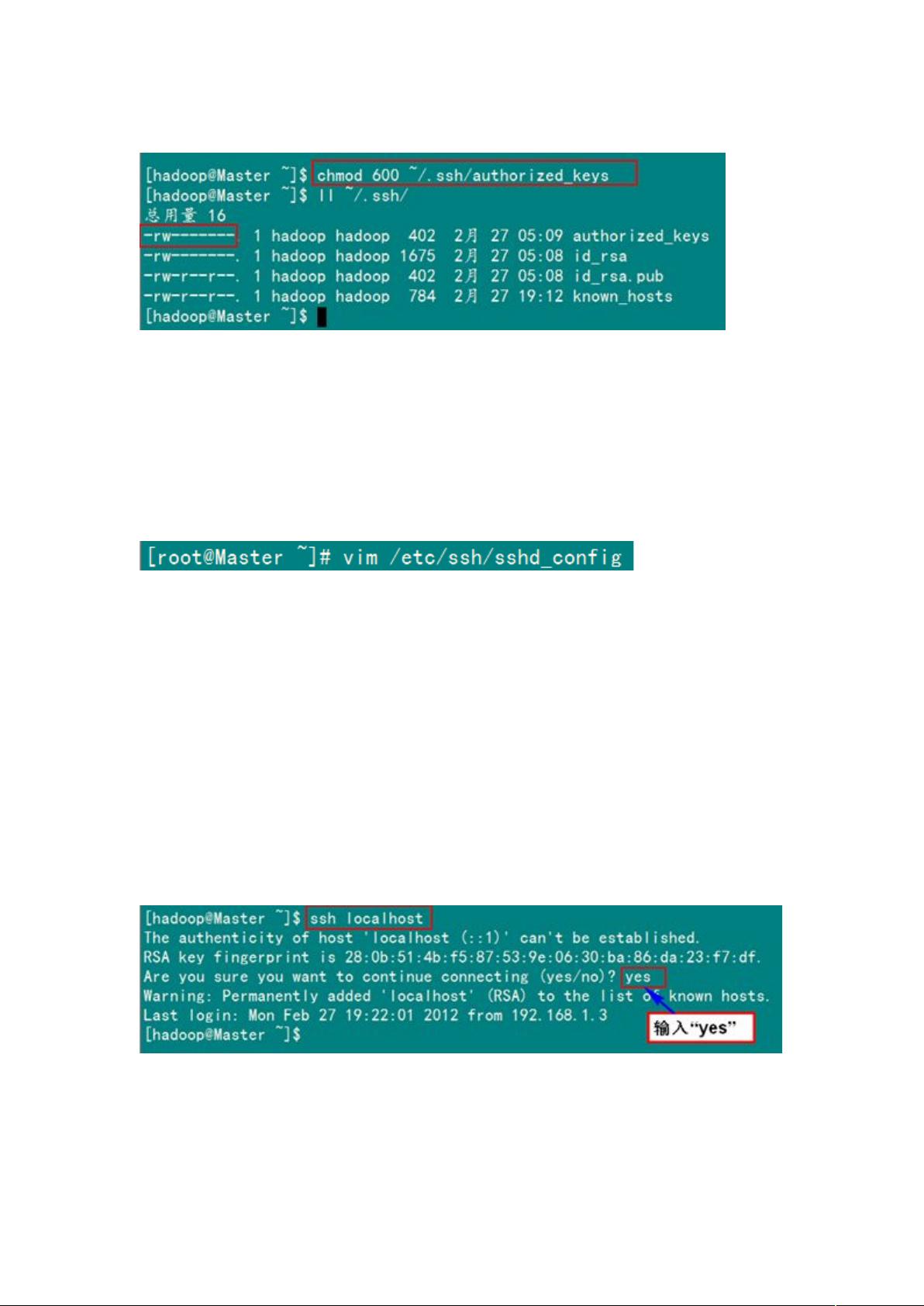

- **基础环境准备**:首先确保所有节点的系统更新到最新,关闭防火墙和SELinux,安装Java运行环境。

- **安装Hadoop**:下载Hadoop的tarball文件,解压并配置环境变量,如`HADOOP_HOME`,添加到`PATH`。

- **配置Hadoop**:修改`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`、`mapred-site.xml`和`yarn-site.xml`等配置文件,设置集群相关参数,如NameNode和DataNode的地址,以及MapReduce的相关配置。

- **格式化NameNode**:首次部署时,需要对NameNode进行格式化,初始化HDFS的元数据。

- **启动Hadoop服务**:依次启动Hadoop的各个服务,包括DataNode、NameNode、SecondaryNameNode、ResourceManager、NodeManager等。

- **验证安装**:通过`hadoop fs -ls`命令检查HDFS是否正常工作,通过`jps`查看各进程是否运行。

4. 配置注意事项

- **安全性**:生产环境中,应考虑启用Hadoop的安全特性,如Kerberos认证,以提高集群的安全性。

- **资源管理**:根据集群硬件资源合理配置HDFS的副本数、Block大小以及MapReduce的任务槽位等。

- **日志管理**:配置日志聚合功能,便于收集和分析节点日志。

- **网络优化**:确保网络配置正确,避免数据传输瓶颈,如调整TCP/IP参数,优化网络带宽使用。

5. 性能调优

- **硬件配置**:根据业务需求,优化硬件配置,如加大内存、增加磁盘I/O性能等。

- **参数调整**:调整Hadoop的内存分配、CPU调度策略、网络缓冲区大小等,以提高处理效率。

- **负载均衡**:确保任务在集群中均匀分布,避免单点过载。

在安装配置完成后,用户可以通过Hadoop提供的接口提交自定义的MapReduce作业,进行大规模的数据处理和分析。理解Hadoop的架构和配置原理对于有效地管理和利用Hadoop集群至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-05-19 上传

2023-08-09 上传

2017-10-19 上传

2019-03-13 上传

点击了解资源详情

点击了解资源详情

ghostangelboys

- 粉丝: 3

- 资源: 14