自然语言处理:话题模型深度解析_LSA, pLSA, LDA

版权申诉

"北大语言学自然语言处理课程的第14章专注于话题模型,包括Latent Semantic Analysis (LSA)、Probabilistic Topic Model、Probabilistic Latent Semantic Analysis (pLSA) 和 Latent Dirichlet Allocation (LDA)。这些模型是用于理解和解析文本数据的关键工具,尤其在信息检索、文本挖掘和自然语言处理领域。课程内容由北大计算语言学研究所提供,旨在深入浅出地引导学生理解话题模型的原理和应用。"

自然语言处理(NLP)是一个复杂的领域,涵盖了多种技术和方法,其中包括话题模型。话题模型是一种统计方法,它试图揭示隐藏在大量文本数据背后的潜在主题或话题。在本课程中,主要介绍了四个重要的话题模型:

1. 潜在语义分析(Latent Semantic Analysis, LSA):

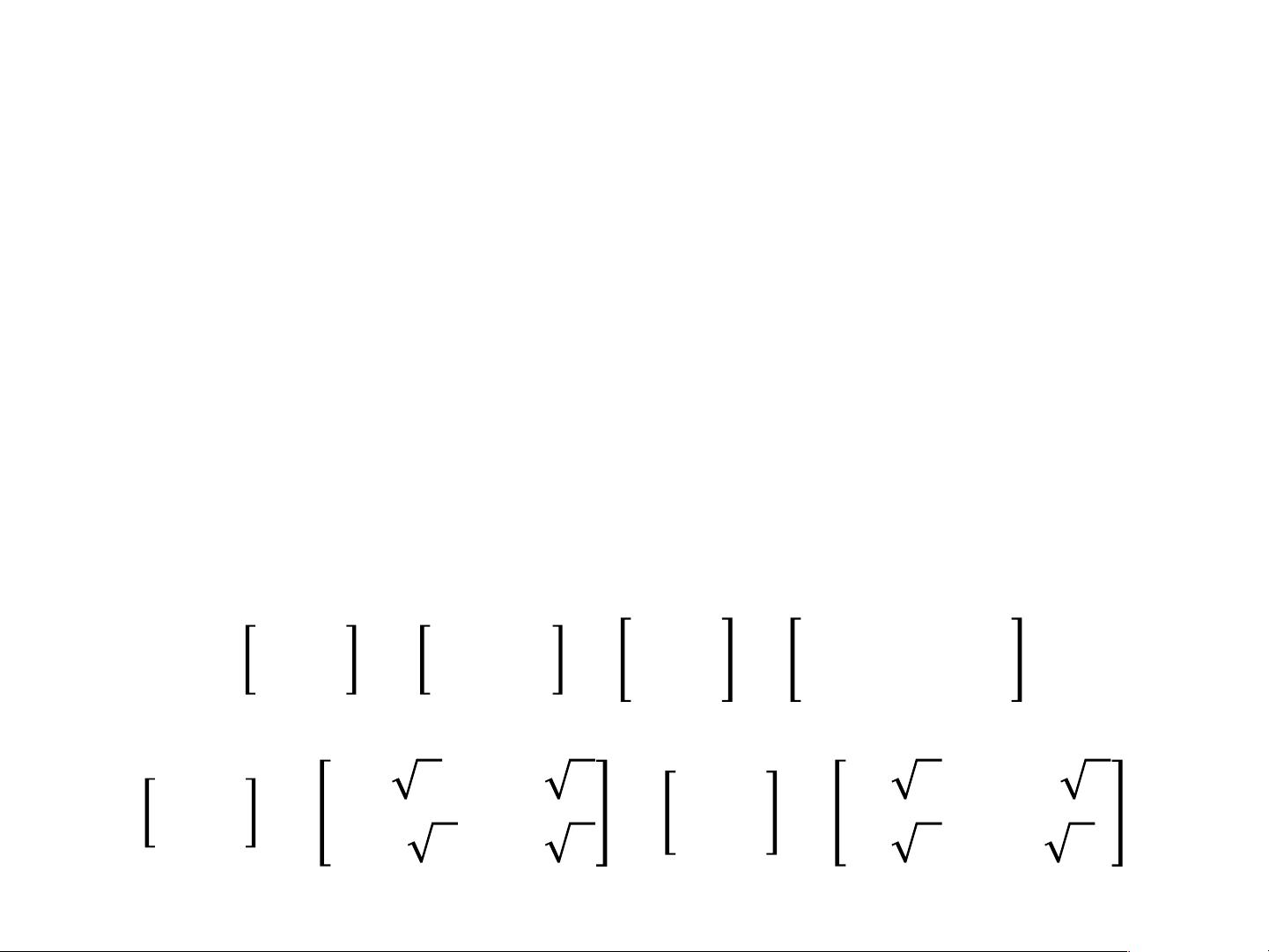

LSA是由Scott Deerwester和Susan Dumais等人在1990年提出的,基于向量空间模型。在向量空间模型中,文档被表示为词项的频率向量。LSA通过奇异值分解(SVD)来转换文档-词项矩阵,将高维的词项空间映射到低维的潜在语义空间,以增强文本之间的相关性,并能捕获词汇的同义关系。这种方法常用于信息检索和文档聚类。

2. 随机话题模型(Probabilistic Topic Model):

这是一个更一般的框架,它使用概率统计来描述文档中词项的生成过程,强调文档是由多个混合话题构成的。

3. 随机潜在语义分析(Probabilistic Latent Semantic Analysis, pLSA):

pLSA是LSA的扩展,引入了概率分布的概念。在这个模型中,每个文档被假设由多个话题组成,每个话题又决定了一组词项的概率分布。pLSA通过迭代优化来估计话题分布和词项分布。

4. 隐含狄利克雷分配(Latent Dirichlet Allocation, LDA):

LDA是pLSA的进一步发展,采用了更复杂的贝叶斯框架。在LDA中,话题被视为文档的先验分布,而词项被视为话题的先验分布。通过 Gibbs Sampling 或 Variational Inference 等方法,LDA可以估计文档、话题和词项的后验概率分布,从而更好地识别文档的主题结构。

这些话题模型在实际应用中具有广泛的价值,如搜索引擎的查询扩展、推荐系统、社交媒体分析等。通过学习这些模型,学生能够掌握如何从大规模文本数据中提取有用信息,理解文本的潜在结构,并应用于实际的自然语言处理任务中。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-04-26 上传

2022-04-26 上传

2022-02-03 上传

2022-04-26 上传

2022-04-26 上传

2022-04-26 上传

passionSnail

- 粉丝: 467

- 资源: 7836

最新资源

- Struts入门--按步骤一步步来就可以了

- 超图2000 说明书

- java笔试题(值得一看)

- C语言常用语法表.doc

- c语言堆和链表.doc

- CoreJava笔记

- ModBus协议(中文pdf文件)

- 基于空域LSB的数字图像加密算法

- Eclipse中文教程

- 关于char (*p)[] 和char p[]的问题

- 《JavaScript语言精髓与编程实践》精选版--动态函数式语言精粹

- RCP程序设计 pdf电子书

- intouch用户说明

- Algorithms in C++, Parts 1-4 (code)

- 敏捷开发:Development Build Grid

- 敏捷开发:电信领域敏捷开发经验分享