Spark还是Flink?基于Kafka的实时计算引擎选择指南

180 浏览量

更新于2024-08-27

收藏 1.37MB PDF 举报

"基于Kafka的实时计算引擎如何选择?SparkorFlink"

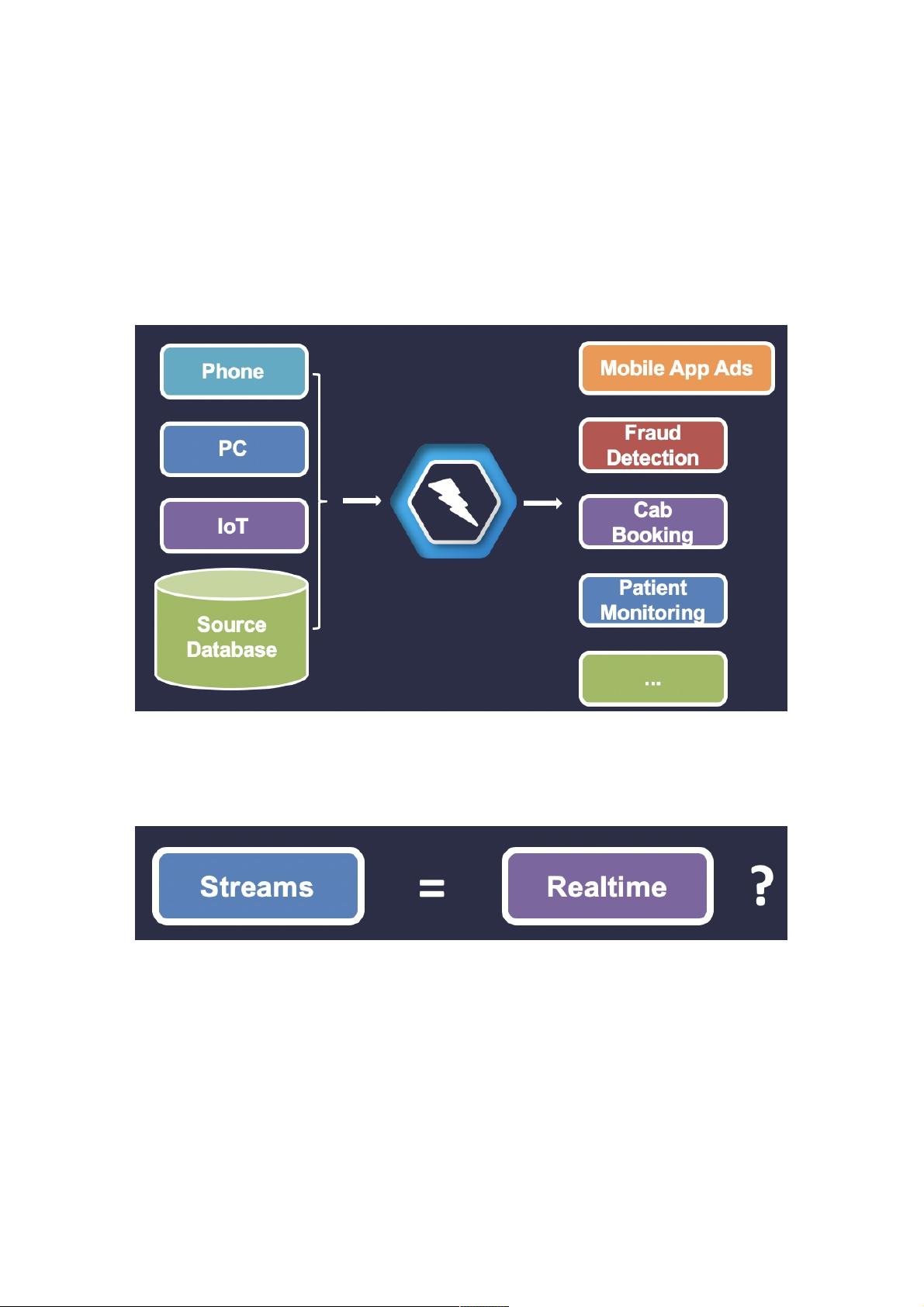

在当前大数据时代,随着新设备、传感器和技术的迅速发展,数据增长速度急剧加快,90%的数据都是在过去两年内产生的。这种趋势使得大数据处理面临更大挑战,尤其是在需要快速响应的实时计算场景中,如广告投放、欺诈检测、交通调度和医疗监护等。Apache Spark和Apache Flink作为Apache基金会的两大实时计算引擎,备受业界关注。

实时计算的核心在于对实时数据的快速处理,以便在短时间内作出决策。流式计算和实时计算虽然常被一起讨论,但两者并不完全相同。实时计算关注处理延迟,而流式计算是一种处理无界数据集的方法,它可以持续处理不断流入的数据,具备容错性、状态管理、高性能和高级功能(如事件时间处理和窗口操作)等特点。

流式处理适合于需要对连续数据流进行快速分析和响应的场景,例如实时异常检测、实时交易监控、物联网设备数据处理等。在这种情况下,流处理系统能迅速识别异常,如金融交易中的欺诈行为,或者在环境监测中及时发现污染峰值。

Apache Spark和Apache Flink都是强大的实时计算引擎,各有特点:

Apache Spark以其易用性、广泛支持的语言(包括Scala、Java、Python和R)和丰富的生态系统而受到青睐。它的核心组件Spark Streaming提供了DStream(Discretized Stream)抽象,可以实现微批处理,适合处理延迟要求不那么严格的场景。Spark还具有强大的Spark SQL和DataFrame/Dataset API,便于数据处理和分析。

相比之下,Apache Flink以其低延迟、高吞吐量和对状态管理的优秀支持而著名,特别适合需要严格实时处理的场景。Flink的DataStream API提供了一种更接近原生流处理的模型,支持事件时间和窗口处理。此外,Flink的容错机制更为强大,可以实现精确一次的状态一致性,这对于某些业务至关重要。

在选择基于Kafka的实时计算引擎时,需要考虑以下几个因素:

1. **延迟要求**:如果业务对延迟极其敏感,Flink可能是更好的选择,因为它的处理延迟通常低于Spark Streaming。

2. **状态管理**:如果需要处理有状态的数据流,Flink提供的状态管理能力更为出色。

3. **生态系统和社区支持**:Spark拥有庞大的开发者社区和丰富的第三方库,这可能对项目的开发和维护带来便利。

4. **数据处理的复杂性**:如果涉及复杂的流处理逻辑,如事件时间窗口、状态转换等,Flink的API可能更适合。

5. **资源利用率和扩展性**:两者的资源管理和扩展性都很强,但在特定环境下,可能需要根据实际测试结果来判断哪个更优。

因此,选择Spark还是Flink,需要根据具体的业务需求、团队的技术栈、系统扩展性和资源约束来综合考量。在实际项目中,可能还需要考虑其他因素,比如运维难度、成本和现有技术栈的兼容性等。通过全面评估,才能找到最适合项目的实时计算引擎。

2018-06-21 上传

2018-10-09 上传

点击了解资源详情

2023-05-10 上传

2023-04-29 上传

2023-07-16 上传

2024-04-20 上传

2023-06-18 上传

weixin_38657115

- 粉丝: 5

- 资源: 905

最新资源

- Haskell编写的C-Minus编译器针对TM架构实现

- 水电模拟工具HydroElectric开发使用Matlab

- Vue与antd结合的后台管理系统分模块打包技术解析

- 微信小游戏开发新框架:SFramework_LayaAir

- AFO算法与GA/PSO在多式联运路径优化中的应用研究

- MapleLeaflet:Ruby中构建Leaflet.js地图的简易工具

- FontForge安装包下载指南

- 个人博客系统开发:设计、安全与管理功能解析

- SmartWiki-AmazeUI风格:自定义Markdown Wiki系统

- USB虚拟串口驱动助力刻字机高效运行

- 加拿大早期种子投资通用条款清单详解

- SSM与Layui结合的汽车租赁系统

- 探索混沌与精英引导结合的鲸鱼优化算法

- Scala教程详解:代码实例与实践操作指南

- Rails 4.0+ 资产管道集成 Handlebars.js 实例解析

- Python实现Spark计算矩阵向量的余弦相似度