深度学习中的循环神经网络(RNN)原理与应用

需积分: 0 199 浏览量

更新于2024-07-01

收藏 5.46MB PDF 举报

本资源主要介绍了循环神经网络(RNN)的基础知识,包括其应用场景、结构特点、与其它类型神经网络的对比,以及解决梯度消失问题的LSTM模型和相关扩展模型。

第六章循环神经网络(RNN)是深度学习中的一个重要组成部分,主要用于处理序列数据,如文本、语音等。RNNs的设计理念在于它们具有记忆能力,能够处理输入序列的依赖关系。在传统的前馈神经网络(FNNs)中,每个时间步的计算相互独立,无法捕捉序列信息,而RNN则通过在时间维度上共享权重来解决这个问题。

6.1为什么需要RNN?因为许多实际问题涉及到序列数据的处理,如自然语言处理(NLP)、语音识别、机器翻译等,RNN能有效地处理这些任务,因为它可以记住之前的上下文信息。

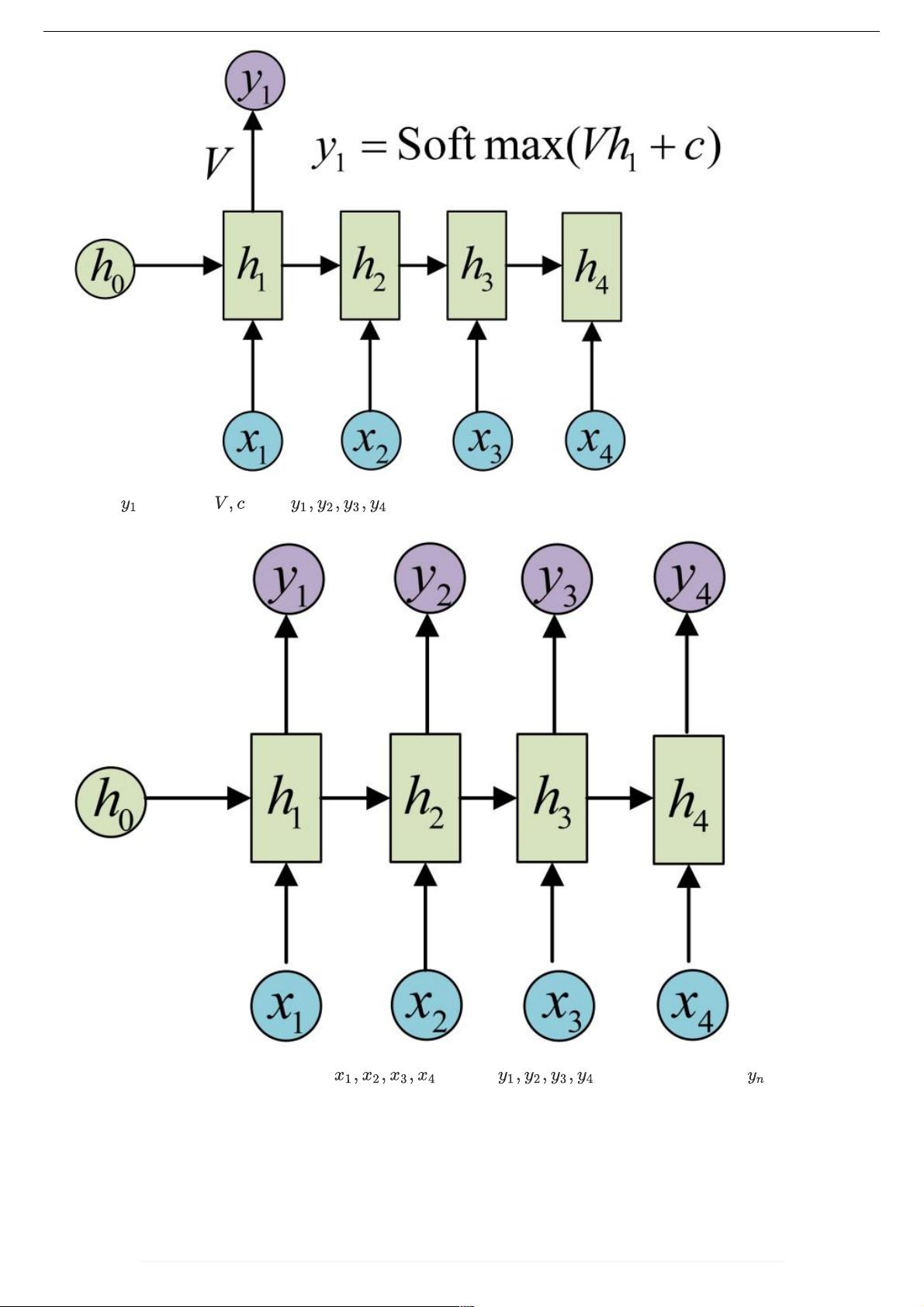

6.2 RNN的基本结构包括单层网络结构、经典RNN结构、vector-to-sequence结构、sequence-to-vector结构以及Encoder-Decoder结构。Encoder-Decoder结构常用于序列到序列的转换任务,如机器翻译,其中Encoder负责编码输入序列,Decoder负责生成输出序列。

6.3 RNNs的特点包括其内部状态(或称为隐藏状态)能够捕捉序列历史信息,但同时也存在梯度消失和梯度爆炸的问题,这使得在训练过程中学习长期依赖变得困难。

6.4 CNN(卷积神经网络)和RNN的主要区别在于CNN擅长处理空间上的局部相关性,而RNN则擅长处理时间序列上的依赖关系。

6.5 RNNs与FNNs的主要区别在于RNN在网络结构中引入了时间维度,允许信息在序列中流动,而FNN则是静态的,不考虑输入顺序。

6.6 RNN训练与传统ANN(前馈神经网络)训练的不同之处在于RNN需要考虑时间步之间的依赖,导致反向传播(BPTT)算法更为复杂,损失函数的波动也更大。

6.7 梯度消失问题在RNN中常见,由于反向传播过程中权重的连乘效应,导致远期依赖的梯度几乎消失,影响学习效果。

6.8 LSTM(长短期记忆网络)是为了解决RNN中的梯度消失问题而提出的,它通过引入门控机制来控制信息的流动,保持长期依赖。

6.9 LSTM的核心思想是使用输入门、遗忘门和输出门来控制单元状态的更新,有效地解决了RNN中梯度消失的问题。

6.10 LSTM的变体包括GRU(门控循环单元),以及其他如双向LSTM、堆叠LSTM、钟控RNN(CW-RNNs)、CNN-LSTM等,这些模型在不同场景下各有优势。

6.13 RNNs在NLP中的典型应用包括语言建模、情感分析、机器翻译等。常见的RNN扩展模型如双向RNNs能同时利用前后文信息,深RNNs增加了网络的深度,而Echo State Networks(ESNs)和Gated Recurrent Unit(GRUs)等提供了更高效的计算方式。

总结来说,RNN是一种强大的工具,尤其适用于处理序列数据,而LSTM和GRU等变体则通过改进结构来克服RNN训练中的挑战,进一步提升了处理序列任务的能力。在实际应用中,选择合适的RNN结构和变体对于优化模型性能至关重要。

2022-08-03 上传

2022-08-04 上传

2020-07-27 上传

2022-08-03 上传

点击了解资源详情

2021-02-24 上传

2020-09-20 上传

点击了解资源详情