Lucene实战:全文检索与中文分词应用

需积分: 4 30 浏览量

更新于2024-07-19

收藏 860KB DOCX 举报

"Lucene笔记,包括Lucene介绍、应用场景、实现全文检索的流程、入门程序、Field域、索引维护、搜索、相关度排序和中文分词器等内容。"

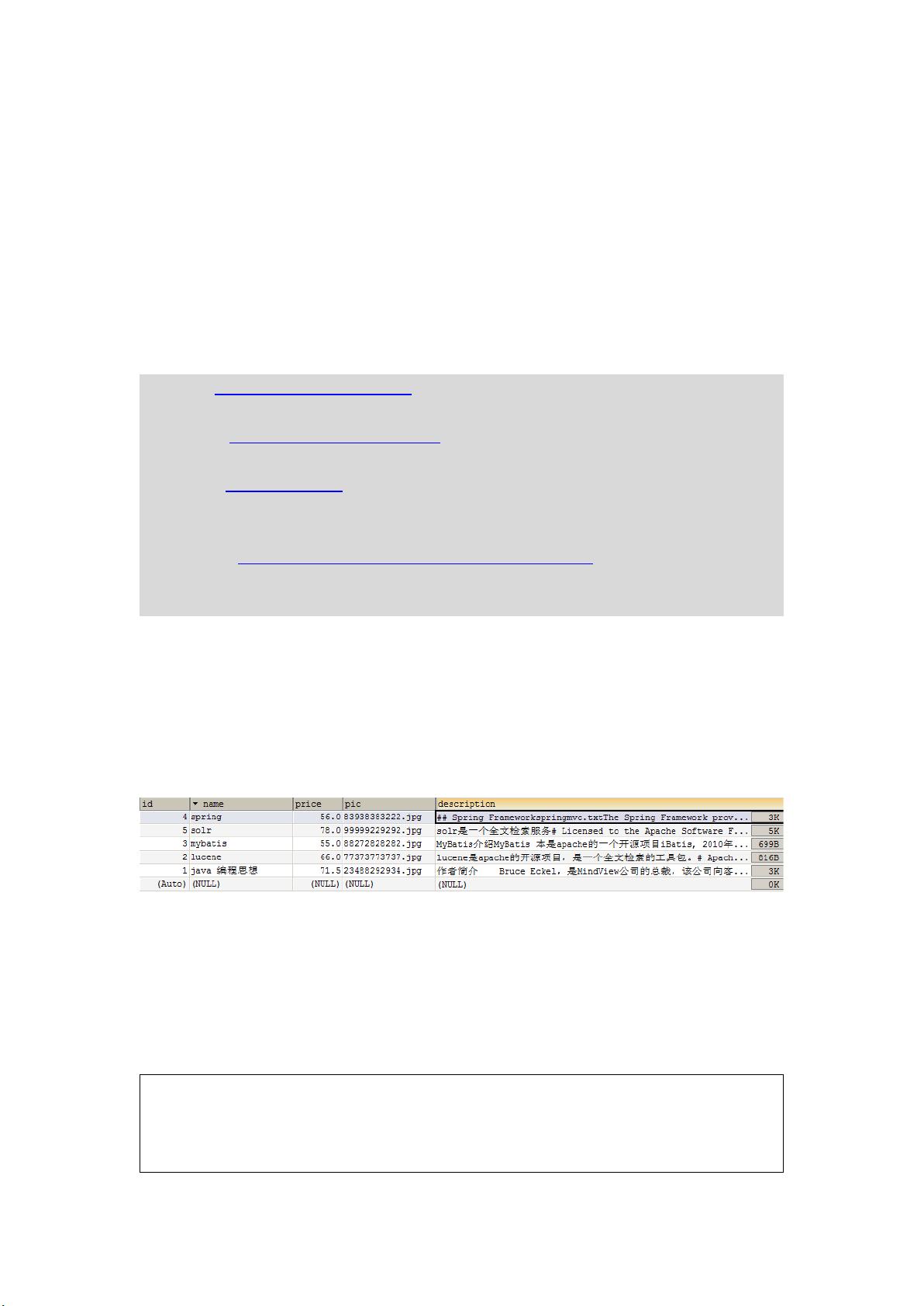

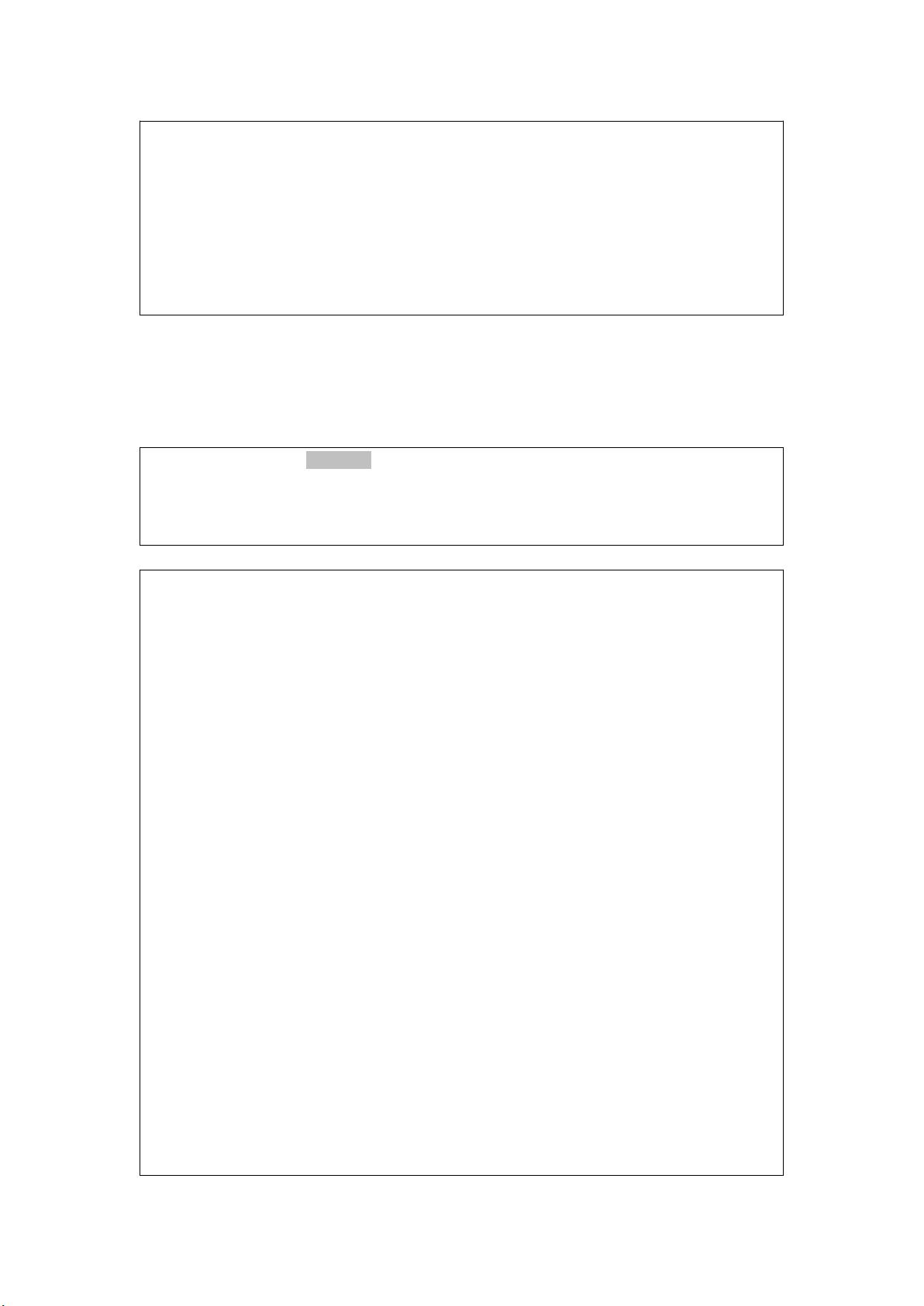

Lucene是一个由Apache软件基金会开发的开放源代码全文检索引擎工具包。它提供了高级的索引和搜索功能,使得开发人员能够方便地在自己的应用程序中集成全文检索功能。Lucene不仅是一个搜索引擎,更是一个库,开发者可以利用它来构建自己的搜索引擎应用。

全文检索在许多场景中都非常有用,例如搜索引擎,如Google和Bing,以及站内搜索,这在电子商务平台、知识库、论坛等中尤其重要。全文检索的核心在于通过提取文档中的词汇并创建索引来实现快速查找。当用户输入查询时,搜索引擎会查询这个索引而不是直接扫描所有文档,从而提高搜索效率。

实现Lucene全文检索的流程主要包括两个阶段:索引流程和搜索流程。索引流程涉及数据采集、文档分析(分词)、索引创建。在数据采集阶段,需要获取待搜索的数据;分析文档是指使用分词器将文本拆分成可搜索的词汇;创建索引则将这些词汇存储到索引库中。搜索流程包括用户输入查询,生成查询对象,执行搜索,最后从索引库中找到匹配结果并返回给用户。

在Lucene中,`Field`域是文档中的一个字段,用于存储不同类型的数据,如标题、内容、作者等,并且每个字段可以有不同的分析和索引策略。索引维护包括添加新索引、删除现有索引以及更新已有索引,这些都是在数据发生变化时必要的操作。

搜索部分,可以通过`Query`子类或者`QueryParser`创建查询对象。`QueryParser`允许用户使用自然语言形式的查询字符串,而`Query`子类则提供了更底层的控制,可以创建更复杂的查询条件。

相关度排序是搜索结果返回的重要部分,Lucene使用TF-IDF(词频-逆文档频率)算法来计算文档与查询的相关性,返回最相关的搜索结果。

对于中文分词,由于中文句子没有明显的分隔符,Lucene需要配合特定的中文分词器,如IK Analyzer、HanLP或jieba分词,才能正确地进行分词并建立索引。这些分词器能处理中文的复杂特性,如词语的多义性和歧义,以提高搜索的准确性。

在实际应用中,开发者需要根据具体需求配置和优化这些步骤,比如选择合适的分词器,调整索引和搜索策略,以达到最佳的搜索性能和用户体验。Lucene提供了丰富的API和灵活性,使得开发者能够根据项目的需求进行定制化开发。

2022-10-29 上传

2015-05-10 上传

2020-05-19 上传

2008-11-01 上传

2009-03-20 上传

2010-02-28 上传

2010-09-13 上传

Salasnun

- 粉丝: 2

- 资源: 15

最新资源

- 探索数据转换实验平台在设备装置中的应用

- 使用git-log-to-tikz.py将Git日志转换为TIKZ图形

- 小栗子源码2.9.3版本发布

- 使用Tinder-Hack-Client实现Tinder API交互

- Android Studio新模板:个性化Material Design导航抽屉

- React API分页模块:数据获取与页面管理

- C语言实现顺序表的动态分配方法

- 光催化分解水产氢固溶体催化剂制备技术揭秘

- VS2013环境下tinyxml库的32位与64位编译指南

- 网易云歌词情感分析系统实现与架构

- React应用展示GitHub用户详细信息及项目分析

- LayUI2.1.6帮助文档API功能详解

- 全栈开发实现的chatgpt应用可打包小程序/H5/App

- C++实现顺序表的动态内存分配技术

- Java制作水果格斗游戏:策略与随机性的结合

- 基于若依框架的后台管理系统开发实例解析