Tensorflow数据读取:预加载、喂养与文件读取解析

17 浏览量

更新于2024-08-29

收藏 163KB PDF 举报

"本文主要介绍了TensorFlow数据读取的三种方式:预加载数据、通过Python喂数据和直接从文件读取。文章详细解释了每种方法的工作原理和优缺点,并结合TensorFlow的工作机制进行了解析。"

在TensorFlow中,数据读取是一个关键步骤,它对训练模型的效率和性能有着直接影响。以下是三种数据读取方式的详细说明:

1. **预加载数据**:

在预加载数据的方式中,我们将数据直接内嵌到TensorFlow的计算图(Graph)中。例如,通过`tf.constant()`创建常量张量,数据在构建图时就被确定。这种方式简洁明了,适用于小规模数据。然而,当数据量大时,由于整个Graph包含了大量的数据,这可能导致内存压力和效率问题,因为Graph的大小会随着数据量的增加而增加,同时在传输Graph到Session时可能会变得缓慢。

2. **通过Python产生数据并喂给后端(Feeding)**:

使用`tf.placeholder()`创建占位符张量,它们在运行时通过`sess.run()`的`feed_dict`参数接收Python中产生的数据。这种方式更灵活,可以在运行时动态输入数据,尤其适合处理动态大小或不确定的数据集。然而,每次运行`sess.run()`都需要提供`feed_dict`,增加了代码的复杂性和运行时间,对于大规模数据处理也可能不高效。

3. **直接从文件读取**:

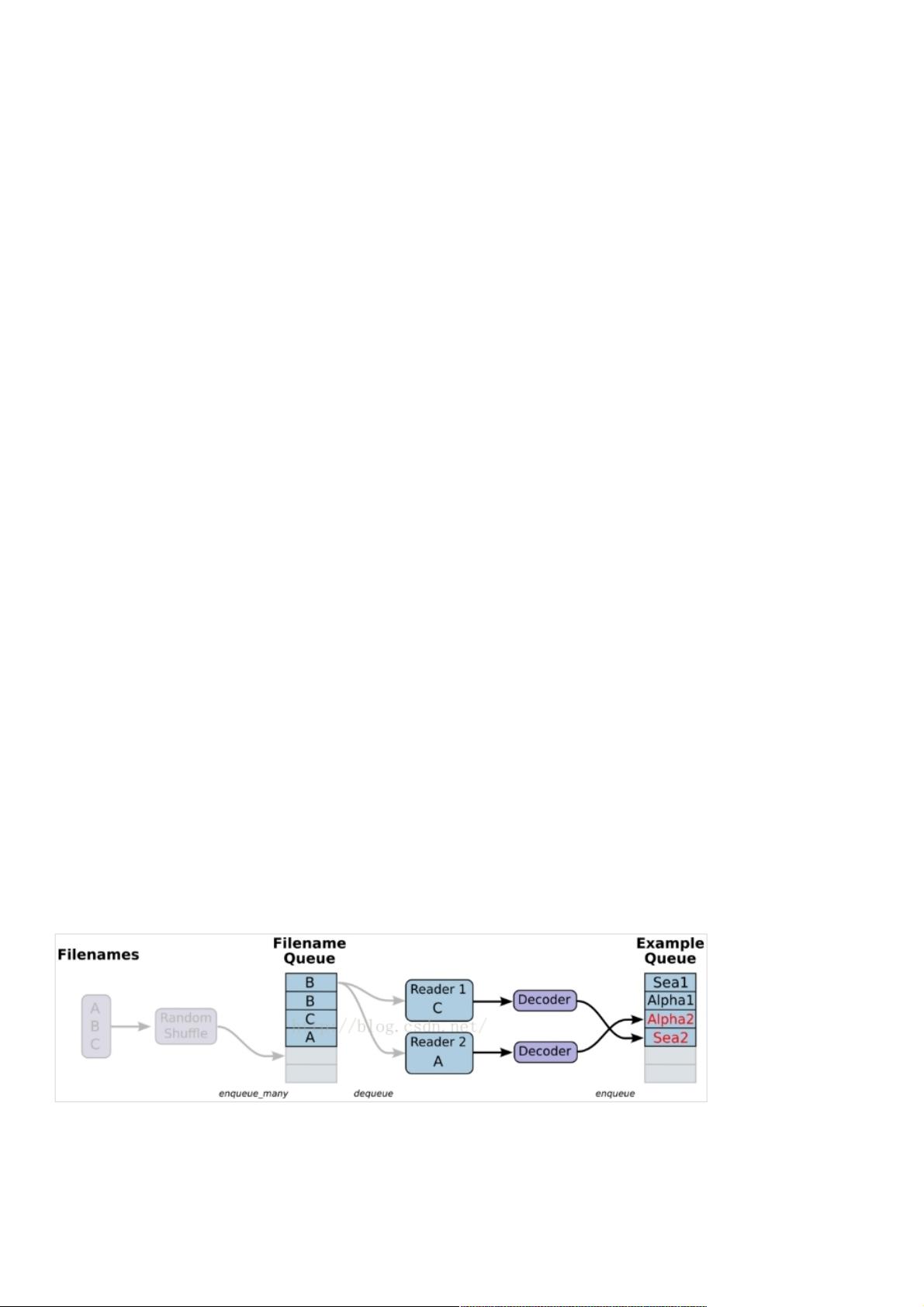

TensorFlow提供了直接从文件读取数据的能力,如`tfrecords`文件格式,这是一种高效的存储和读取大量数据的方式。文件读取操作可以在C++后端执行,避免了Python的内存限制和速度瓶颈。这种方式更适合处理大数据集,可以利用多线程和多进程提高读取速度,但需要编写额外的代码来实现数据的序列化和反序列化。

每种方法都有其适用场景,选择哪种方式取决于数据的大小、处理需求以及性能要求。在实际应用中,通常会结合使用这些方法,比如预加载小规模验证集,通过Python喂食训练数据,或者在生产环境中直接从文件流式加载数据。

理解TensorFlow的工作模式也很重要。Python用于设计计算图,提供高级接口和灵活性,而C++后端则负责高效地执行计算图。这种分离使得TensorFlow能充分利用两种语言的优点,但在处理大规模数据时,需要合理设计数据读取策略以避免性能瓶颈。

在面临大型数据集时,可以考虑使用队列(Queues)和数据加载器(Data Loaders)等工具,它们能够异步加载数据,减少等待时间,提高整体效率。此外,使用数据增强(Data Augmentation)可以进一步优化处理流程,增加模型的泛化能力。选择合适的数据读取策略对于优化TensorFlow模型的训练过程至关重要。

1238 浏览量

431 浏览量

156 浏览量

175 浏览量

2023-09-01 上传

144 浏览量

2023-06-07 上传

108 浏览量

weixin_38577648

- 粉丝: 3

最新资源

- 教学专用变压器设计文档解析与应用

- 森锐最新版身份证阅读软件发布,支持多终端系统

- 墨西哥漫画艺术研究:鲁斯与战斗漫画家

- 安川SGDV-R70F01A伺服驱动器异常处理与输入回路安全指南

- 使用Openclassroom开发后备箱项目

- 快速实现zbar二维码扫描应用

- Matlab实现人口预测:从指数增长到阻滞增长模型分析

- 创意小清新彩虹主题响应式前台模板

- 打造个性化的文本编辑器工具

- 特拉维斯与地形自动化工具Terraform的整合

- 轿车底盘提升平台设计装置的技术文档

- 绿色汉化版ProcDump32 v1.62中文终极版发布

- FusionCMS快速下载器:使用CLI安装最新版本

- DWZ图标拓展工具:提升审美体验

- 纸基摩擦盘设计与拖拉机制动器应用研究

- Android App自动更新功能的实现方法