百度数据工厂:从Hive到Spark的流式转型与实战架构

需积分: 18 27 浏览量

更新于2023-05-17

收藏 718KB PDF 举报

百度数据工厂是一个综合性的数据处理平台,旨在通过整合多元化的解决方案,满足企业对复杂分析、实时处理和数据挖掘的需求。最初,平台依赖于Hive引擎进行离线批量数据分析和大规模PB级数据查询,主要处理核心报表数据。然而,在业务推广过程中,用户对于实时性和灵活性的需求日益增长。

为适应这种变化,百度引入了Spark技术。在Spark 1.0版本时,数据工厂开始尝试Spark Streaming,尽管当时的Spark Streaming API与批处理API不完全同步。随着Spark的发展,到了2.2和2.3版本,Spark推出了StructStreaming,这一升级使得流处理API与批处理API趋于一致,从而实现了数据处理架构的重大升级。在这个新架构中,百度将Hive的功能无缝融入了Spark,构建了一个统一的计算引擎,支持多种提交方式和安全管理,强化了平台的灵活性和安全性。

此外,数据工厂还包含了统一的元数据管理,无论是文件类型还是结构化数据(如Hive或MySQL)的元数据,都被集中处理,提供了一致的视图。资源调度方面,平台支持用户注册和选择执行队列,可无缝对接Kubernetes等容器编排系统。在计算层面,Spark引擎是核心,提供了SQL和Dataset API,支持复杂的处理任务。工作空间则由Jupyter和自研的调度工具构成,同时,还有一套专门设计的流式计算作业处理系统,确保高效和灵活的数据处理流程。

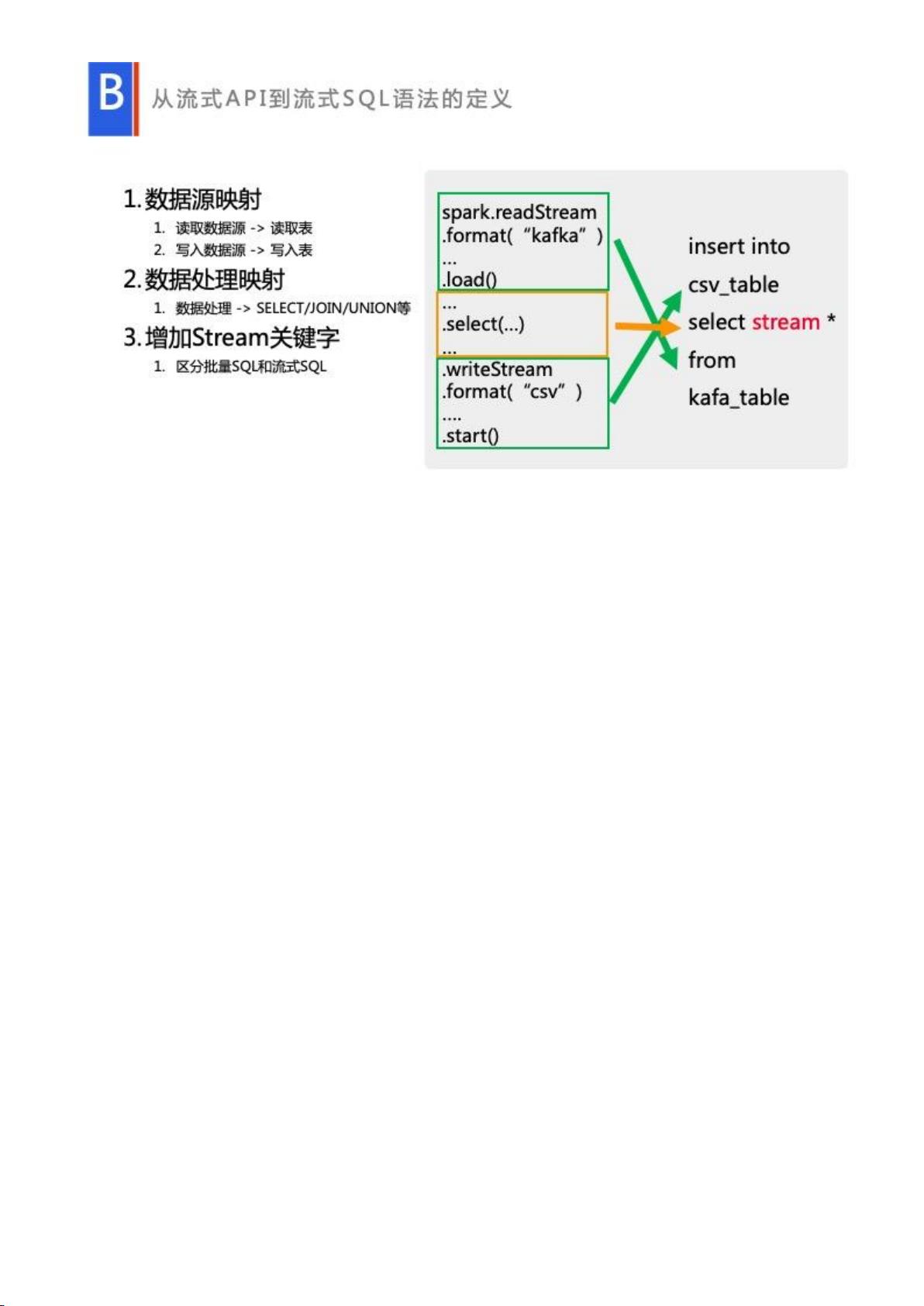

在实际应用中,百度在Spark流批处理上着重解决了几个关键问题,如Spark流式SQL的优化、实时数据转换为离线分析以及实时数据可视化的实时转大屏展示。虽然Spark自身提供了完整的API用于流和批处理分析,但用户在转型过程中可能还需要额外的语义分析和语法优化功能,这是当前Spark尚待完善的部分。

百度数据工厂通过引入和融合Spark技术,打造了一个全面且高度集成的数据处理平台,不仅满足了传统离线分析需求,还能处理实时数据,实现高效的数据处理和分析,推动企业的数字化转型。

点击了解资源详情

点击了解资源详情

点击了解资源详情

817 浏览量

2021-10-10 上传

138 浏览量

点击了解资源详情

点击了解资源详情

LongLongRiver

- 粉丝: 77

- 资源: 42

最新资源

- 巧用google搜索技术,高效高速搜索

- bash shell英文原版教程

- sg3525涓枃璧勬枡(1).pdf

- 面向对象程序设计vc2

- AdobeInDesginPlugInDevelop

- 大学生求职指南精华版

- Klette R., Rosenfeld A. Digital Geometry.. Geometric Methods for Digital Image Analysis (Morgan Kaufmann, 2004)

- LM311.pdf技术资料

- Beginning Linux Programming (4nd edn)

- 如何获取中文的拼音字母

- IBM DB2通用数据库Windows版快速入门.pdf

- dos通用命令dos通用命令

- ArcObject入门教程

- 基于FPGA的神经网络自整定PID控制器设计

- 约束Delaunay三角剖分动态算法研究

- java基础习题集,非常不错的东东