理解Kafka:架构、原理与核心API

23 浏览量

更新于2024-08-27

收藏 475KB PDF 举报

"本文主要介绍了Kafka的基本架构与工作原理,包括Kafka的四个核心API,服务器组件(Broker)、主题(Topic)、分区(Partition)以及日志等关键概念。"

Kafka是一个分布式流处理平台,它被设计用来处理大规模实时数据流。其核心功能包括发布订阅记录流、数据持久化和容错能力。Kafka运行在一组服务器上,形成一个高可用的集群,用于存储和传输数据。

1. **核心API**

- **生产者API**:生产者负责将数据发布到Kafka的主题中。它允许应用程序生成记录流并将其发送到一个或多个特定的主题,确保数据的可靠传输。

- **消费者API**:消费者通过订阅主题来消费数据。它们处理从主题接收的记录流,可以是顺序消费,也可以是并行消费,以提高处理效率。

- **Streams API**:Kafka Streams允许应用程序作为流处理器,从一个或多个输入主题读取数据,经过处理后将结果写入一个或多个输出主题,实现数据转换和分析。

- **Connector API**:Kafka Connector用于构建可重用的生产者和消费者,能够连接Kafka主题与其他应用程序或数据系统,如数据库,实现数据同步。

2. **架构组件**

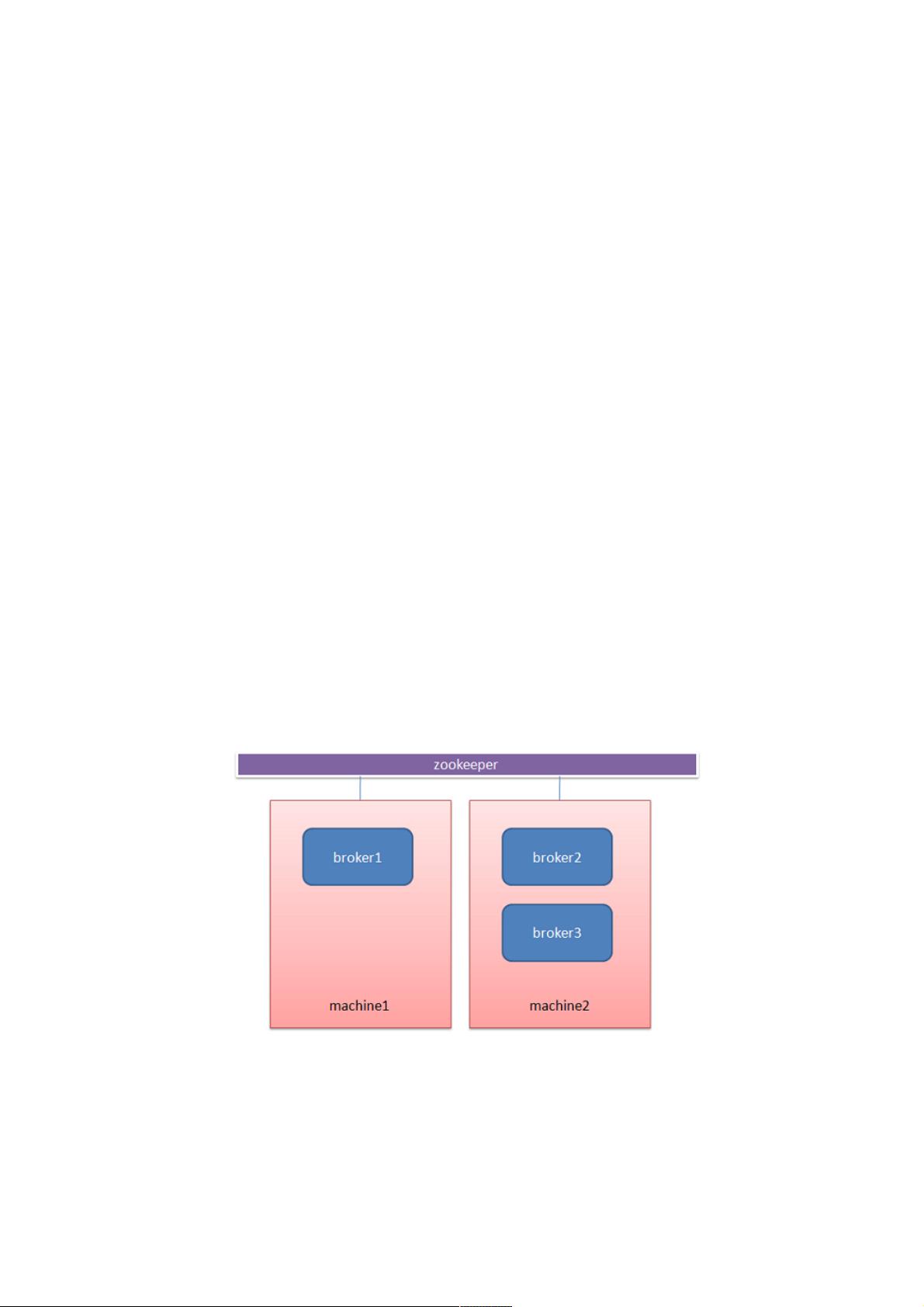

- **Broker**:每个Kafka服务器被称为Broker,多个Broker协同工作构成Kafka集群。Brokers通过ZooKeeper进行协调,保证集群的稳定性和数据一致性。

- **主题(Topic)**:主题是数据的分类,一个主题可以有多个分区,每个分区存储一部分数据。主题可以有多个订阅者,支持多用户订阅。

- **分区(Partition)**:每个主题被划分为多个分区,分布在不同的Broker上,确保负载均衡和水平扩展。每个分区是一个有序且不可变的消息序列,保证消息的顺序性。

- **日志**:每个分区对应一个逻辑日志文件,日志中的消息按照追加的方式添加,保证了消息的顺序。Kafka使用日志来实现数据的持久化,即使在服务器故障时也能恢复数据。

3. **通信与复制**

- **通信协议**:Kafka使用简单、高效的TCP协议与客户端交互,支持多种语言的客户端库。

- **数据复制**:Kafka通过在多个Broker之间复制分区来实现容错。每个分区通常有一个主副本和若干个从副本,主副本负责接收新的消息并将其追加到日志中,从副本则同步主副本的数据,以防主副本失效。

4. **消费者组**:Kafka的消费者采用消费者组的概念,每个组内的消费者可以并行消费主题的分区,提高数据处理速度。同一分区只能被组内一个消费者消费,确保消息的唯一处理。

5. **数据保留策略**:Kafka可以根据配置的策略自动删除旧数据,例如基于时间或存储空间的限制,以保持集群的性能和可用性。

Kafka作为一个高效、可靠的流处理平台,适用于大数据实时分析、日志聚合、事件源等场景,其强大的API和灵活的架构使其在现代大数据环境中广泛应用。理解Kafka的架构和工作原理对于有效地利用这一工具至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-01-27 上传

2021-01-27 上传

2021-10-14 上传

2022-06-09 上传

2021-01-27 上传

weixin_38551431

- 粉丝: 4

- 资源: 898

最新资源

- Python库 | indy-node-dev-1.6.572.tar.gz

- Todo-Web-Application:使用Maven和Bootstrap工具在Java EE中构建

- ASCStuff2018

- 创业计划书-商业计划书模版6

- ShowDC-Map:javascript 画布 HTML 动画

- weixin051畅阅读微信小程序+ssm(源码+部署说明+演示视频+源码介绍+lw).rar

- Windows-7:基于Windows 7外观Linux主题

- 51单片机舵机调试 免费下载

- python游戏源码-09 五子棋.zip源码python项目实例源码打包下载

- 取随机好友赞-易语言.zip

- vscode-arrr:该扩展为您的Angular代码库提供了重构工具

- gallery:jQuery 画廊组件

- 创业计划书-华南理工大学科技园入园企业商业计划书模板

- Easy MCS Gomoku:五子棋AI-开源

- weixin014健身管理系统及会员微信小程序的设计与实现+ssm(源码+部署说明+演示视频+源码介绍+lw).rar

- asgineer:一个非常瘦的ASGI Web框架