Hadoop源码深度解析:HDFS与MapReduce核心组件

需积分: 9 13 浏览量

更新于2024-07-29

1

收藏 6.2MB PDF 举报

Hadoop源码分析深入探讨了Google的分布式计算技术在开源社区的发展,特别是其核心组件HDFS和MapReduce。Hadoop源于Google Cluster、Chubby、GFS、BigTable和MapReduce等技术,其中Chubby被Apache的ZooKeeper所继承,GFS演变为Hadoop Distributed File System (HDFS),BigTable的开源版本是HBase,而MapReduce则成为Hadoop的主要计算模型。

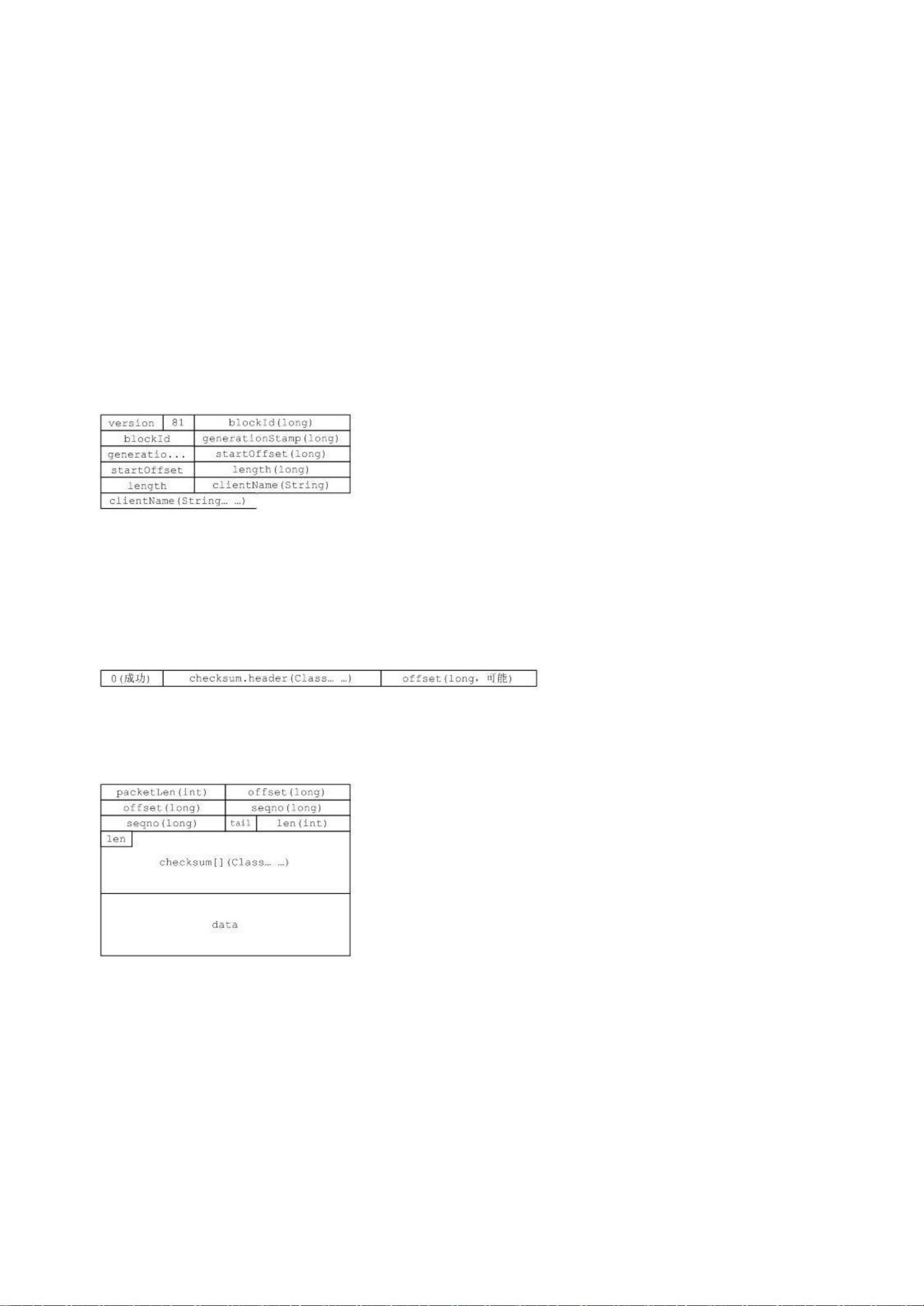

HDFS是Hadoop生态系统的基础,作为分布式文件系统,它负责存储大规模数据并提供高可用性和容错性。HDFS的设计使得它能够处理大量数据,适合批量处理和数据分析场景。在Hadoop的顶层包图中,依赖关系复杂,反映了HDFS的分布式特性以及与底层系统交互的灵活性。例如,包conf依赖于fs,因为系统配置的读取需要文件系统支持,这种设计允许HDFS无缝集成各种存储解决方案。

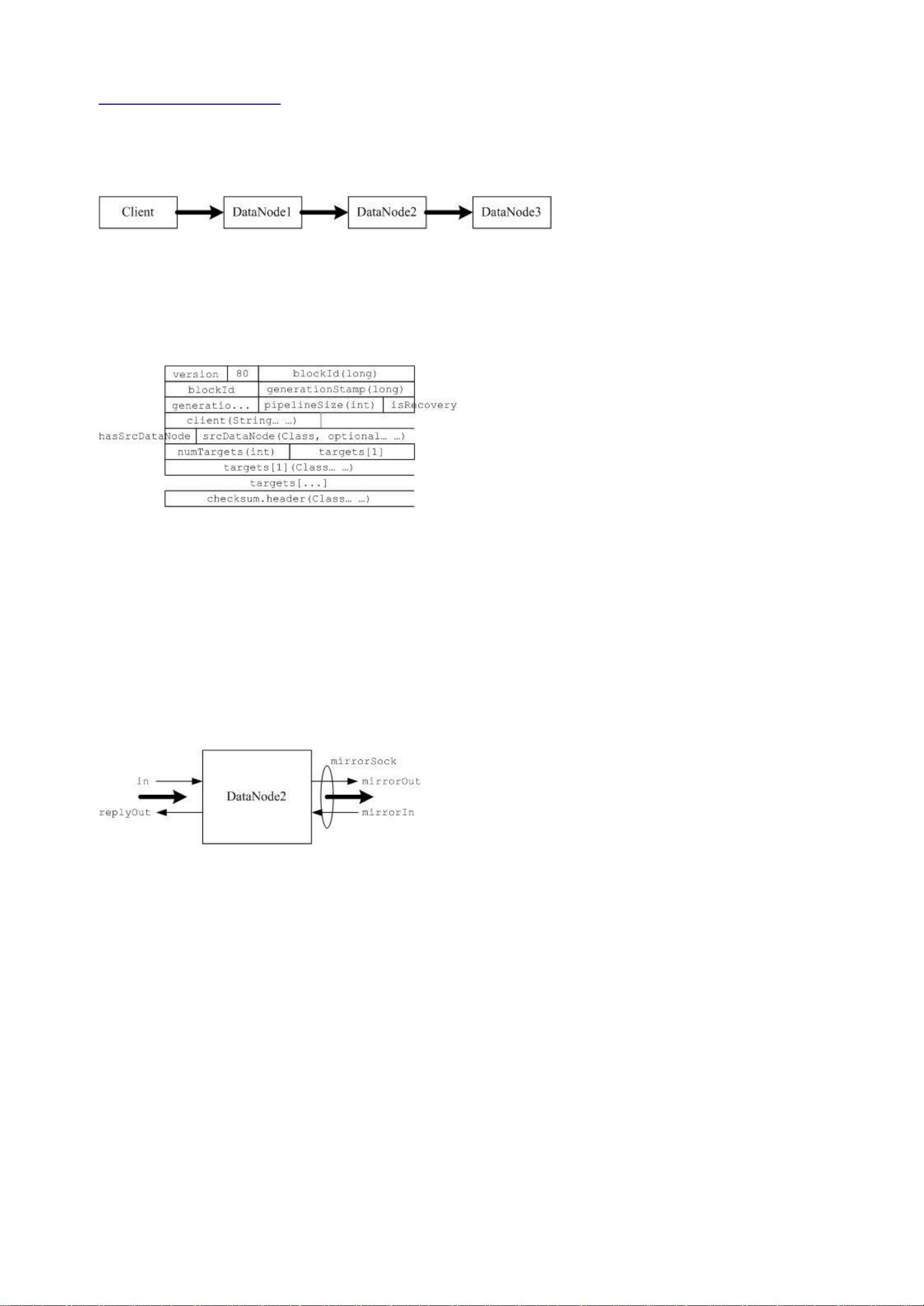

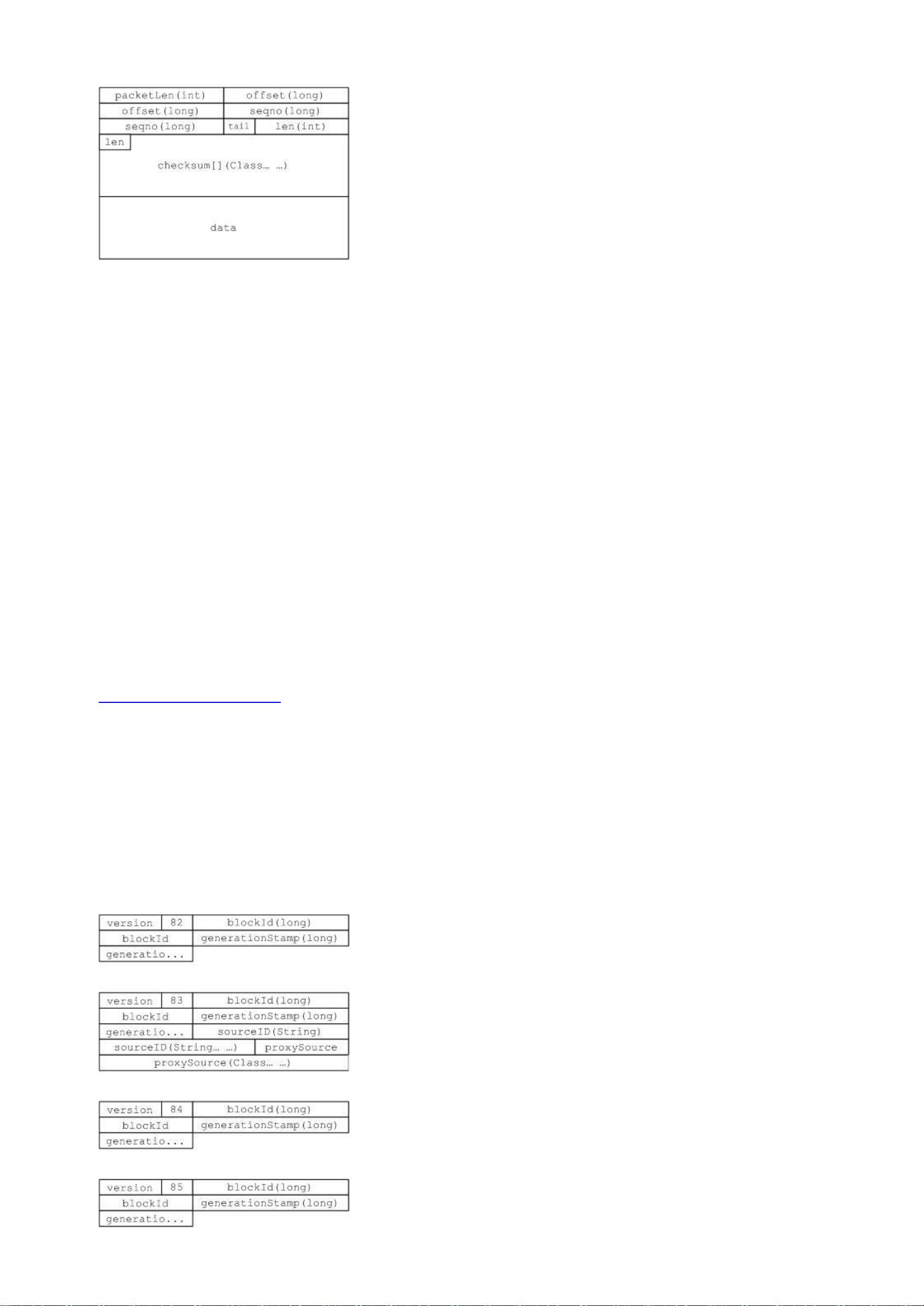

Hadoop的关键部分集中在图中的蓝色区域,主要包括HDFS和MapReduce框架。HDFS的组件包括NameNode(主节点)和DataNode(数据节点),前者管理文件系统的元数据,后者存储实际的数据块。MapReduce则由Mapper、Reducer和JobTracker组成,提供了编程模型来执行并行计算任务,将复杂的任务分解为一系列小的子任务。

深入Hadoop源码分析不仅有助于理解分布式计算的工作原理,还能洞察其优化策略,如数据块复制、数据块调度和容错机制。此外,理解MapReduce的Shuffle和Sort-Reduce过程对性能优化至关重要。通过学习Hadoop源码,开发者可以更好地利用其在大数据处理和云计算领域的优势,并根据具体需求进行定制或扩展。

在后续的分析中,将深入剖析Hadoop的工具包,如工具模块(如DistCp和archive),以及MapReduce的编程接口,包括InputFormat、OutputFormat、Mapper和Reducer接口的实现细节。通过这些分析,读者可以全面掌握Hadoop的运作机制和应用实践,为进一步的开发和优化奠定坚实基础。

306 浏览量

2024-06-23 上传

2022-08-05 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

ccqjs

- 粉丝: 1

- 资源: 7

最新资源

- Sniffer学习手册中文版.pdf

- matlab图形图像处理函数

- 计算机类--电脑维修的基本方法

- 生活水泵电气控制课程设计

- 交换环境下的ARP欺骗和Sniffer

- ActionScript 3.0 Cookbook 中文完整版(翻译版).pdf

- Practical Apache Struts2 Web 2.0 Projects

- Thinking.In.Java.3rd.Edition.Chinese.eBook-YSSY.txt

- JAVA课程复习试题

- MXC6202GHMN-MEMSIC

- JSP数据库编程指南.pdf

- HTML学习:css命名规则

- 电子密码锁设计电子密码锁设计

- 指法练习软件需求说明书

- 基于ATmega16L 单片机的六路抢答器设计

- 指纹识别系统 超经典 绝对