FocalModulation网络:替换自注意力的高效视觉模型

需积分: 0 20 浏览量

更新于2024-06-17

收藏 6.89MB PDF 举报

"Focal Modulation Networks-翻译"

本文主要探讨了一种新型的网络结构——Focal Modulation Network(焦调制网络),它旨在解决自注意力(Self-Attention, SA)在处理大规模视觉任务时的计算复杂度问题。近年来,Transformer模型在多个领域,如自然语言处理、图像分类、目标检测和图像分割,都取得了显著成果,核心在于其自注意力机制能有效捕捉全局信息。然而,随着输入分辨率的提高,自注意力的计算成本也随之增加。

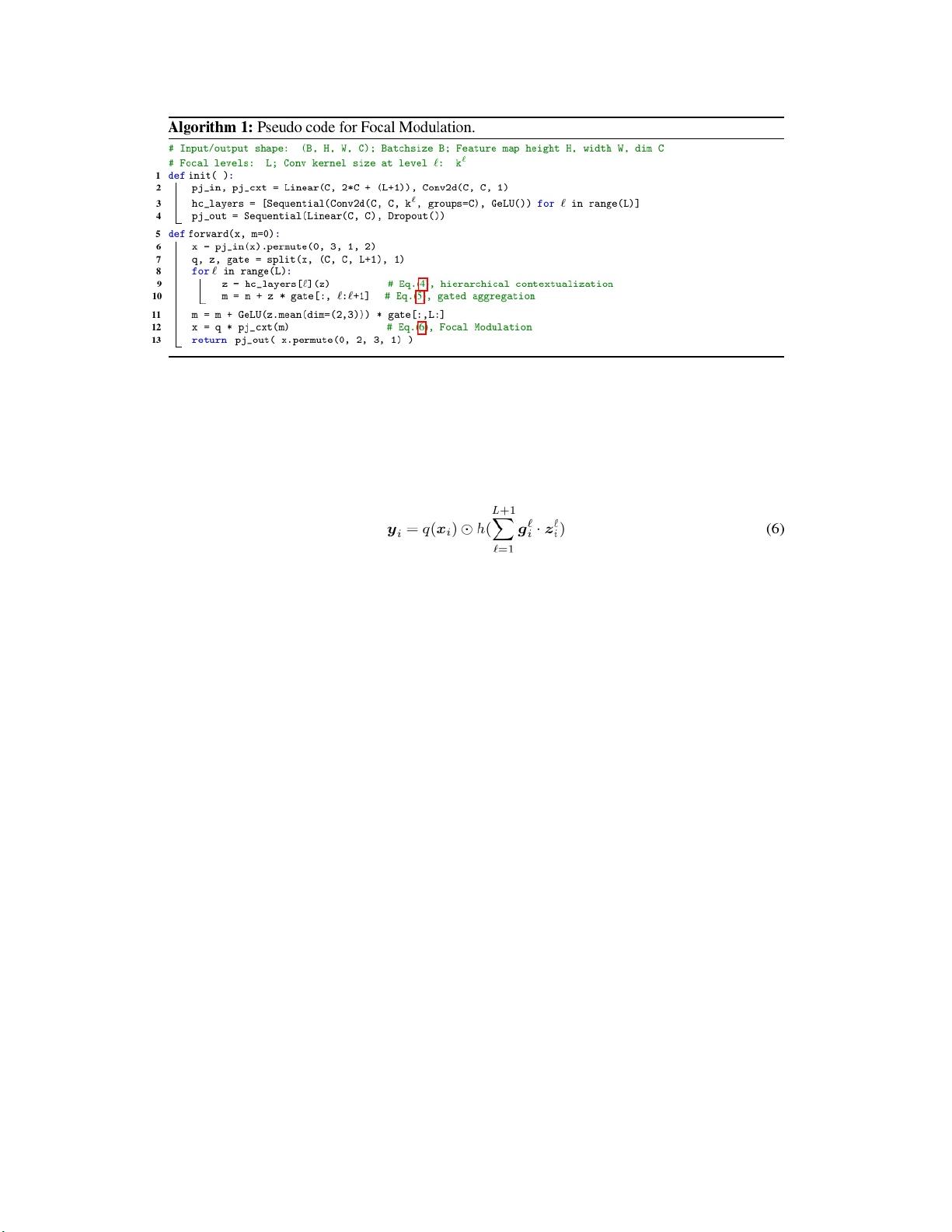

FocalNet的创新之处在于引入了Focal Modulation模块来替代自注意力。这个新模块由三部分组成:

1. 聚焦上下文化(Focal Contextualization):通过深度卷积层堆栈实现,能够从短距离到长距离编码视觉上下文,有效处理不同范围的信息。

2. 门控聚合(Gated Aggregation):这是一种选择性地将上下文信息聚集到每个查询令牌调制器中的策略,确保关键信息的传递,同时减少冗余计算。

3. 基于元素的仿射变换(Element-wise Affine Transformation):将调制器的信息注入查询,以此增强每个令牌的表示能力。

实验结果显示,FocalNets不仅在性能上表现优异,而且具有很好的可解释性。在图像分类任务中,小尺寸和基础尺寸的FocalNets在ImageNet-1K数据集上的top-1精度分别达到了82.3%和83.9%。经过ImageNet-22K的预训练和微调,其在不同分辨率下的top-1准确率进一步提升,最高可达87.3%。在目标检测任务中,使用FocalNet的MaskR-CNN基础模型甚至在只用1x训练的情况下,就超越了Swin基线的3x训练结果。在语义分割任务上,FocalNet也优于Swin,特别是在多尺度评估上。此外,FocalNet与Mask2former结合在ADE20K和COCO分割任务上实现了高水平的mIoU和PQ指标。

更令人印象深刻的是,FocalNet与DINO联合使用,在COCO的minival和test-dev上分别取得了64.3和64.4的mAP,超越了基于注意力的大模型如Swinv2-G和BEIT-3,确立了新的State-of-the-Art(SoTA)纪录。

Focal Modulation Network为视觉任务提供了一种高效且可解释的替代方案,它有可能成为未来视觉模型设计的关键组件。文章提供了代码和模型,供研究者进一步探索和应用。

2024-09-05 上传

2021-05-30 上传

2021-02-09 上传

2021-06-16 上传

2021-02-06 上传

2021-02-08 上传

2022-07-13 上传

2021-05-29 上传

2024-04-27 上传

梨涡的漫漫求学路

- 粉丝: 333

- 资源: 1