日志分析系统实践:HDFS到HBase与Hive的集成应用

需积分: 0 144 浏览量

更新于2024-08-04

收藏 674KB DOCX 举报

"本资源是关于日志分析系统的详细介绍,主要涵盖了从环境搭建到数据分析的整个流程,包括从HDFS导入HBase,使用Hive进行数据映射和分析,以及将结果存储到MySQL中。"

在日志分析领域,本课题提供了一个全面的流程,从基础的环境配置到具体的数据处理和分析。以下是根据提供的信息整理出的知识点:

一、课题概述

此课题旨在运用大数据处理框架,如HDFS(Hadoop分布式文件系统)、MapReduce、HBase(分布式列式数据库)和Hive(数据仓库工具),对论坛的日志数据进行分析。分析的关键指标包括页面浏览量(PV)、注册用户数、独立IP数和跳出率。为了便于用户查询,分析结果被存储在MySQL数据库中,其中,概览信息存储在MySQL,详细日志则存储在HBase中。

二、环境搭建

环境搭建在具有三个节点的Hadoop集群上,每个节点需安装Zookeeper以支持HBase集群。HBase集群在master节点上运行,同时master节点还需要安装Hive和MySQL。这一步骤确保了所有必要的服务和工具都可供后续的日志处理和分析使用。

三、数据准备

日志数据的准备通常始于从源系统获取数据。在本案例中,日志文件从Windows系统通过winscp上传到Linux服务器,然后可以使用HDFS的命令行工具或集成开发环境(如Eclipse)直接操作这些文件。

四、数据导入

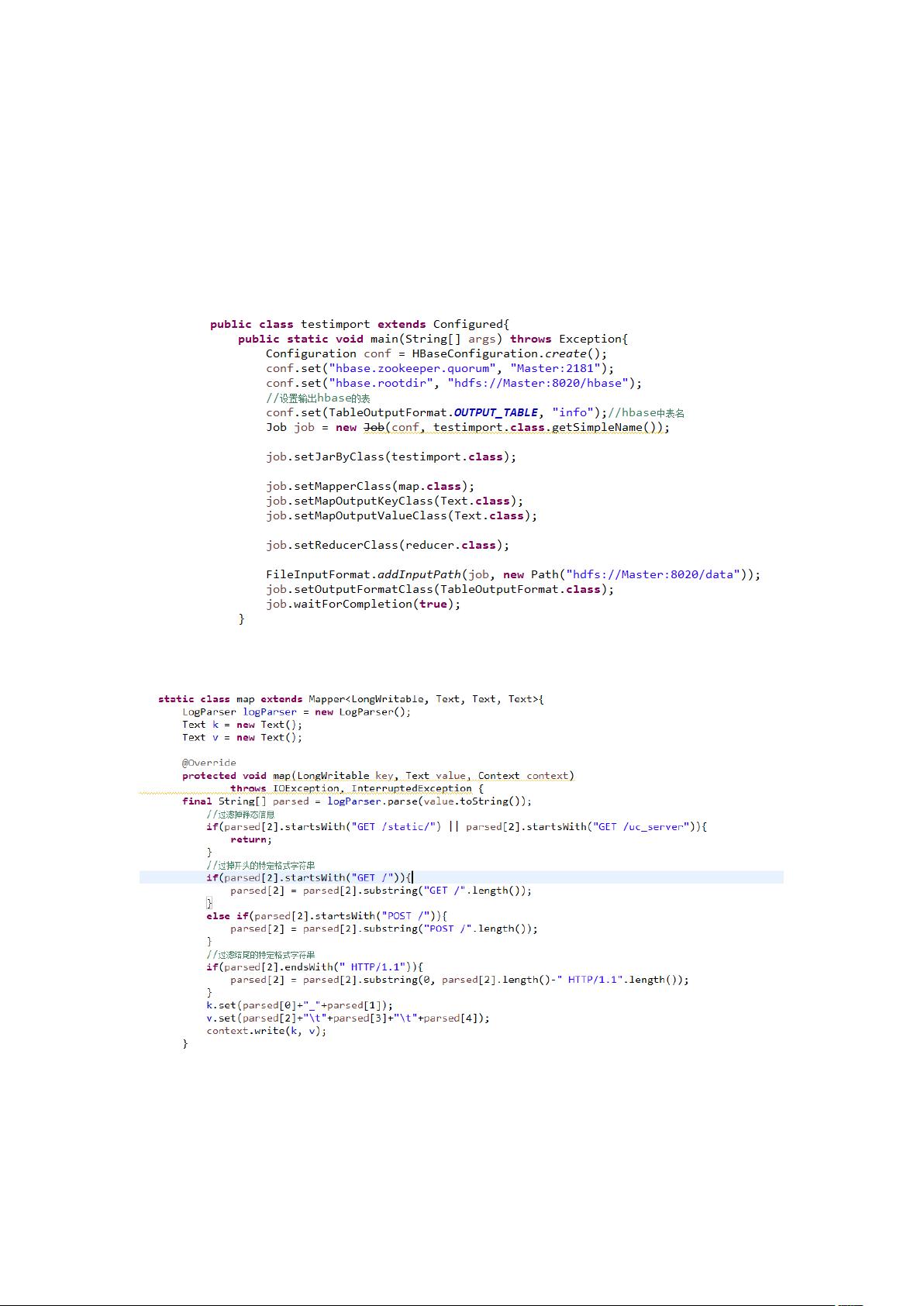

1. 从HDFS导入HBase:日志数据通常以文本格式存储在HDFS中,通过HBase的API或者工具(如HBase Shell)将这些数据导入HBase,以便进行快速的行键查询和时间序列分析。

2. Hive表映射HDFS文件:Hive可以创建逻辑表来映射HDFS上的文件,这使得可以使用SQL语句对大数据进行查询和分析。映射过程涉及创建Hive表结构并指定外部表的数据源路径。

五、基于Hive的分析

Hive提供了一种高效的方式来处理和分析日志数据,如:

1. 页面PV量:通过聚合操作计算页面的总访问次数。

2. 注册数:通过特定字段(如注册标识)统计新用户数量。

3. IP数:通过去重IP地址计数以得到独立访问者数。

4. 跳出率:通过分析用户访问深度和会话时长计算得出。

5. 汇总:综合以上各项指标,生成总体报告。

六、分析结果与总结

分析完成后,结果被导出至MySQL,使得非技术人员可以通过SQL查询或者前端应用直接查看和交互。总结部分可能包含对分析方法的有效性评估,以及可能的优化建议。

以上就是日志分析系统的基本流程,涉及了大数据处理的多个环节,从数据的获取、存储、处理到最终的可视化和决策支持。这样的系统对于理解用户行为、优化网站性能和提供商业洞见具有重要意义。

蔓誅裟華

- 粉丝: 25

- 资源: 303