HDFS深度解析:Hadoop的高可靠分布式文件系统

"深入理解HDFS:Hadoop分布式文件系统"

Hadoop分布式文件系统(HDFS)是大数据存储领域中的核心组件,它为处理大规模数据提供了可靠且可扩展的解决方案。与传统的网络文件系统(NFS)相比,HDFS在设计上克服了NFS的一些局限性,特别是针对大型企业和组织面临的海量数据存储需求。

1. HDFS的基本概念

HDFS是一种分布式文件系统,它将大型文件分割成块,并将这些块存储在多台计算机(节点)上,以形成一个集群。每个文件块通常为128MB或256MB,且有多个副本,以确保数据的高可用性和容错性。这种设计使得HDFS能够在节点故障时自动恢复数据,同时避免了单点故障的问题。

2. HDFS的设计原则

- 大文件存储:HDFS优化了处理大型文件的能力,支持PB级别的数据存储。

- 流式数据访问:系统设计时考虑了数据的一次写入、多次读取模式,适合批处理分析任务,而非频繁的随机读写操作。

- 商业硬件友好:HDFS可以在普通的商用服务器上运行,不需要昂贵的专用硬件,这降低了部署成本并提高了系统的可扩展性。

3. HDFS的工作机制

- 数据复制:HDFS通过在不同的节点上保存数据块的副本,实现了容错能力。默认情况下,每个数据块有3个副本,以确保在节点故障时仍能提供服务。

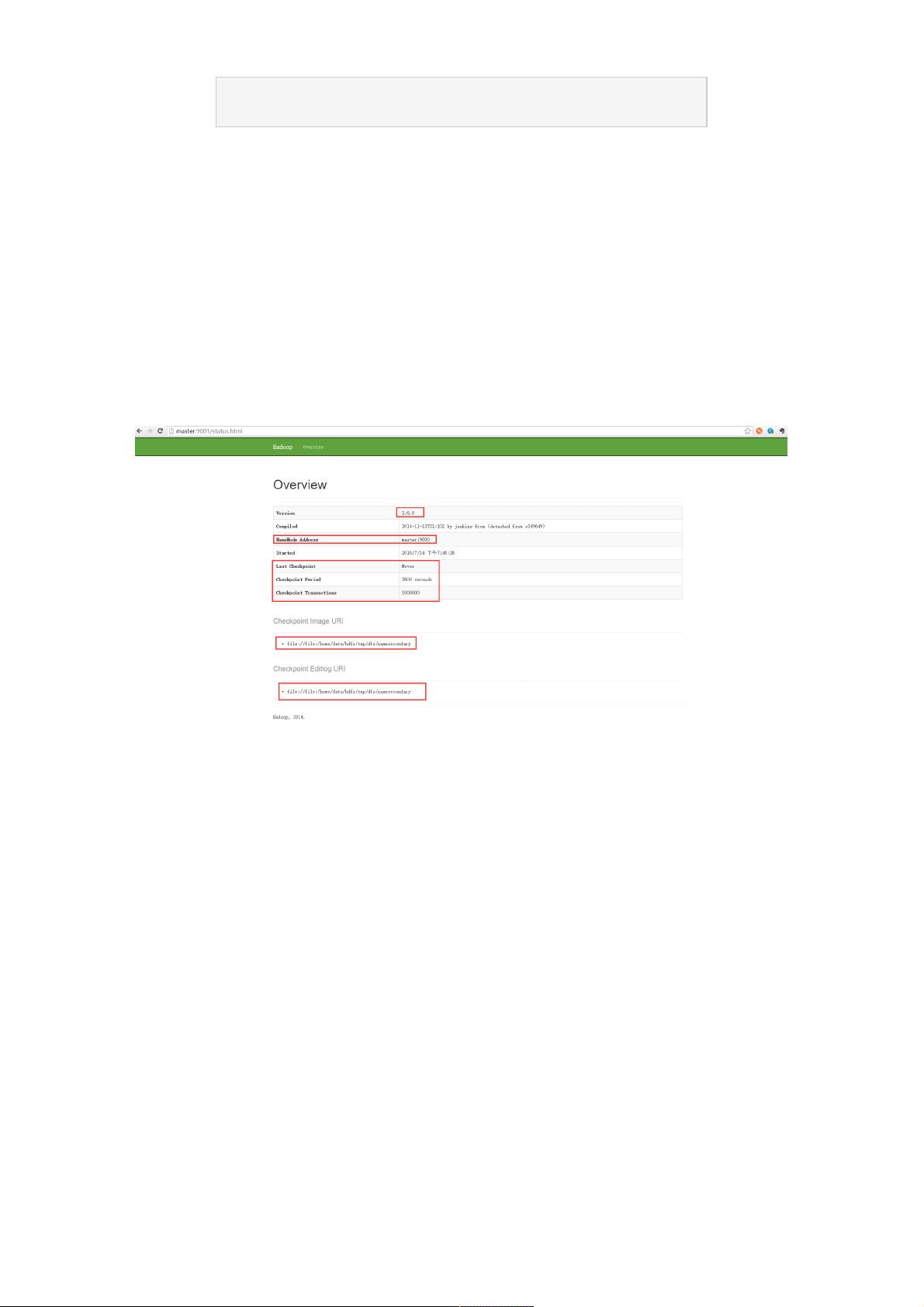

- 名节点(NameNode)与数据节点(DataNode):NameNode是HDFS的元数据管理中心,负责文件系统的命名空间和文件块映射信息;DataNodes则是实际存储数据的节点,它们定期向NameNode报告状态,并响应客户端的读写请求。

- 写入流程:客户端将文件切分为块,然后选择一个DataNode写入第一个副本,接着这个DataNode将数据转发给其他副本所在的DataNodes。NameNode记录下文件块的位置信息。

- 读取流程:客户端从NameNode获取文件块的位置,然后直接从最近或负载较低的DataNode读取数据,减少了中间环节。

4. 高可用性与容错性

- 当DataNode故障时,HDFS能够自动检测并从其他副本中恢复数据,保证服务的连续性。

- NameNode的高可用性是通过备用NameNode(Secondary NameNode)实现的,它定期合并编辑日志,减轻主NameNode的压力,并在需要时接管。

5. 应用场景

HDFS广泛应用于大数据处理、日志分析、互联网搜索、基因序列分析等领域,特别适合那些需要处理大量数据并行计算的场景。

6. 集群搭建与管理

搭建Hadoop集群涉及多个步骤,包括配置集群节点、安装软件、设置HDFS参数等,具体步骤可以在相关文档中找到,如《Hadoop集群搭建详细步骤(2.6.0)》。

HDFS作为Hadoop生态系统的一部分,通过分布式存储和处理技术,为企业的大数据应用提供了高效、可靠的基础设施。它不仅解决了单机存储的局限,还通过其独特的设计原理,适应了大规模数据分析的需求。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-03-11 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

1822 浏览量

885 浏览量

weixin_38559727

- 粉丝: 6

- 资源: 924

最新资源

- 虚拟人中台相关方案文档

- unity 3D文字系统源码VText.zip

- madgrad:MADGRAD的JAX实现

- SimpleHUD:SimpleHUD是一款易于使用但美观的Android HUD(或对话框)

- 汇编语言程序设计(资料+视频教程).rar

- 信呼协同办公OA系统 v2.1.8

- meelouth.github.io:网站

- bank-java:一个用 Java 编写的带有 GUI 的基本银行程序

- 亚马逊交易-crx插件

- stylex

- Data-Analysis-Project-in-Python:Python中Fifa 18数据集的数据分析。 该项目包括可视化和用于预测目的的机器学习

- glslmath:C ++仅限头文件的库,可模拟GLSL数学-开源

- TongYWPF.Template.NumberOne202303DemoK

- 剁手党买家秀助手-crx插件

- ExpandTabView-master

- React