LXM32A 交流伺服驱动装置用户手册

需积分: 13 180 浏览量

更新于2024-07-15

收藏 5.71MB PDF 举报

"LXM32A_Manual_ZH.pdf"

这篇文档是施耐德电气公司推出的LXM32A交流伺服驱动装置的产品手册,版本号为V1.08,发布日期为2014年4月。手册包含了该驱动器的详细技术信息和安全指南,旨在帮助用户正确安装、配置和使用这款产品。

在安全信息部分,手册强调了正确使用信息的重要性,指出文档中的信息并不完全保证产品在特定应用中的适用性和可靠性,用户或集成商需自行进行风险分析和测试。此外,施耐德电气对于因误用信息导致的后果不承担责任。文档版权属于施耐德电气,未经许可,禁止任何形式的复制。

在安装和使用LXM32A时,必须遵循所有适用的安全法规,只有制造商才能对组件进行维修,以确保安全和数据一致性。若在有技术安全要求的环境中使用,必须严格遵守使用说明,防止人身伤害和设备损坏。

手册还涵盖了设备的基本信息,如DC总线电压测量、安全功能和标准及术语。其中,DC总线电压测量涉及驱动器的电源管理,安全功能则可能包括过载保护、短路防护等,而标准和术语则是为了统一理解和操作流程。

在技术参数章节,手册详细列出了环境条件(如温度、湿度等)、机械参数(尺寸、重量等)以及电气参数(输出级别、不同电源电压下的性能数据)。例如,它分别提供了单相115Vac、230Vac,以及三相208Vac、400Vac和480Vac设备的电气参数数据,这些数据对于计算功率、电流和效率至关重要。

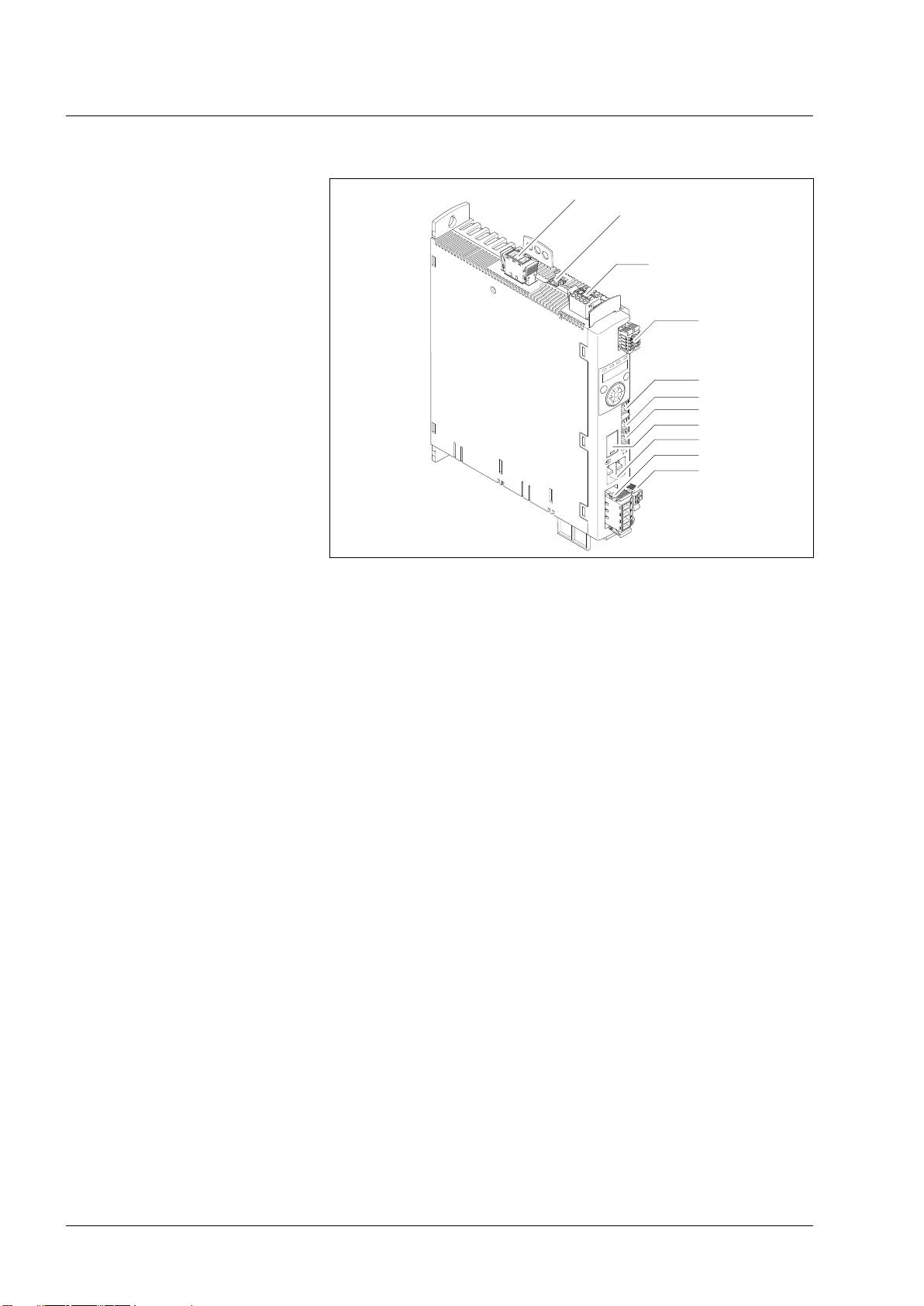

手册的其他部分可能包括设备的序言,如设备概述、组件与接口的描述、铭牌信息和型号代码的解释。这些内容有助于用户理解设备的功能、结构和定制选项。

LXM32A手册是全面了解和操作这款交流伺服驱动器的重要参考资料,它提供了必要的技术细节、安全指导和安装维护信息,帮助用户正确并安全地利用该设备。

2012-07-06 上传

2021-12-05 上传

2023-12-28 上传

2019-09-20 上传

2021-04-28 上传

2019-09-21 上传

2021-05-01 上传

2014-11-20 上传

weixin_43930289

- 粉丝: 3

- 资源: 11

最新资源

- C语言数组操作:高度检查器编程实践

- 基于Swift开发的嘉定单车LBS iOS应用项目解析

- 钗头凤声乐表演的二度创作分析报告

- 分布式数据库特训营全套教程资料

- JavaScript开发者Robert Bindar的博客平台

- MATLAB投影寻踪代码教程及文件解压缩指南

- HTML5拖放实现的RPSLS游戏教程

- HT://Dig引擎接口,Ampoliros开源模块应用

- 全面探测服务器性能与PHP环境的iprober PHP探针v0.024

- 新版提醒应用v2:基于MongoDB的数据存储

- 《我的世界》东方大陆1.12.2材质包深度体验

- Hypercore Promisifier: JavaScript中的回调转换为Promise包装器

- 探索开源项目Artifice:Slyme脚本与技巧游戏

- Matlab机器人学习代码解析与笔记分享

- 查尔默斯大学计算物理作业HP2解析

- GitHub问题管理新工具:GIRA-crx插件介绍