组归一化:小批量训练误差解决方案,挑战BN地位

21 浏览量

更新于2024-06-20

收藏 753KB PDF 举报

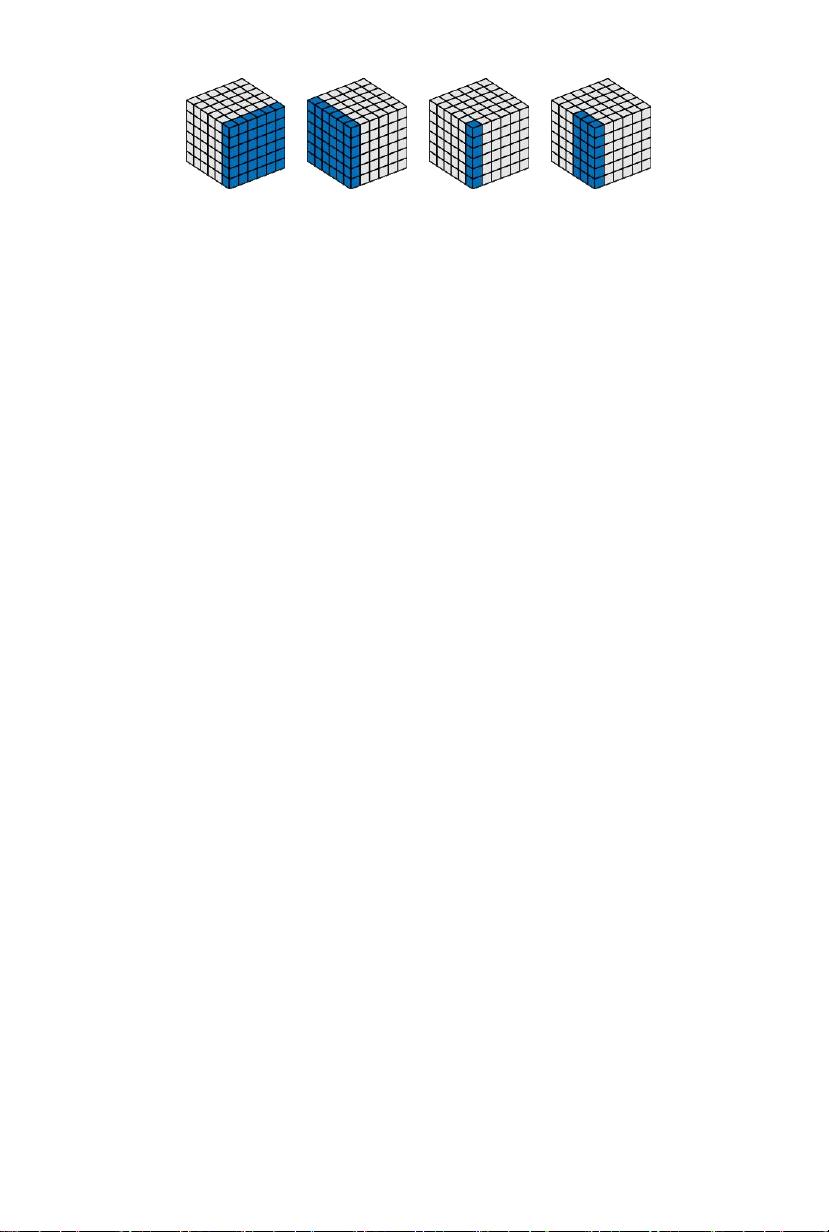

"这篇论文提出了一种新的归一化方法——组归一化(Group Normalization, GN),作为批量归一化(Batch Normalization, BN)的替代方案,旨在解决小批量训练时误差增加的问题。BN在深度学习领域中扮演着重要角色,尤其在图像处理和计算机视觉任务中,但其依赖于大批次处理,小批量时性能下降。GN通过将通道划分为组并在组内计算平均值和方差,克服了这一限制,即使在小批量情况下也能保持稳定性能。在ImageNet上的实验表明,GN在批量大小为2时的误差比BN低10.6%,并且在典型批量大小下与BN相当甚至更优。此外,GN在COCO对象检测和分割、Kinetics视频分类等任务中也展现出优势,证明了其在多种任务中的有效性。GN的实现简单,可以方便地应用于模型微调。"

详细说明:

批量归一化(BN)是深度学习中一个关键的技术,它通过计算批量数据的均值和方差来进行特征归一化,帮助优化过程并提高模型的泛化能力。然而,BN在小批量训练时由于批量统计的不准确性,导致误差增加。为了解决这个问题,研究者提出了组归一化(GN)。与BN不同,GN不是按批量进行归一化,而是将特征通道划分为多个小组,然后在每个小组内分别计算均值和方差,从而减少了对批量大小的依赖。

GN的这种设计使得它在小批量训练时也能保持稳定的表现。在ImageNet数据集上,使用ResNet-50模型进行实验,当批量大小仅为2时,GN相比BN的误差降低了10.6%。在标准批量大小下,GN的性能与BN相当,甚至在某些情况下更好。这表明GN在处理内存有限、需要小批量的场景时具有显著优势。

此外,GN在迁移学习和微调任务中也表现出优越性,能够在COCO对象检测和分割以及Kinetics视频分类等任务中超越基于BN的方法。这进一步证明了GN作为一种通用的归一化方法,能在不同的计算机视觉任务中有效替代BN。

GN的实现相对简单,只需要对现有模型进行少量代码修改,即可替换BN。这使得GN成为深度学习开发者的一个实用工具,特别是在资源受限的环境中,如边缘计算或者单GPU训练时。

组归一化提供了一种新的视角来处理深度学习中的归一化问题,特别是对于那些无法使用大批次训练的情况。通过其独特的组内归一化策略,GN能够提高模型的稳定性和泛化性能,且易于集成到现有的深度学习框架中,为未来的深度学习研究和应用开辟了新的可能。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-07-27 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程