深度学习基础:全连接网络与过拟合处理

版权申诉

36 浏览量

更新于2024-08-11

收藏 784KB PDF 举报

该资源是关于深度学习初步的教程,主要涵盖了全连接神经网络(MLP)的原理,包括过拟合、激活函数以及batchsize和epochs的选择。内容详细介绍了Sigmoid、ReLU和MaxOut等激活函数的特点及其对神经网络的影响,并探讨了batchsize和epochs在训练过程中的作用,以及如何通过正则化和dropout来处理过拟合问题。

深度学习是人工智能领域的重要分支,它主要依赖于神经网络模型进行复杂模式的学习和预测。全连接神经网络(MLP)是最早形式的深度学习模型,由多层神经元组成,每一层神经元都与前一层的所有神经元相连。本教程深入讲解了MLP的原理,特别是关注了模型训练中的关键问题。

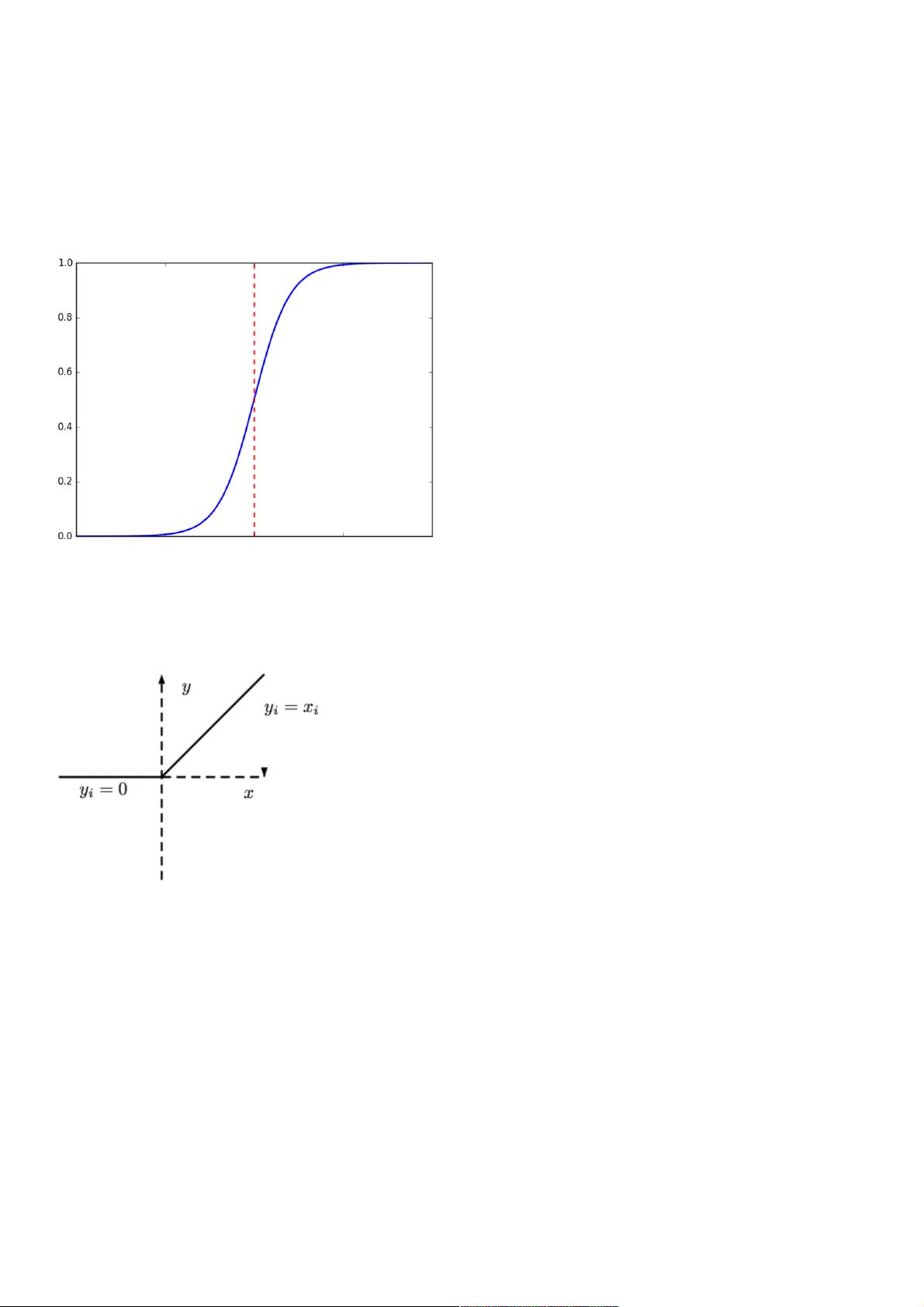

首先,激活函数在神经网络中起到非线性转换的作用,是神经网络能够学习复杂关系的关键。Sigmoid函数虽然能将输入压缩到0到1之间,但容易导致梯度消失问题,不利于深层网络的训练。相比之下,ReLU(Rectified Linear Unit)函数在正区间内保持线性,解决了梯度消失问题,成为现代深度学习的首选激活函数。MaxOut函数则是更灵活的激活形式,可以根据数据自适应地学习最佳的决策边界。

其次,批量大小(batchsize)和迭代次数(epochs)是训练过程中的重要参数。批量梯度下降是常用的优化算法,batchsize决定了每次更新参数时使用的样本数量。较小的batchsize可能导致更多的随机性,有助于避免陷入局部最小值,而较大的batchsize则可以利用GPU进行并行计算,提高训练速度,但可能占用更多内存,并可能导致模型过早拟合数据。epochs表示完整遍历一次数据集的次数,决定模型的训练程度。

最后,过拟合是深度学习中常见的问题,模型过度拟合训练数据,导致泛化能力下降。为了解决这个问题,通常采用正则化(L1、L2正则)和dropout策略。正则化通过添加惩罚项限制模型参数的复杂度,防止模型过度复杂;dropout则是在训练过程中随机忽略一部分神经元,强制模型学习更加鲁棒的特征,从而减轻过拟合。

这个资源提供了深度学习初学者理解神经网络基本概念和训练策略的良好基础,包括关键的激活函数选择、优化参数设置以及过拟合的应对措施。对于想要深入了解和实践深度学习的人来说,这份资料无疑是一份宝贵的参考资料。

2022-04-13 上传

2023-01-29 上传

2023-03-14 上传

2018-11-04 上传

2021-05-29 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

_webkit

- 粉丝: 30

- 资源: 1万+

最新资源

- 掌握压缩文件管理:2工作.zip文件使用指南

- 易语言动态版置入代码技术解析

- C语言编程实现电脑系统测试工具开发

- Wireshark 64位:全面网络协议分析器,支持Unix和Windows

- QtSingleApplication: 确保单一实例运行的高效库

- 深入了解Go语言的解析器组合器PARC

- Apycula包安装与使用指南

- AkerAutoSetup安装包使用指南

- Arduino Due实现VR耳机的设计与编程

- DependencySwizzler: Xamarin iOS 库实现故事板 UIViewControllers 依赖注入

- Apycula包发布说明与下载指南

- 创建可拖动交互式图表界面的ampersand-touch-charts

- CMake项目入门:创建简单的C++项目

- AksharaJaana-*.*.*.*安装包说明与下载

- Arduino天气时钟项目:源代码及DHT22库文件解析

- MediaPlayer_server:控制媒体播放器的高级服务器