CUDA编程模型详解:GPU并行计算

需积分: 10 62 浏览量

更新于2024-07-25

收藏 4.51MB PPT 举报

"CUDA程序设计深入讲解,涵盖了GPGPU概念和CUDA编程模型,探讨了GPU与CPU硬件架构的区别,并阐述了CUDA如何实现CPU与GPU的有效结合,支持并行计算。"

CUDA程序设计主要涉及以下几个关键知识点:

1. **GPGPU(通用计算于GPU)**:GPGPU是利用原本主要用于图形渲染的GPU进行通用计算的一种技术。它利用GPU的并行计算能力处理大量数据,尤其适用于处理规则数据结构和可预测存取模式的任务,如油气勘探、金融分析和科学计算等。

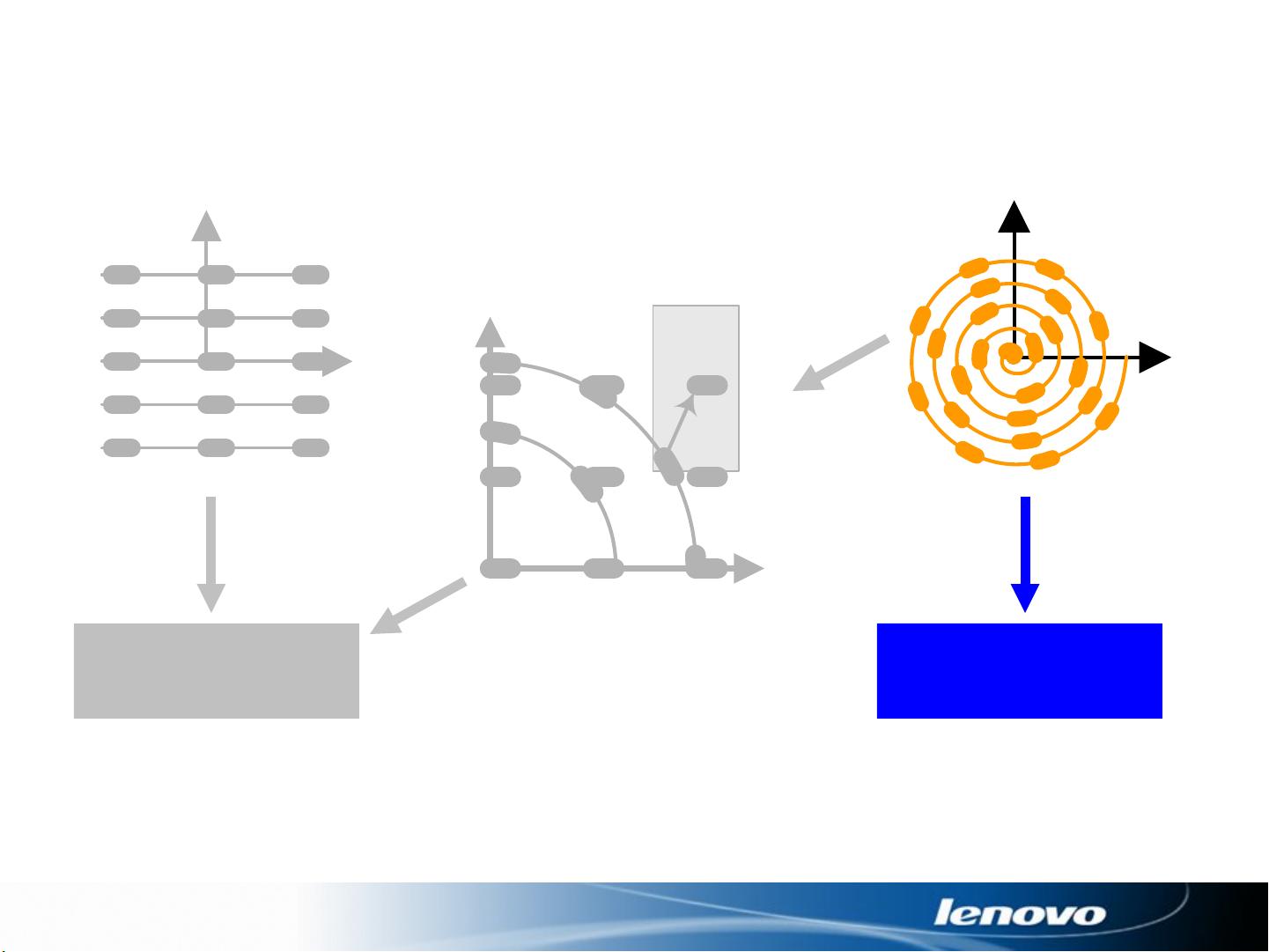

2. **CUDA(计算统一设备架构)**:CUDA是NVIDIA推出的一种并行计算平台和编程模型,它使得开发者可以使用C、C++或Fortran等熟悉的编程语言来编写能够运行在GPU上的并行代码。CUDA的核心是将串行计算的部分留在CPU上,而将并行计算的部分(kernel)放在GPU上执行,从而实现高效的数据并行处理。

3. **CUDA编程模型**:CUDA编程模型包括了CUDA线程、块和网格的概念。线程是GPU上最小的执行单元,线程可以被组织成线程块,多个线程块又构成一个网格。这种层次化的结构使得程序员可以有效地管理和调度大量的并发线程。

4. **GPU与CPU硬件架构对比**:CPU通常拥有更多的缓存和复杂的控制单元,适用于控制密集型任务和处理不规则数据结构。而GPU则拥有大量的ALU(算术逻辑单元),专门优化用于执行大规模数据并行操作,其内存系统更适合数组和矩阵运算。

5. **CUDA编程的挑战**:虽然CUDA提供了强大的并行计算能力,但编程过程中也存在挑战,如硬件资源可能未充分利用,存储器访问模式受限,调试和错误检测困难,以及需要掌握高级图形处理和编程技巧。

6. **CUDA执行模型**:CUDA程序中的kernel是并行执行的函数,通过`<<< >>>`操作符定义其在GPU上的执行配置,如grid(网格)的大小和block(线程块)的大小。例如,`KernelA<<<nBlk, nTid>>>(args)`表示kernel A将在nBlk个线程块中,每个块有nTid个线程执行。

7. **内存层次**:CUDA具有多种内存类型,包括全局内存、共享内存、常量内存和纹理内存,每种内存都有其特定的用途和访问速度,理解并合理利用这些内存对于优化CUDA程序至关重要。

8. **CUDA并行编程技巧**:为了充分利用GPU的并行能力,开发者需要考虑数据并行性、任务并行性,以及如何避免全局内存访问的延迟。此外,正确使用同步函数如`__syncthreads()`也是保证并行计算正确性的关键。

通过理解和掌握这些CUDA编程的核心概念,开发者可以构建出高效运行在GPU上的并行程序,充分利用硬件的计算能力,解决大规模数据处理和高性能计算的问题。

2011-03-11 上传

点击了解资源详情

2021-09-19 上传

2021-09-11 上传

2011-04-20 上传

xiaofeixia0

- 粉丝: 0

- 资源: 7

最新资源

- 深入浅出:自定义 Grunt 任务的实践指南

- 网络物理突变工具的多点路径规划实现与分析

- multifeed: 实现多作者间的超核心共享与同步技术

- C++商品交易系统实习项目详细要求

- macOS系统Python模块whl包安装教程

- 掌握fullstackJS:构建React框架与快速开发应用

- React-Purify: 实现React组件纯净方法的工具介绍

- deck.js:构建现代HTML演示的JavaScript库

- nunn:现代C++17实现的机器学习库开源项目

- Python安装包 Acquisition-4.12-cp35-cp35m-win_amd64.whl.zip 使用说明

- Amaranthus-tuberculatus基因组分析脚本集

- Ubuntu 12.04下Realtek RTL8821AE驱动的向后移植指南

- 掌握Jest环境下的最新jsdom功能

- CAGI Toolkit:开源Asterisk PBX的AGI应用开发

- MyDropDemo: 体验QGraphicsView的拖放功能

- 远程FPGA平台上的Quartus II17.1 LCD色块闪烁现象解析