强化学习算法 AdaBoost:理论与应用概述

需积分: 9 96 浏览量

更新于2024-10-11

收藏 276KB PDF 举报

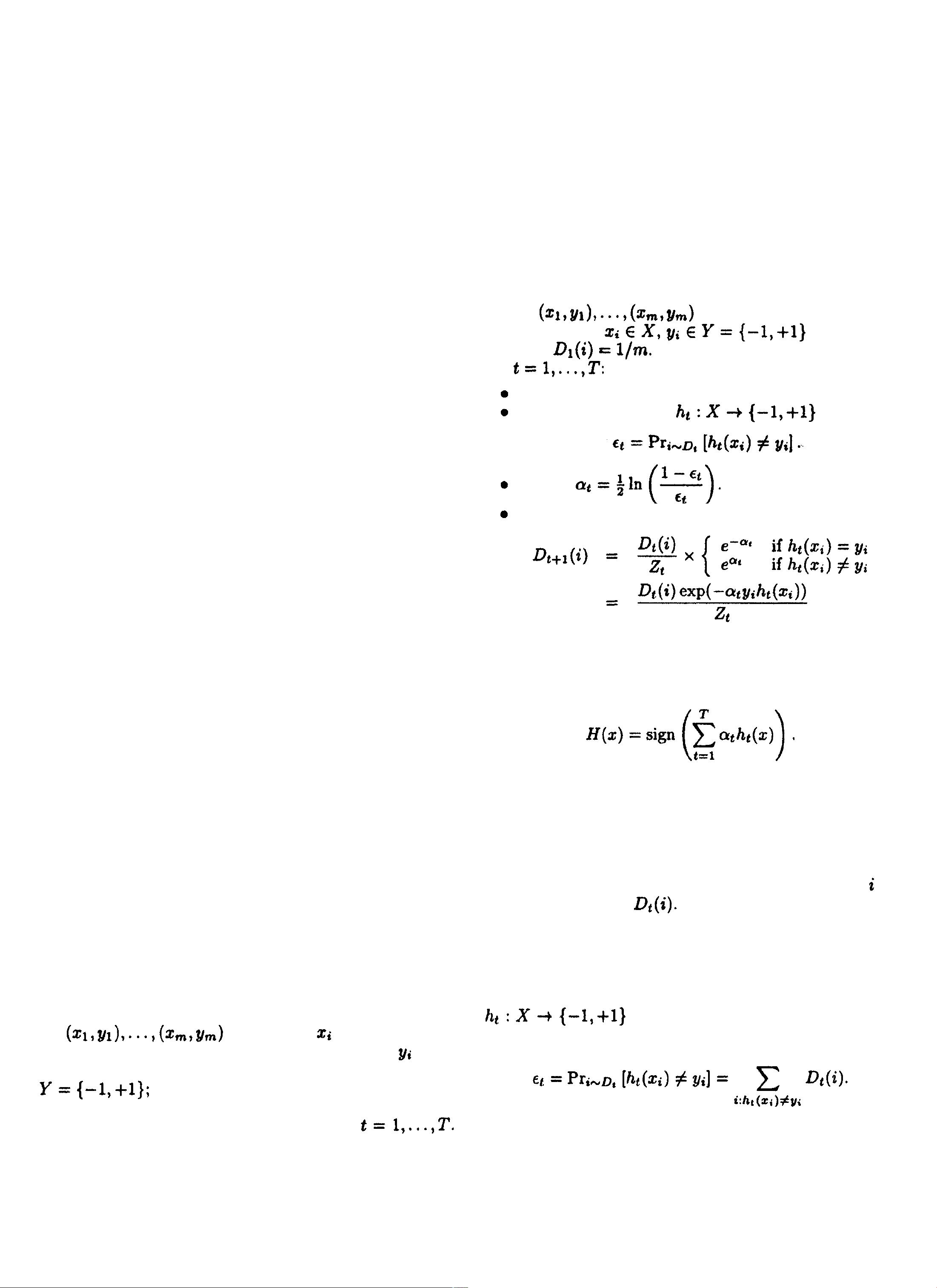

"Boosting"是一种通用的机器学习技术,旨在提高特定算法的预测准确性。本文档由Robert E. Schapire撰写,他是AT&T Labs-Shannon实验室的研究员,主要介绍了名为AdaBoost的提升算法,这是Boosting方法的一个关键实现。AdaBoost的名字来源于"Adaptive Boosting",它通过迭代的方式,对错误分类进行加权,从而使基础学习器的组合变得更强大,能够在处理复杂问题时避免过拟合。

在背景部分,Boosting的概念源于Valiant提出的"Probably Approximately Correct"(PAC)学习模型,这是一种理论框架,用于衡量学习算法在有限样本下的性能。Kearns和Vazirani在他们的著作中深入探讨了这个模型,他们首次提出了如何将一个在PAC模型下仅略优于随机猜测的“弱”学习器转化为能够达到任意高精度的“强”学习器的问题。

Schapire在他的工作中,发展了提升算法的方法,解释了其背后的原理。他展示了如何通过动态调整每个学习器的权重分配,使得整个集合的学习性能得以提升,即使单个学习器表现不佳。这种方法的关键在于,通过累积多个弱学习器的输出,并根据它们的错误率给予不同的权重,最终形成一个更强大的整体模型,这被称为“弱学习器的强结合”。

此外,文档还简要提到了Boosting的一些实际应用,如在数据挖掘、计算机视觉、自然语言处理等领域,AdaBoost和其变种算法被证明在许多情况下都能有效地提高模型的性能。例如,在文本分类任务中,AdaBoost常与决策树一起使用,通过逐步改进决策树的选择,从而提升分类准确性和鲁棒性。

这篇短文为读者提供了一个理解Boosting方法特别是AdaBoost的入门指南,不仅涵盖了理论概念,还包括了其实现策略以及它如何解决过拟合问题。通过阅读这篇论文,读者能够了解到如何将基础学习器通过迭代优化转化为强大的学习工具,这对于从事机器学习实践和理论研究的人来说具有很高的参考价值。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-03-17 上传

2013-01-15 上传

2019-04-14 上传

2018-08-03 上传

2010-05-03 上传

2008-10-19 上传

hawk_123

- 粉丝: 0

- 资源: 1

最新资源

- 俄罗斯RTSD数据集实现交通标志实时检测

- 易语言开发的文件批量改名工具使用Ex_Dui美化界面

- 爱心援助动态网页教程:前端开发实战指南

- 复旦微电子数字电路课件4章同步时序电路详解

- Dylan Manley的编程投资组合登录页面设计介绍

- Python实现H3K4me3与H3K27ac表观遗传标记域长度分析

- 易语言开源播放器项目:简易界面与强大的音频支持

- 介绍rxtx2.2全系统环境下的Java版本使用

- ZStack-CC2530 半开源协议栈使用与安装指南

- 易语言实现的八斗平台与淘宝评论采集软件开发

- Christiano响应式网站项目设计与技术特点

- QT图形框架中QGraphicRectItem的插入与缩放技术

- 组合逻辑电路深入解析与习题教程

- Vue+ECharts实现中国地图3D展示与交互功能

- MiSTer_MAME_SCRIPTS:自动下载MAME与HBMAME脚本指南

- 前端技术精髓:构建响应式盆栽展示网站