对数几率回归详解:从原理到Python实现

需积分: 5 58 浏览量

更新于2024-06-25

收藏 450KB PDF 举报

"该PDF文件主要讲解了对数几率回归(Logistic Regression,LR)的基础知识,包括原理、Sigmoid函数及其应用,并介绍了如何在Python中实现,包括使用numpy自定义实现和sklearn库的调用。"

对数几率回归是一种广泛应用于分类问题的线性模型,它在机器学习中占有重要地位。不同于线性回归直接预测连续值,对数几率回归的目标是预测离散的类别标签,通常用于二分类问题,但也可以扩展到多分类。在对数几率回归中,预测结果是通过对线性模型的输出进行非线性转换,即应用Sigmoid函数来实现的。

Sigmoid函数是一个常用的激活函数,它的数学形式为 \( y = \frac{1}{1 + e^{-z}} \),其特点是具有平滑的S型曲线,输出值域限定在0和1之间,这恰好对应于概率的取值范围。Sigmoid函数的导数表达式为 \( f'(x) = f(x)(1 - f(x)) \),这一特性使得在梯度下降等优化算法中计算梯度变得非常便捷。

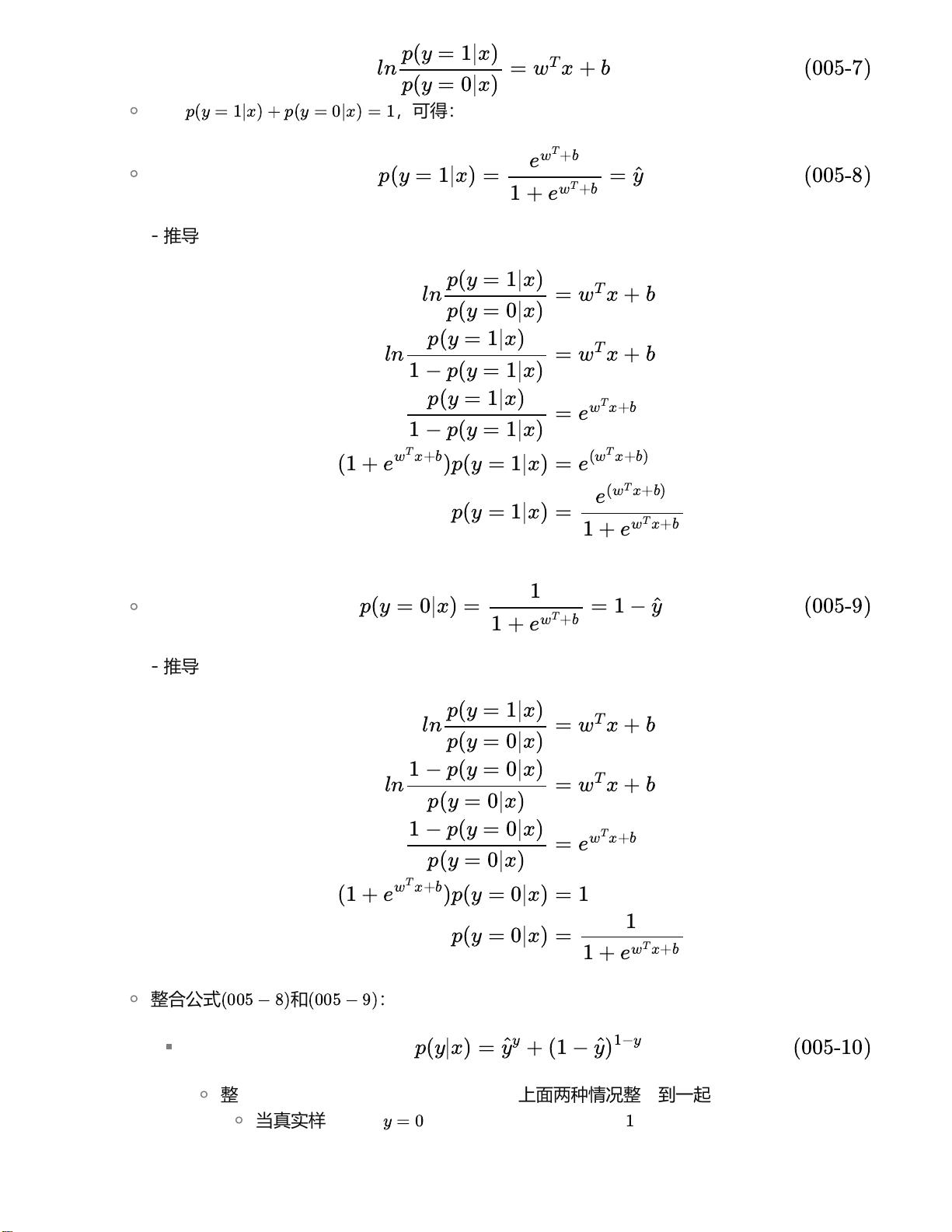

对数几率回归的数学表达式可以表示为 \( \ln\left(\frac{y}{1 - y}\right) = w^Tx + b \),其中 \( w \) 是权重向量,\( x \) 是特征向量,\( b \) 是偏置项。这个公式意味着对数几率(log odds)与输入特征线性相关。通过求解最小化损失函数来估计最优的 \( w \) 和 \( b \) 参数,一般采用的是经典的交叉熵损失函数。

在训练集 \((x_i, y_i)\) 上,对数几率回归的目标是找到最能拟合数据的参数,以使得模型预测的类后验概率 \( p(y=1|x) \) 与真实标签尽可能接近。具体来说,模型的预测输出 \( \hat{y} = \frac{1}{1 + e^{-(w^Tx + b)}} \),而损失函数可以写为 \( -\sum_{i=1}^{m} [y_i \ln(\hat{y}_i) + (1 - y_i) \ln(1 - \hat{y}_i)] \)。通过反向传播和梯度下降等方法,我们可以更新模型参数以最小化损失函数,从而提高模型的分类性能。

在Python中实现对数几率回归,既可以使用numpy等基础库自行编写算法,也可以利用成熟的机器学习库如sklearn,其提供了现成的LogisticRegression类,可以直接调用进行模型训练和预测,大大简化了开发流程。

对数几率回归由于其简单高效的特点,在信用卡违约预测、广告点击率预测、疾病诊断、垃圾邮件识别等诸多业务场景中都有广泛应用。理解并掌握对数几率回归的原理和实现方法对于提升机器学习实践能力至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-10-22 上传

2021-09-30 上传

2023-10-01 上传

Bachelor_Hu

- 粉丝: 124

- 资源: 14

最新资源

- 火炬连体网络在MNIST的2D嵌入实现示例

- Angular插件增强Application Insights JavaScript SDK功能

- 实时三维重建:InfiniTAM的ros驱动应用

- Spring与Mybatis整合的配置与实践

- Vozy前端技术测试深入体验与模板参考

- React应用实现语音转文字功能介绍

- PHPMailer-6.6.4: PHP邮件收发类库的详细介绍

- Felineboard:为猫主人设计的交互式仪表板

- PGRFileManager:功能强大的开源Ajax文件管理器

- Pytest-Html定制测试报告与源代码封装教程

- Angular开发与部署指南:从创建到测试

- BASIC-BINARY-IPC系统:进程间通信的非阻塞接口

- LTK3D: Common Lisp中的基础3D图形实现

- Timer-Counter-Lister:官方源代码及更新发布

- Galaxia REST API:面向地球问题的解决方案

- Node.js模块:随机动物实例教程与源码解析