FPGM:基于几何中值的滤波器压缩方法,提升CNN效率

167 浏览量

更新于2024-06-19

收藏 1.13MB PDF 举报

"本文主要介绍了一种新的滤波器压缩方法——FPGM(Filter Pruning via Geometric Median),该方法针对深度卷积神经网络(CNN)中的滤波器进行剪枝,旨在降低模型的计算复杂度,提高运行效率。传统方法通常依据滤波器的范数大小来判断其重要性,而FPGM则不依赖这两个要求:滤波器的范数偏差大和最小范数小。实验表明,FPGM在保持模型性能的同时,能有效减少FLOPs,适用于CIFAR-10和ILSVRC-2012数据集上的ResNet模型。"

在深度学习领域,尤其是计算机视觉任务中,深度卷积神经网络(CNN)由于其强大的表达能力而广泛应用。然而,随着网络深度和宽度的增加,计算成本也随之增加,这限制了模型在资源有限的设备上的部署。因此,研究如何压缩模型,减少计算量成为了一个重要的课题。

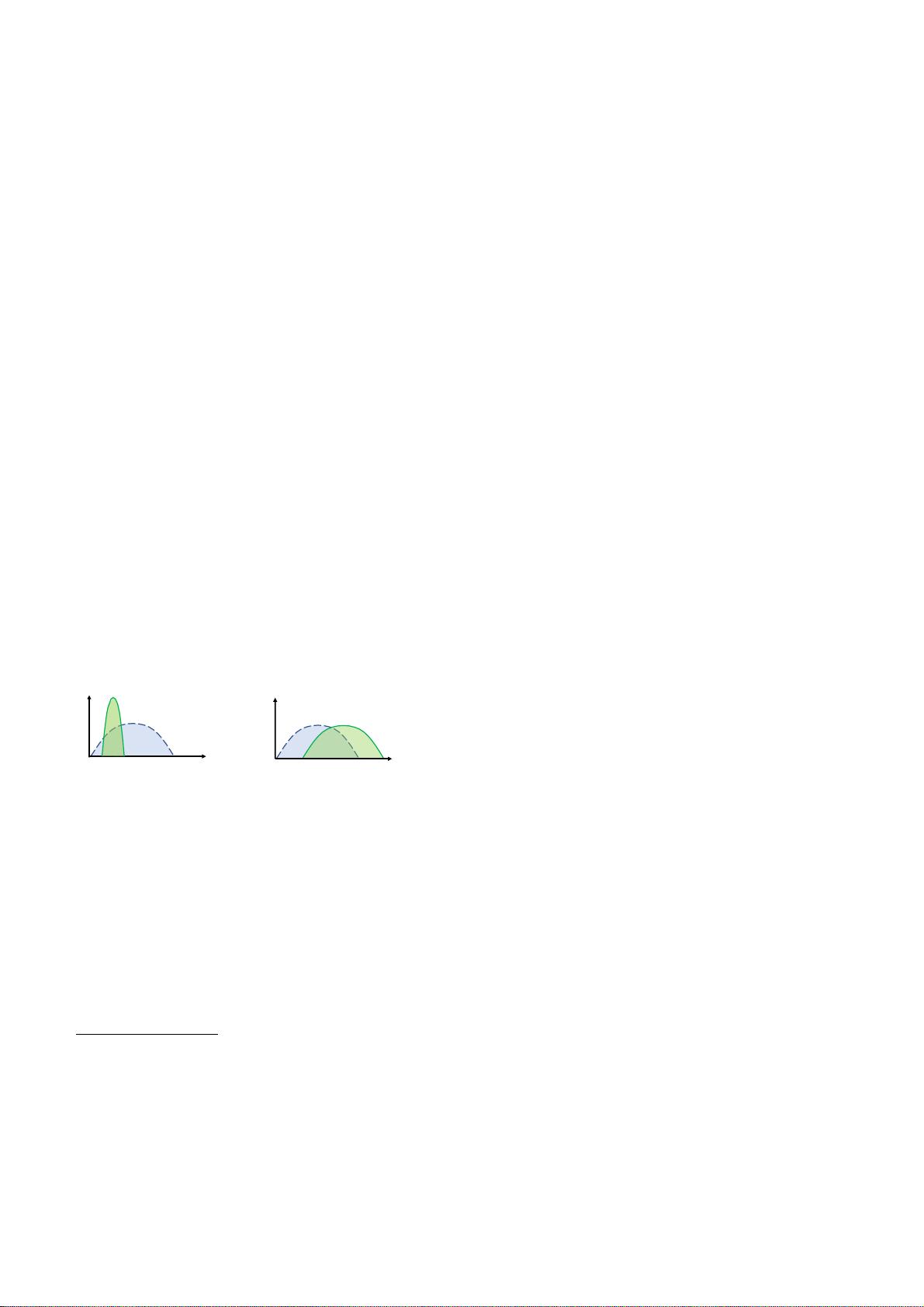

传统的滤波器压缩方法通常基于“小范数不重要”原则,即认为范数较小的滤波器对模型的贡献不大,可以被剪枝。然而,这种方法的有效性依赖于两个假设:滤波器的范数偏差较大,且最小范数趋向于0。在实际应用中,这些条件可能不总是成立。

FPGM方法则提出了一种不同的策略。它通过几何中值(Geometric Median)来确定哪些滤波器是冗余的,而不是简单地依赖于范数的大小。几何中值是一种统计概念,用于找到一组点的“中心点”,在某些方面比算术平均数更具鲁棒性。FPGM利用这一特性,修剪那些在滤波器集合中位置相对“孤立”的滤波器,而不是仅仅关注它们的范数大小。

在CIFAR-10数据集上,FPGM在ResNet-110模型上实现了超过52%的FLOP减少,同时仅损失2.69%的精度,这是显著的优化。在ILSVRC-2012年数据集的ResNet-101模型上,FPGM能够在不降低前5名精度的情况下减少超过42%的FLOP,优于现有的先进水平。

该研究不仅提出了一种新颖的滤波器剪枝方法,还为CNN模型的压缩提供了一种更灵活、鲁棒的策略。通过FPGM,模型可以实现更高的计算效率,适应资源受限的环境,这对于移动设备和边缘计算场景尤为重要。源代码已在GitHub上开源,供研究者和开发者进一步探索和应用。

361 浏览量

184 浏览量

192 浏览量

点击了解资源详情

106 浏览量

425 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- 手机电商应用程序UI套件-Sketch素材_psd素材_XD素材_Figma素材.zip

- weather-app-[removed]javascript实践(需要重构)

- kids-learning-center:该网站是使用Reactjs开发的,可帮助孩子们上课

- API取驱动器列表模块.rar

- Support-Vector-Machine.zip_人工智能/神经网络/深度学习_R_language_

- 实践1

- 超强的个人简历PPT动画.rar

- 循环冷却水处理

- Snake:用C ++ OpenGL编写的Snake游戏克隆

- first-redux:first-redux登录

- 保管库:类型安全的持久存储,可存储任意类型的值

- API取键盘指示灯状态.rar

- CATSettings-21.zip

- 传统文化孔子国学培训PPT模板.rar

- QIFPPB.rar_系统/网络安全_C/C++_

- iwatch手表界面xd素材.zip