深度学习实战:一步步教你用Python和Keras构建AlphaZero

需积分: 12 116 浏览量

更新于2024-09-01

收藏 1.09MB PDF 举报

"techpackage.net-手把手教你搭建AlphaZero(使用Python和Keras).pdf"

AlphaZero是由DeepMind开发的一种强化学习算法,它在无需人类知识的情况下,通过自我对弈学习策略,达到了在围棋、国际象棋和日本将棋等复杂棋类游戏中的顶尖水平。本教程主要针对Python和Keras框架,教你如何构建一个类似的AlphaZero系统。

首先,理解AlphaZero的基本原理至关重要。AlphaZero的核心在于结合蒙特卡洛树搜索(MCTS)和深度神经网络。神经网络负责评估棋盘状态的价值和选择下一步动作的概率,而MCTS则用于模拟未来可能的走法,通过大量随机模拟来优化选择。

在开始编写代码之前,建议先阅读相关的理论文章,如AlphaGoZero的知识点速查手册和Tim Wheeler的博客,这些资料可以帮助你深入理解AlphaZero的工作机制。一旦理论基础扎实,就可以开始动手实践。

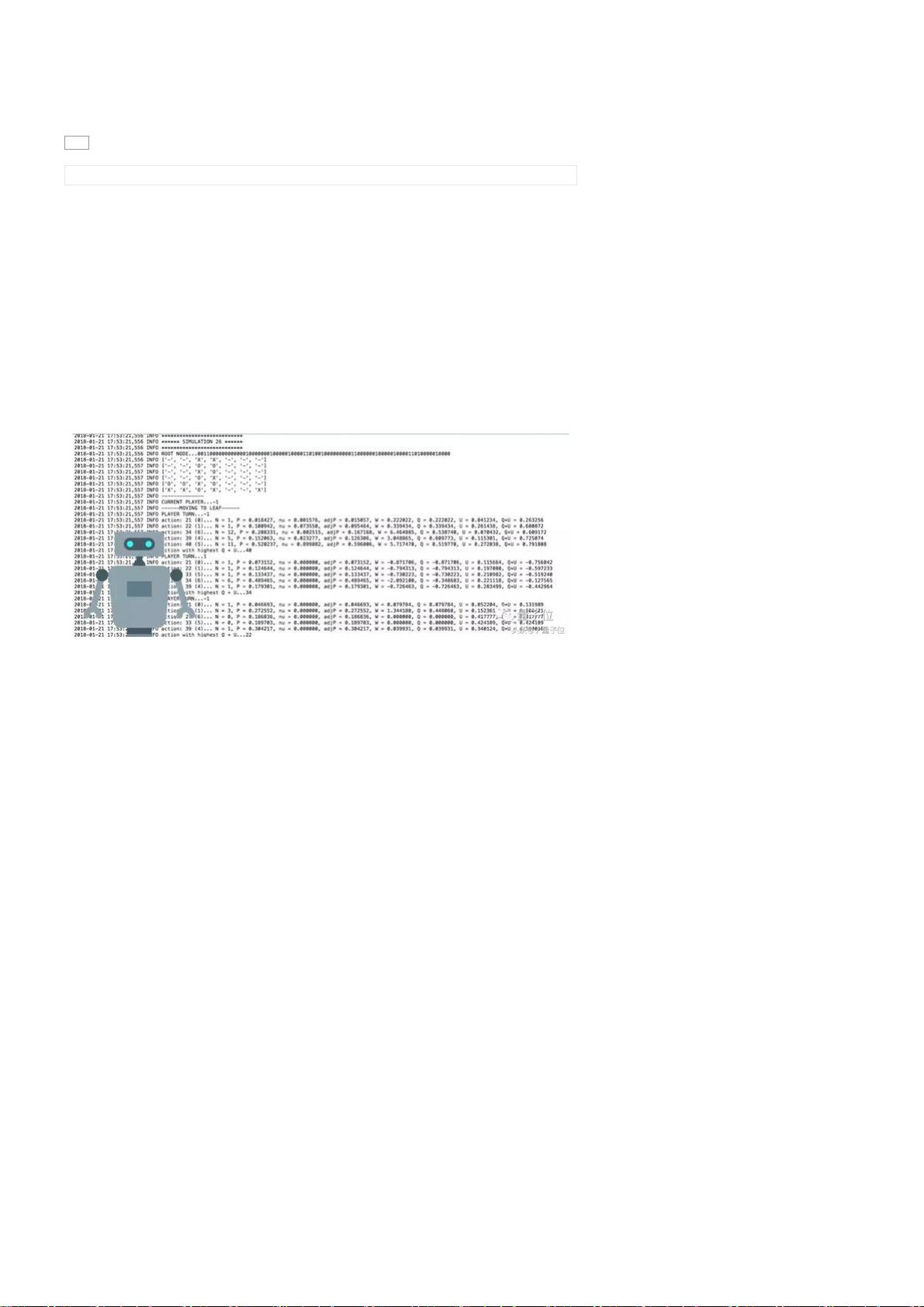

在提供的代码库中,`run.ipynb`是一个Jupyter Notebook,你可以从运行前两个单元格开始。这些单元格会设置环境,初始化游戏和神经网络模型。随着自我对弈和训练的进行,模型会逐步提升其预测游戏状态价值和选择最佳行动的能力。

教程选择了Connect4作为示例游戏,因为它的规则简单,但状态空间依然庞大,这有助于演示AlphaZero算法如何处理复杂决策问题。在Connect4中,每个玩家的目标是让自己的四个棋子在直线上连成一线。尽管相比围棋,Connect4的复杂度较低,但它提供了足够的挑战来展示强化学习的威力。

在实际编码过程中,你需要实现以下几个关键部分:

1. **游戏环境**:定义游戏的规则,包括合法的移动、游戏结束条件以及获取当前状态等。

2. **神经网络模型**:使用Keras构建一个能够预测游戏状态价值和动作概率的模型。通常,模型会包含一个价值分支和一个策略分支。

3. **蒙特卡洛树搜索**:实现MCTS算法,该算法会根据神经网络的预测来指导搜索,选择最优行动。

4. **自我对弈**:让训练的模型与自身对弈,生成新的训练数据。

5. **训练循环**:使用自我对弈产生的数据更新神经网络,不断迭代优化。

6. **评估与调整**:定期评估模型的性能,根据结果调整参数和训练策略。

通过以上步骤,你将能够构建出一个能够学习和改进的AlphaZero代理,它会在不断的自我对弈中提升游戏技能。这种学习方式不仅适用于棋类游戏,还可以应用于其他需要决策和策略的环境,比如机器人控制、电子游戏等。

最后,要注意的是,AlphaZero的成功不仅在于算法本身,还在于其高效的自我学习和优化机制。因此,在实现过程中,优化计算效率和平衡探索与利用之间的关系也是至关重要的。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-05-24 上传

2023-06-08 上传

AttributeError:module'tensorflow.python.keras.api._v1.keras.datasets.mnist' has no attribute 'train'

2024-02-22 上传

2023-06-09 上传

2019-08-23 上传

xieheng_79

- 粉丝: 2

- 资源: 214

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率