决策树与随机森林:理解、应用与进阶

需积分: 23 98 浏览量

更新于2024-07-18

2

收藏 2.51MB PDF 举报

决策树与随机森林是机器学习中的重要概念,它们属于监督学习方法,特别适用于处理分类和回归问题。本文档主要涵盖了决策树的基础原理、构建过程以及其在实际场景中的应用,如预测小明是否出门打球的案例。

1. **决策树(Decision Tree)**

- 决策树是一种基于树状结构的模型,通过一系列规则(特征)对数据进行划分,每个内部节点代表一个特征测试,每个分支代表该特征的一个取值,叶子节点表示最终的预测结果。

- 决策树的构建遵循分治思想,即将数据集不断分割成纯(所有样本属于同一类)或不纯(包含多个类别)的子集,直到达到预定停止条件。

2. **熵(Entropy)** 和 **信息增益(Information Gain)**

- 熵是衡量数据不确定性的一种度量,用于评估划分数据集的纯度。信息增益则是通过比较划分前后数据集的熵,选择信息增益最大的特征作为划分依据,以减小不确定性。

3. **过度拟合(Overfitting)** 和 **剪枝(Pruning)**

- 决策树容易过拟合,即模型在训练集上表现良好但泛化能力差。剪枝技术通过减少决策树的复杂性,防止过拟合,提高模型的稳定性。

4. **增益率(Gain Ratio)**

- 除了信息增益,另一种常用的特征选择标准是增益率,它考虑了特征选择带来的信息增益与引入新特征的代价之间的比率。

5. **决策树的应用场景**

- 决策树可用于多种场景,包括连续函数的离散化处理(如将数值范围分为多个区间),多分类问题,以及回归问题,如预测小明是否出门打球的示例中,根据天气、湿度和风力等级做出决策。

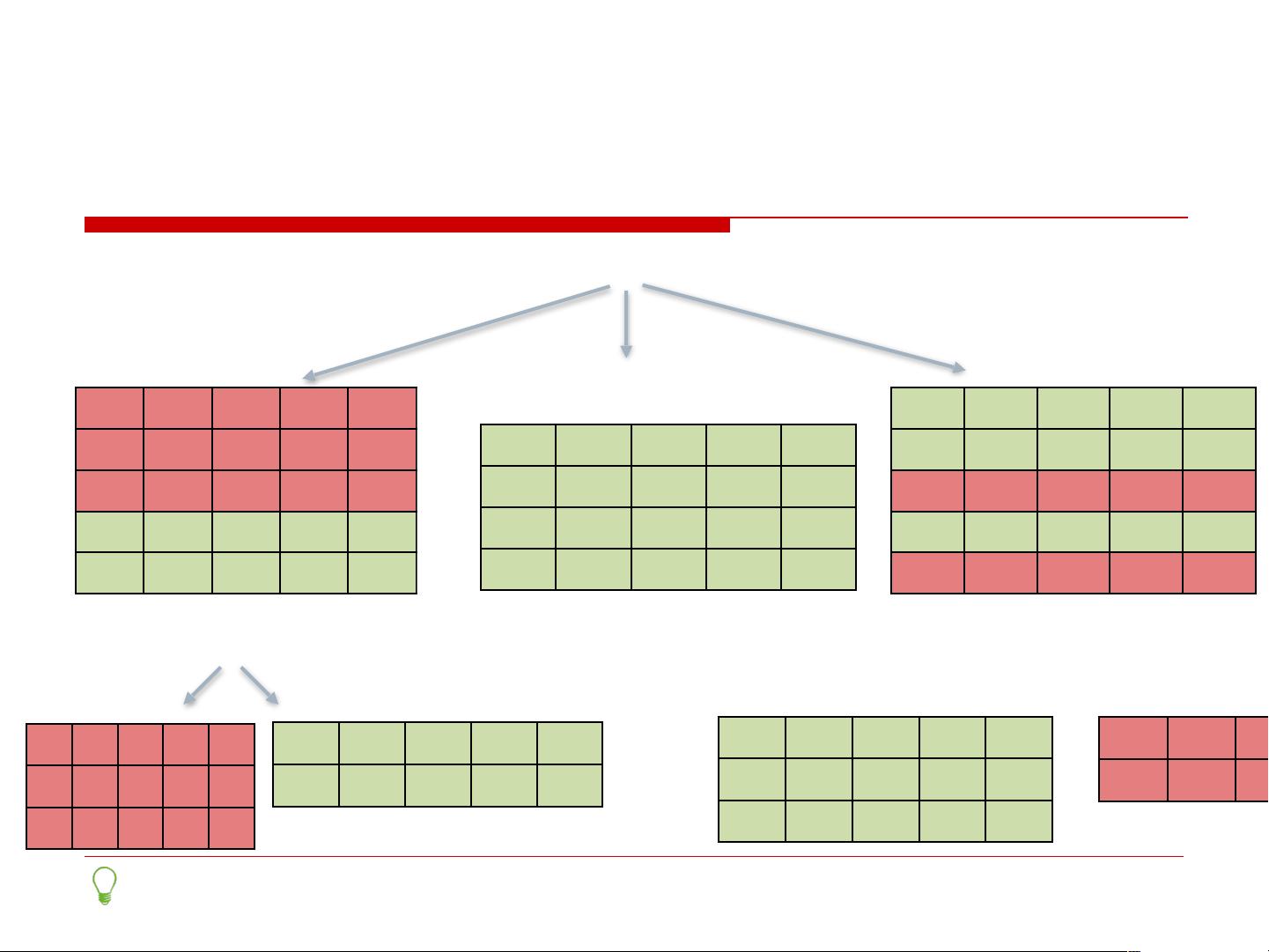

6. **随机森林(Random Forest)**

- 随机森林是决策树的集成方法,通过构建多棵决策树并集成它们的预测结果。它通过随机选取特征和样本,降低单个树的过拟合风险,提高整体预测准确性。

7. **GBDT(Gradient Boosting Decision Trees)** 和 **XGBoost**

- GBDT是一种梯度提升算法,每次迭代时,它会添加一个新的决策树来改正前一轮模型的错误。XGBoost是对GBDT的优化版本,具有更高的效率和性能,尤其在处理大规模数据时表现出色。

8. **实例演示**

- 文档中通过实际案例展示了如何使用决策树进行小明是否出门打球的预测,通过分析天气、湿度和风力等级,逐步构建决策树模型并作出预测。

这篇文档深入浅出地介绍了决策树及其进阶版本随机森林在机器学习中的基本原理和应用技巧,适合初学者和有一定经验的学习者进一步理解这些强大的工具。

2022-08-08 上传

2021-09-11 上传

2021-09-10 上传

2023-02-08 上传

2022-12-04 上传

点击了解资源详情

点击了解资源详情

女王の专属领地

- 粉丝: 4368

- 资源: 49

最新资源

- bt3破解无客户端wep简明教程图文版.pdf

- AT89C51单片机实验指导教程

- 本科生毕业设计格式(撰写规范)

- 动态词法分析的设计与实现

- 立方Ireport用户手册.pdf

- QtEmbedded实例教程.pdf

- 全面剖析XMLHttpRequest对象

- 棉花收购系统解决方案

- linux C程序中获取shell脚本输出(如获取system命令输出)

- 国外精典教材O’Reilly - Programming C#, 2nd Edition (VBL)

- linux 编程 函数接口锦集

- opencv使用手册

- 常用正则表达式(总结归类)

- ejb3.3实例教程

- socket开发指南

- 地图学实习题目集锦——色环等上机实习练习题目