"初学卷积神经网络与反向传播:矩阵运算、激活层、Softmax处理与交叉熵损失"

需积分: 18 54 浏览量

更新于2024-04-16

收藏 8.9MB DOCX 举报

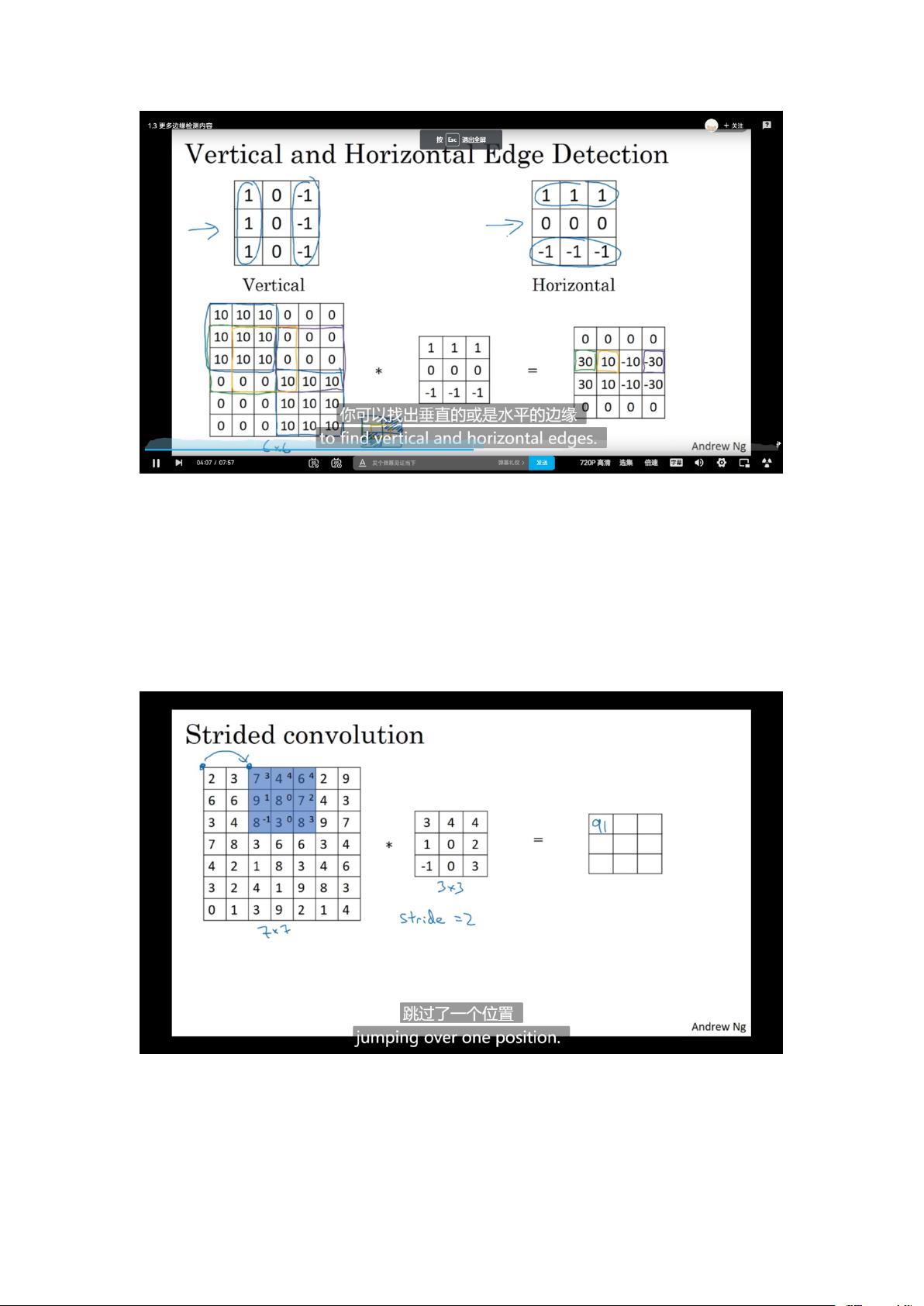

深度学习卷积神经网络是一种强大的神经网络模型,通过层层堆叠卷积、池化、激活等结构,可以从原始数据中学习到复杂的特征表示,并实现对复杂任务的高效处理。在卷积神经网络中,神经元之间的连接方式不同于传统的全连接神经网络,采用局部连接和权值共享的方式,减少了参数数量同时增加了特征提取的效率。卷积神经网络的核心是卷积操作和池化操作,通过卷积操作可以提取局部特征,而通过池化操作可以减小数据维度并保留主要特征。

神经网络的传播是通过矩阵运算来实现的,其中 Y=WX+b 表示神经元之间的线性变换,其中 W 为权重矩阵,b为偏置向量,X为输入数据。为了引入非线性,需要在隐藏层中加入激活函数,常用的激活函数包括ReLU、Sigmoid、Tanh等。在分类问题中,输出层通常经过Softmax层处理,将输出转化为概率值,再通过交叉熵损失函数来评估网络的性能。通过计算交叉熵损失,可以得到当前网络的优劣程度,进而进行参数的优化。

反向传播是优化神经网络参数的过程,通过不断更新权重和偏置来使网络的预测结果更加接近真实标签。反向传播的关键是求解梯度,通过链式规则不断传递误差,最终计算出每个参数对损失函数的梯度。神经网络的训练过程就是反复迭代这个过程,不断调整参数使网络的性能不断提升。

在图像分类任务中,计算机将图片表示为一个像素值的矩阵,根据图片的分辨率和通道数不同,这个矩阵的大小也会有所差异。每个像素值代表了图像在该位置的像素强度,而对于计算机来说,这些数字就是输入数据。通过将这些输入数据传入神经网络,网络可以学习到图像的特征表示,并实现对图像的分类。从这个角度来看,神经网络实际上是在学习如何将输入数据映射到不同类别的可能性,从而实现图像分类任务的目的。

综上所述,卷积神经网络通过卷积操作和池化操作来提取特征,通过多层堆叠实现对复杂特征的学习,通过激活函数和Softmax层实现非线性和概率输出,通过反向传播优化参数使网络学习更好的特征表示,最终实现对图像等数据的分类任务。神经网络的训练过程是一个不断迭代的优化过程,通过不断调整权重和偏置使网络的性能不断提升,从而实现更加准确的分类结果。神经网络的应用前景广阔,将会在各个领域实现更加智能化的数据处理和决策。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-01-20 上传

2022-06-19 上传

2024-09-30 上传

2023-09-02 上传

2021-01-06 上传

2017-11-16 上传

初岘

- 粉丝: 425

- 资源: 1

最新资源

- adanque.github.io

- 常用的三个Button按钮案例

- hello-world-apis:API API de grafos的世界您好

- Accuinsight-1.0.20-py2.py3-none-any.whl.zip

- 行业分类-设备装置-基于智能家居控制系统项目的DSP应用技术教学设备.zip

- Algorithm-Book:一个包含各种数据结构和算法代码的 Web 应用程序

- 基于PHP的最新仿53客服网站在线客服系统商业版php源码.zip

- Pre-trained Word Vectors for Spanish 西班牙语的预训练词向量-数据集

- Android剪切图片的Demo

- A5Orchestrator-1.0.1-py3-none-any.whl.zip

- .NET一个简单的媒体播放器的ASP毕业设计(源代码+论文).zip

- ngrinder_scripts

- TasClock:自由职业者和其他想要管理自己时间的人的 Android 任务管理器

- akandelanre.github.io:个人网页

- 封装的启动引导图

- phrg-js-spa-project:PCA JS SPA项目