深度学习生成模型:去噪扩散模型的基础与应用

版权申诉

"CVPR 2022 Tutorial Denoising Diffusion-based Generative Model"

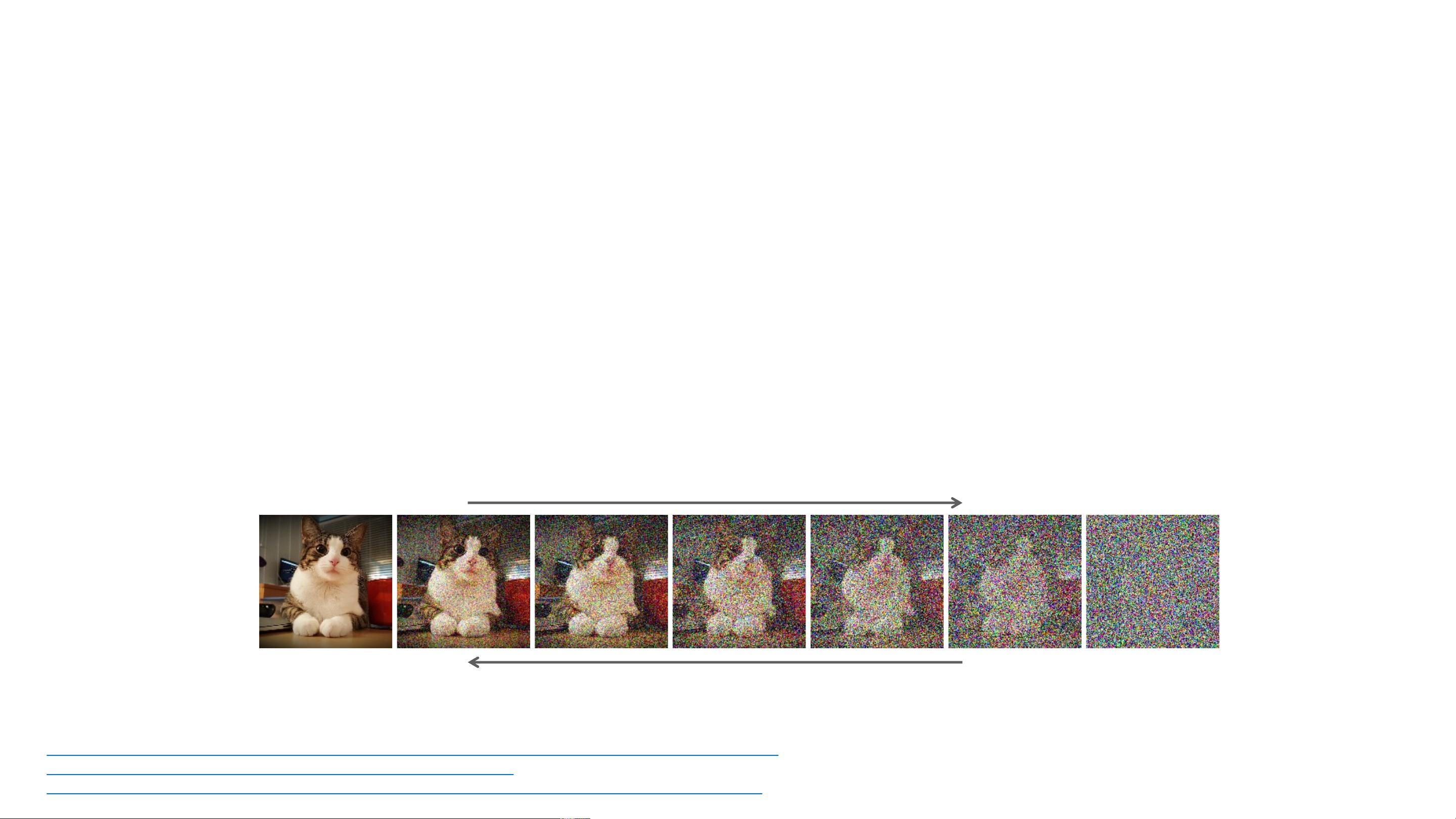

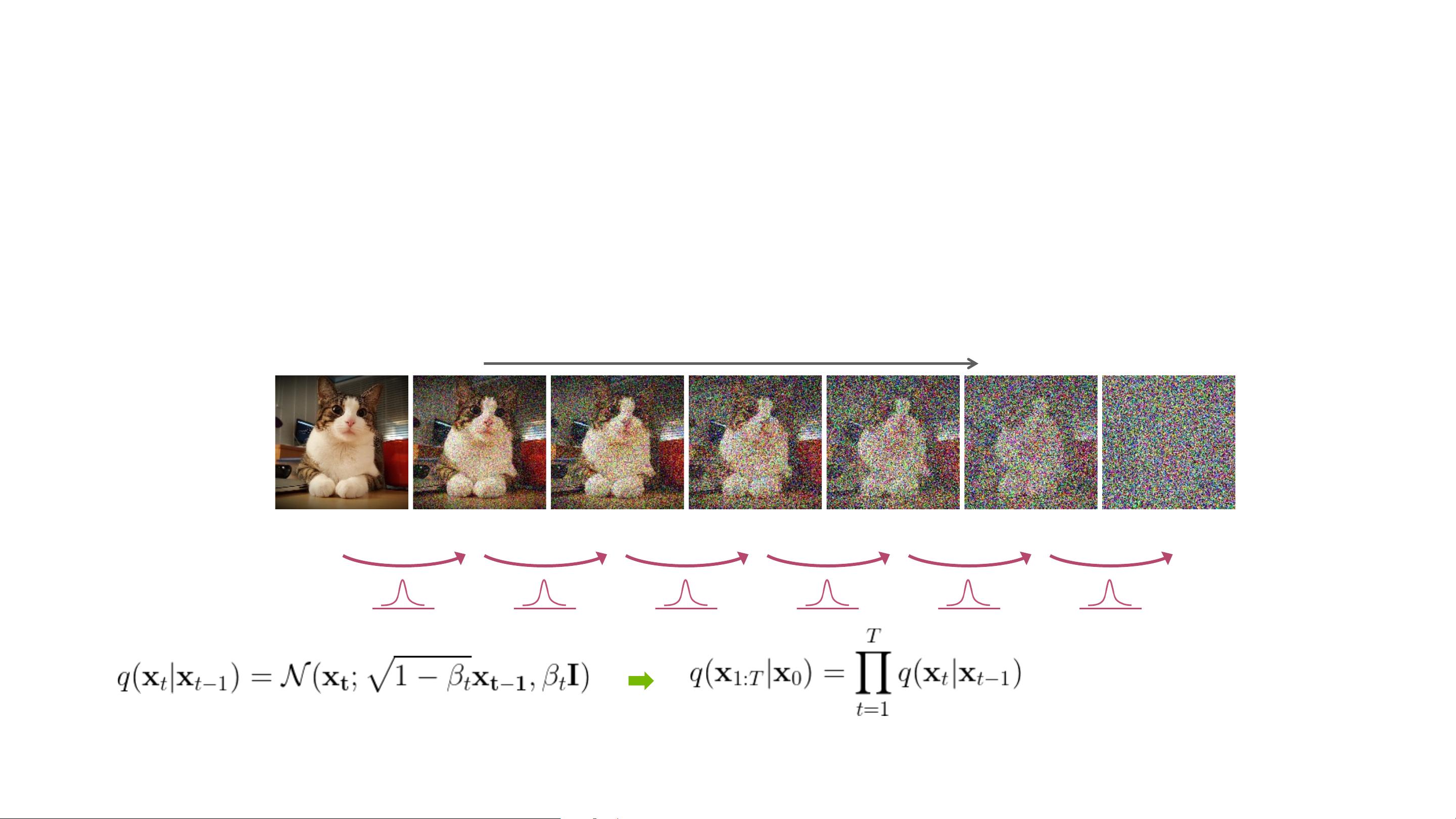

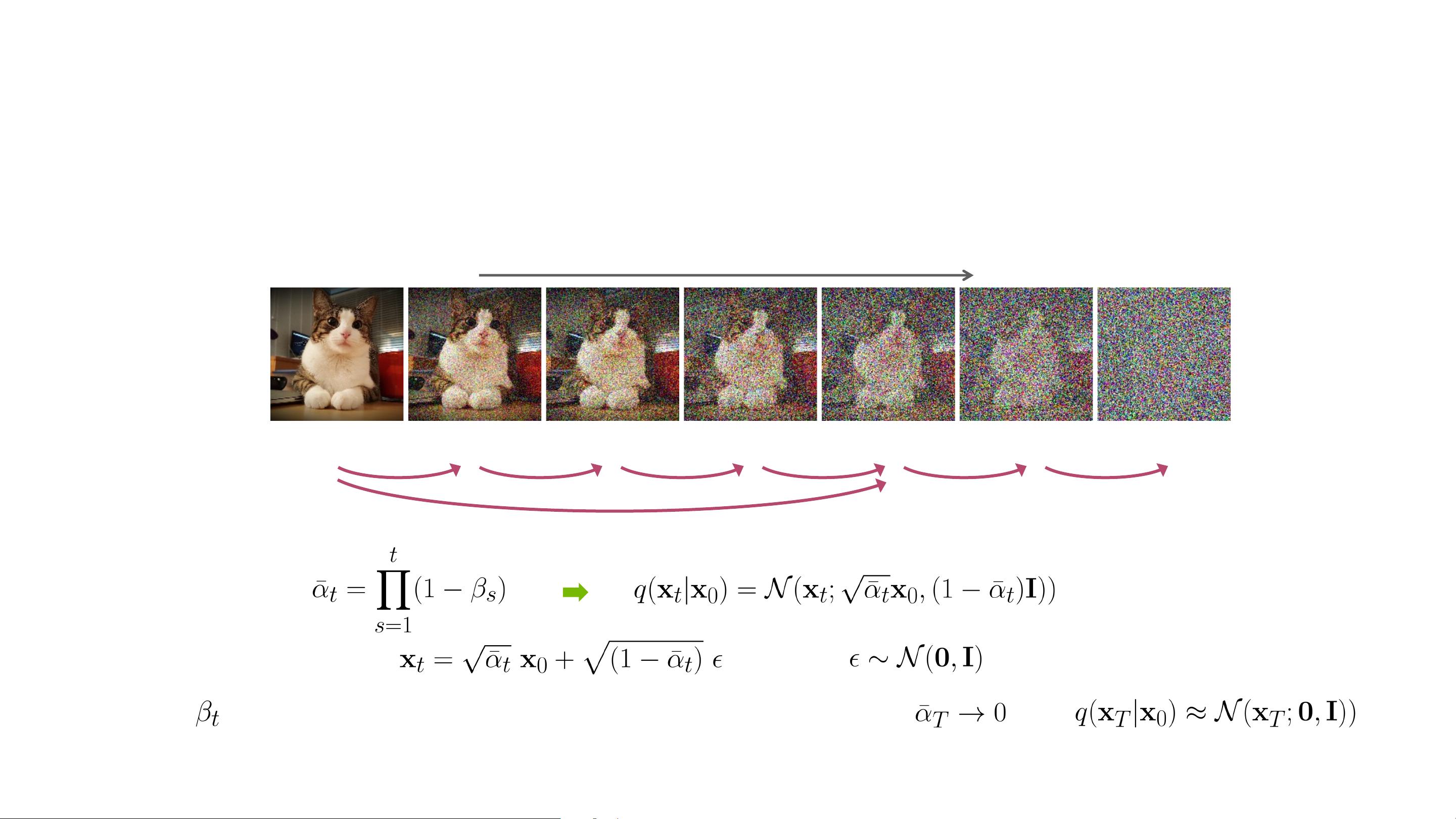

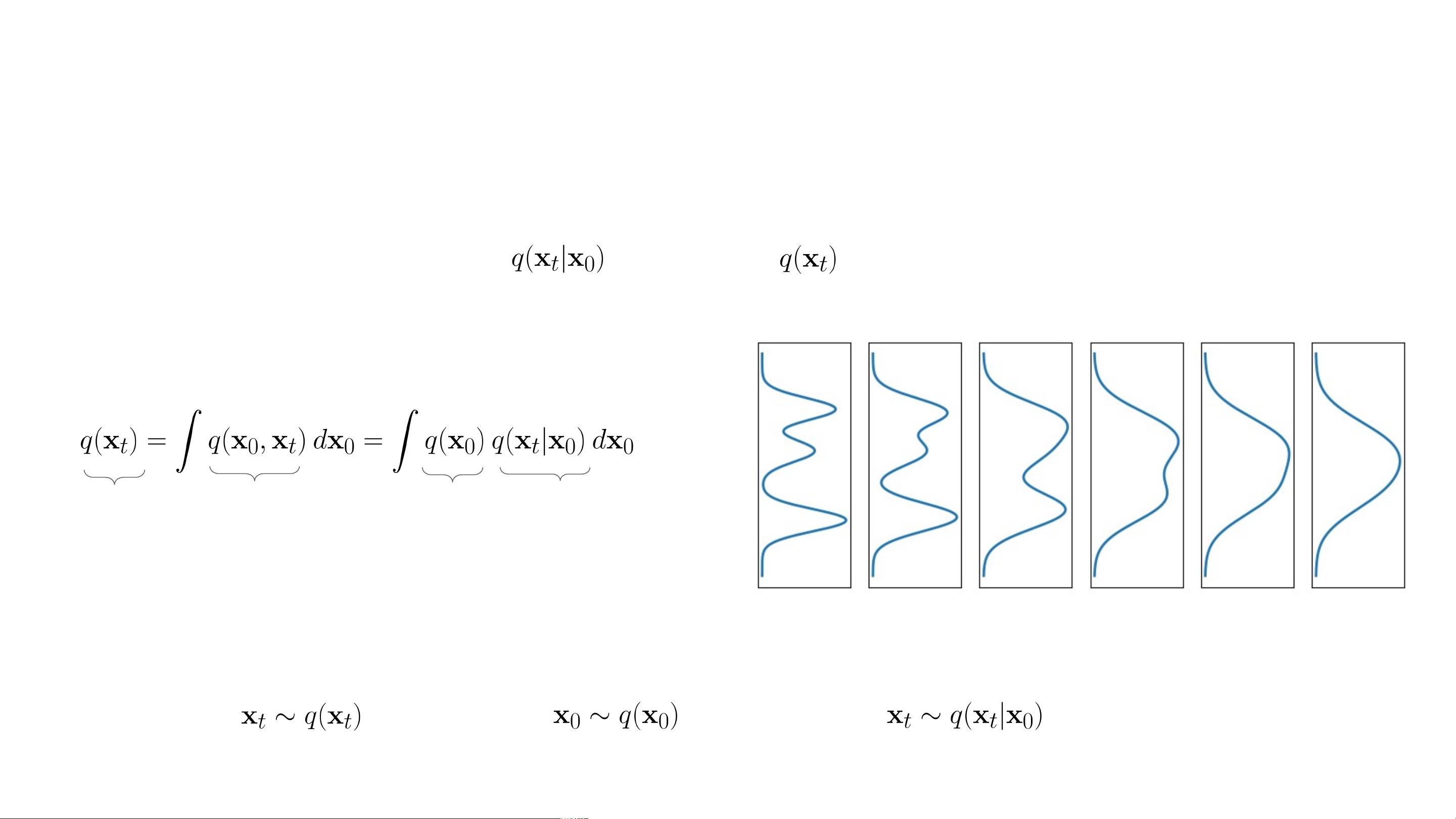

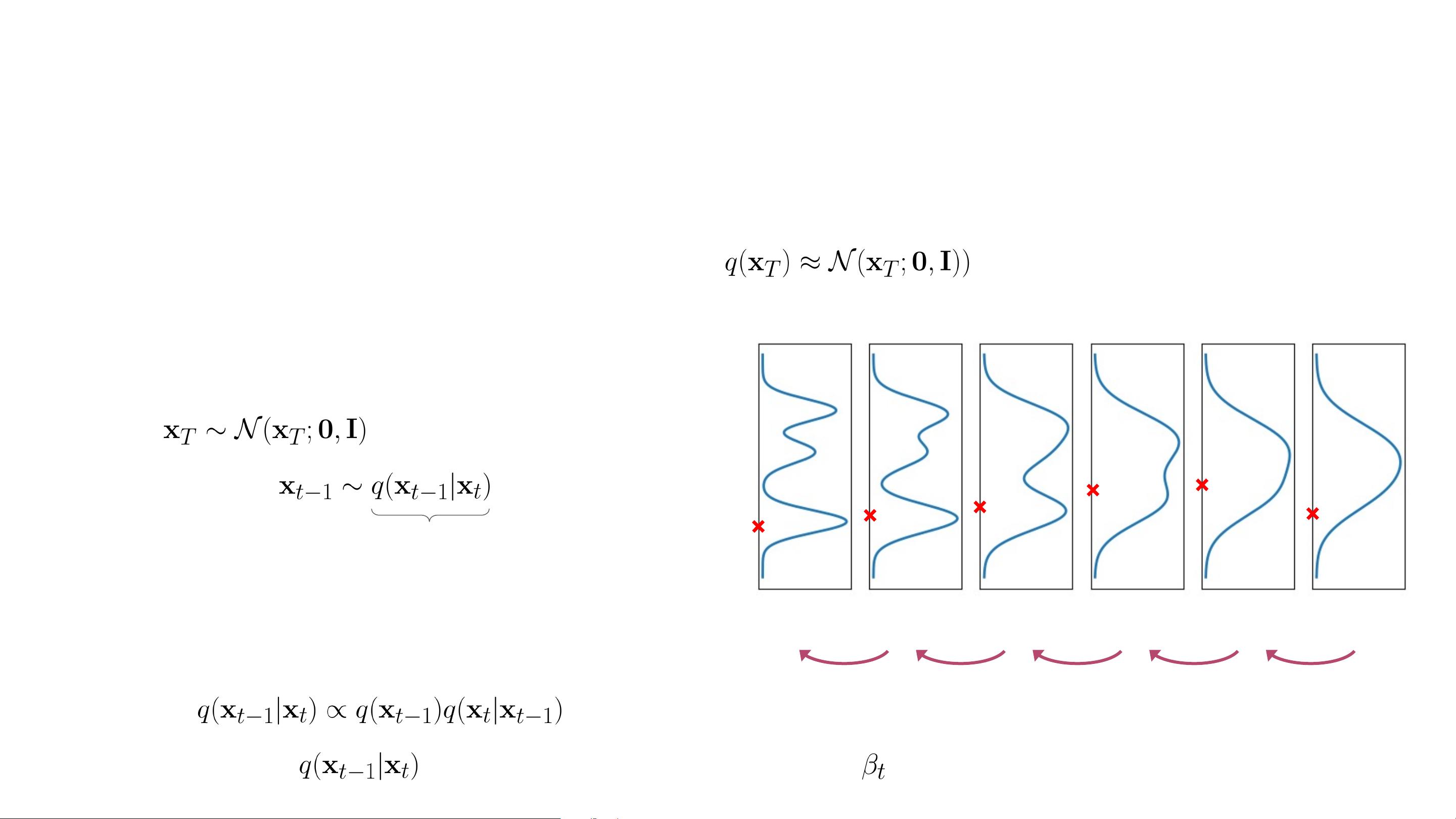

本文档是CVPR 2022期间的一个教程,由CVPR、NVIDIA和Google AI等权威机构联合提供,主题聚焦于去噪扩散模型在生成技术中的基础理论与应用实践。这个188页的教程详细介绍了去噪扩散模型这一新兴且强大的生成模型类型,特别是在高保真图像生成领域的卓越性能,其效果往往超越了传统的生成对抗网络(GANs)。去噪扩散模型通过逐步引入噪声将数据映射到随机噪声空间,然后通过学习的逆向过程,即参数化的降噪过程,从纯随机噪声中生成数据。由于其样本多样性和对数据分布的准确捕捉,这些模型特别适用于处理复杂和多样化的数据集。

去噪扩散模型的应用广泛,涵盖以下几个方面:

1. 内容生成:在计算机视觉领域,扩散模型可以用于图像编辑,创造出高度逼真的新图像。例如,StyleGAN3展示了生成逼真人物图像的能力。

2. 表示学习:利用有限的标注数据,扩散模型能够学习到有效的表示,减少对大量标注数据的依赖。如DatasetGAN和利用生成模型进行半监督学习和强领域外泛化的语义分割方法。

3. 艺术工具:NVIDIA的GauGAN是艺术创作工具的实例,它使用扩散模型实现语义适应的图像合成,使用户能够以简单的画笔操作创建出复杂的自然景观图像。

在深度生成学习的广阔领域中,去噪扩散模型与其他模型如能量基模型、自回归模型、正则化流、生成对抗网络和变分自编码器并列。这些模型各有优势,但去噪扩散模型的独特之处在于其在降噪过程中的迭代优化,使得它在生成任务中展现出优异的性能和灵活性。

这篇教程深入探讨了去噪扩散模型的基本原理,提供了丰富的应用案例,并可能启发更多的研究者和开发者在生成模型、图像处理、计算机视觉以及其他相关领域探索新的可能性。

1226 浏览量

121 浏览量

1519 浏览量

153 浏览量

190 浏览量

179 浏览量

201 浏览量

273 浏览量

179 浏览量

一颗小树x

- 粉丝: 4w+

- 资源: 49

最新资源

- 数据结构 C语言版(严蔚敏) 习题集 答案

- C# 绘制常用统计图(柱状图, 折线图, 扇形图)的方法和源码

- 设计模式C++.pdf

- IT常用日语(中日英对照)

- Web_Service开发指南_2.3.1.pdf

- ASP.NET网络编程中常用到的27个函数集

- C#将文件保存到数据库中或者从数据库中读取文件

- DSP选型注意事项!!!!

- 3ds max 专业术语解释

- prototype 权威手册

- Visual C++ MFC 简明教程

- 软件工程思想 介绍软件工程思想的

- Self-Study Guide: WebSphere Studio Application Developer and Web Services

- DSP最小应用系统的设计

- PROTOTYPE.JS 开发者手册(强烈推荐)

- Silverlight 2教程