CUDA 2.0编程指南:入门与API详解

需积分: 9 138 浏览量

更新于2024-08-01

收藏 2.03MB PDF 举报

CUDA编程指南2.0是一份由NVIDIA官方发布的详细教程,旨在帮助开发者理解和掌握CUDA编程技术,这是一种针对图形处理单元(GPU)的并行编程模型。该文档在2008年6月7日更新,针对CUDA 2.0版本,提供了对GPU架构、编程模型、API和编译技巧的深入讲解。

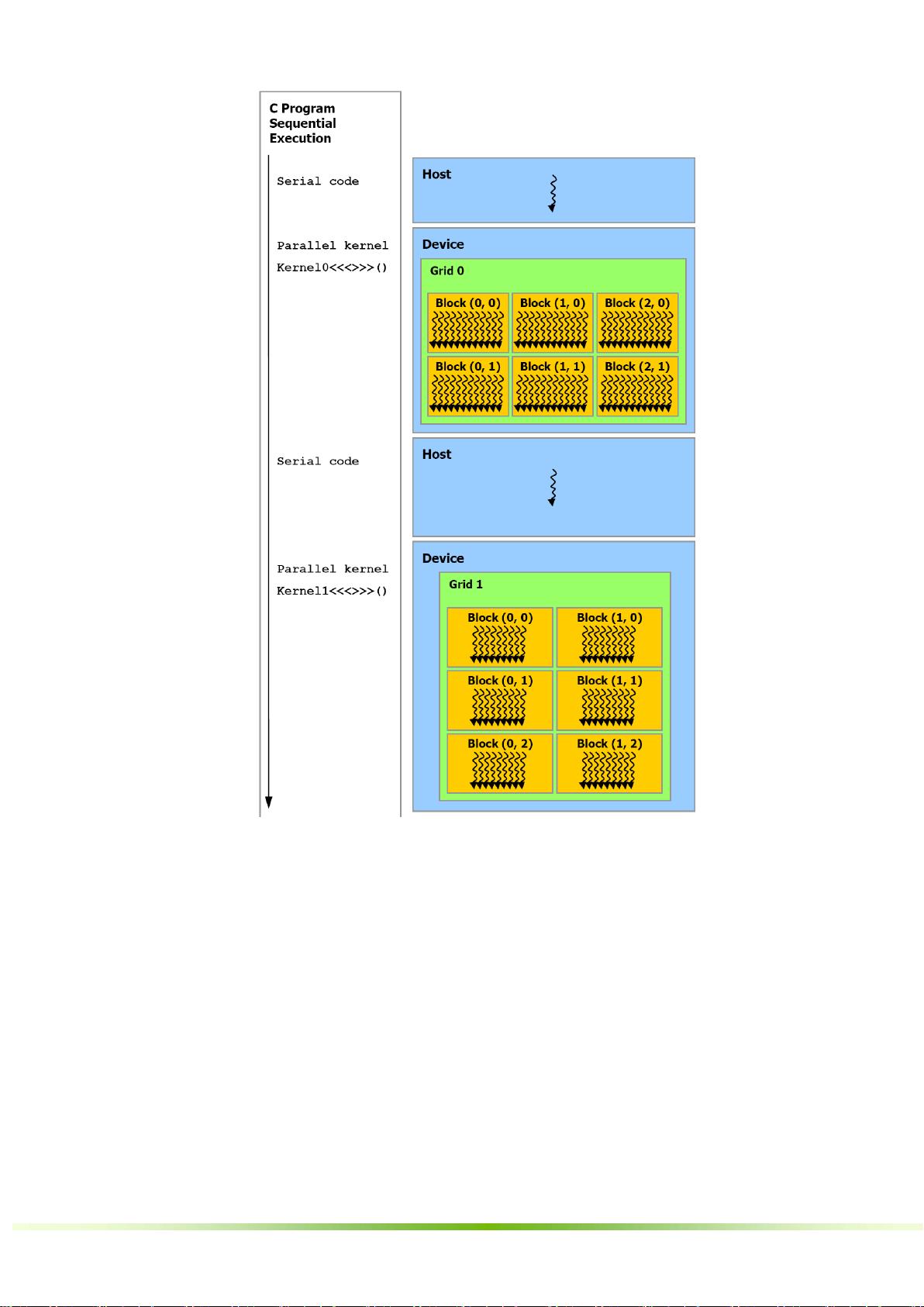

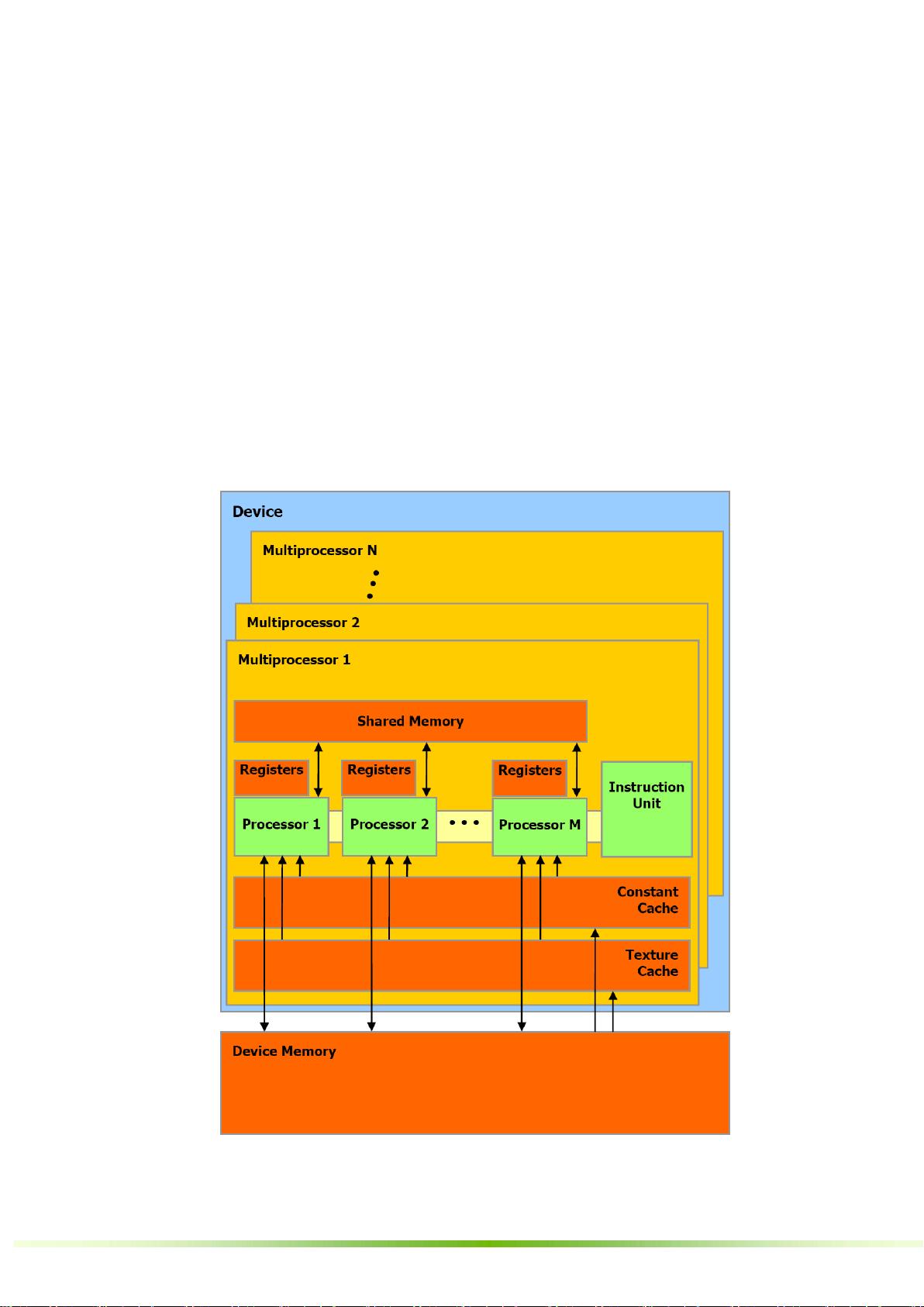

首先,CUDA是一种可伸缩并行编程模型,它利用GPU的高度并行性和多线程特性,将计算任务分解为大量独立的小任务(线程),通过并行执行来提升性能。GPU通常包含多个SIMT(Single Instruction Multiple Threads)多处理器,这些处理器共享存储空间,并且可以同时执行不同的指令。

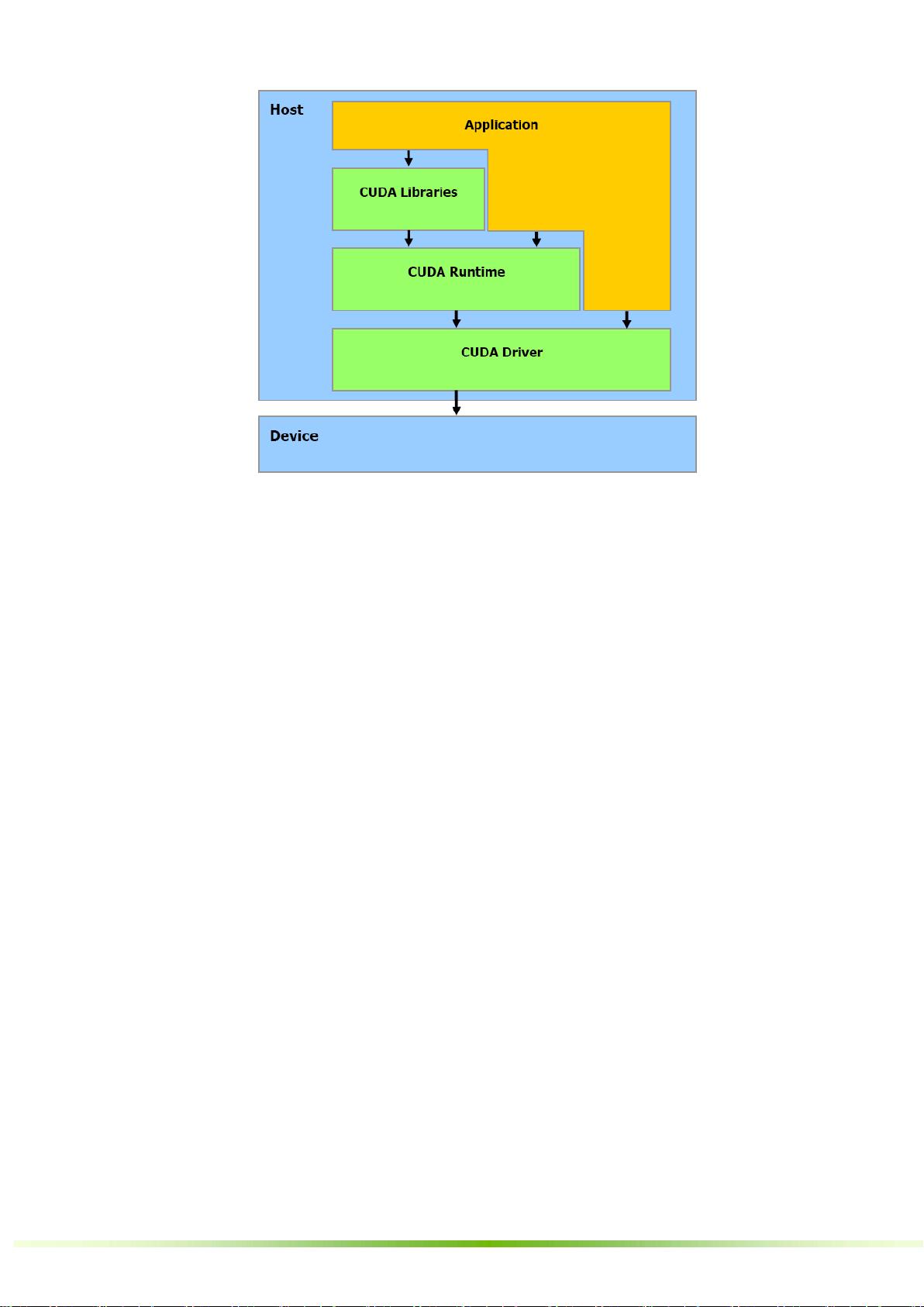

章节2探讨了CUDA的编程模型,包括线程层次结构,如一维线程块和网格,以及存储器层次结构,从全局内存到缓存和共享内存。理解这些概念对于合理分配计算负载和优化数据访问至关重要。此外,文档还强调了主机(CPU)与设备(GPU)之间的交互,以及软件栈的组成,包括驱动程序、CUDA SDK和NVCC编译器。

第3章着重于GPU硬件实现,介绍了具有芯片共享内存的多处理器,以及如何管理多个设备和模式切换。这对于编写能够适应不同GPU硬件的高效代码非常重要。

第4章深入到了CUDA API的具体细节,涵盖了C语言的扩展特性,如函数和变量类型限定符,用于指定函数和变量的执行环境(device、global、host或constant)。此外,还包括执行配置选项,如gridDim、blockIdx等内置变量,以及使用NVCC编译器的技巧,如_noinline_和#pragma unroll等编译指令优化。

通用运行时组件部分介绍了CUDA中的内置向量类型,如char、uchar、float和double等,这些向量类型使得数据并行操作更为方便。通过使用这些向量,开发者可以实现高效的向量化算法,进一步提升计算性能。

CUDA编程指南2.0为想要利用GPU进行加速计算的开发者提供了一套完整的工具和理论基础,从入门到进阶都能找到所需的信息。无论是初次接触CUDA还是希望深入理解其高级特性的开发者,这份文档都是不可或缺的学习资料。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2008-09-19 上传

2024-07-08 上传

180 浏览量

2024-07-07 上传

2021-04-11 上传

hellolegend

- 粉丝: 5

- 资源: 7