Spark作业调度详解:从逻辑执行图到计算链

需积分: 10 29 浏览量

更新于2024-09-12

收藏 5.57MB PDF 举报

"Spark作业调度涉及RDD的创建、转换、行动操作以及依赖关系的构建,是Spark处理数据的核心流程。"

Spark作业调度是大数据处理框架Spark中的关键环节,它负责组织和协调数据处理任务,确保高效、可靠地完成计算。在Spark中,数据是以弹性分布式数据集(Resilient Distributed Dataset,简称RDD)的形式存在。RDD是不可变的、分区的数据集合,具备容错能力。

1. **RDD的创建与转换**

- **创建**: 通过`parallelize()`或`createRDD()`方法从数据源创建初始RDD。数据源可以是本地文件、内存数据结构、HDFS、HBase等。例如,`parallelize()`用于将Java或Scala集合转化为RDD。

- **转换**: RDD支持一系列转换操作,如`map()`、`filter()`、`reduceByKey()`等,这些转换会产生新的RDD。转换操作不会立即执行,而是形成一个任务链,只有当执行行动操作时才会触发计算。

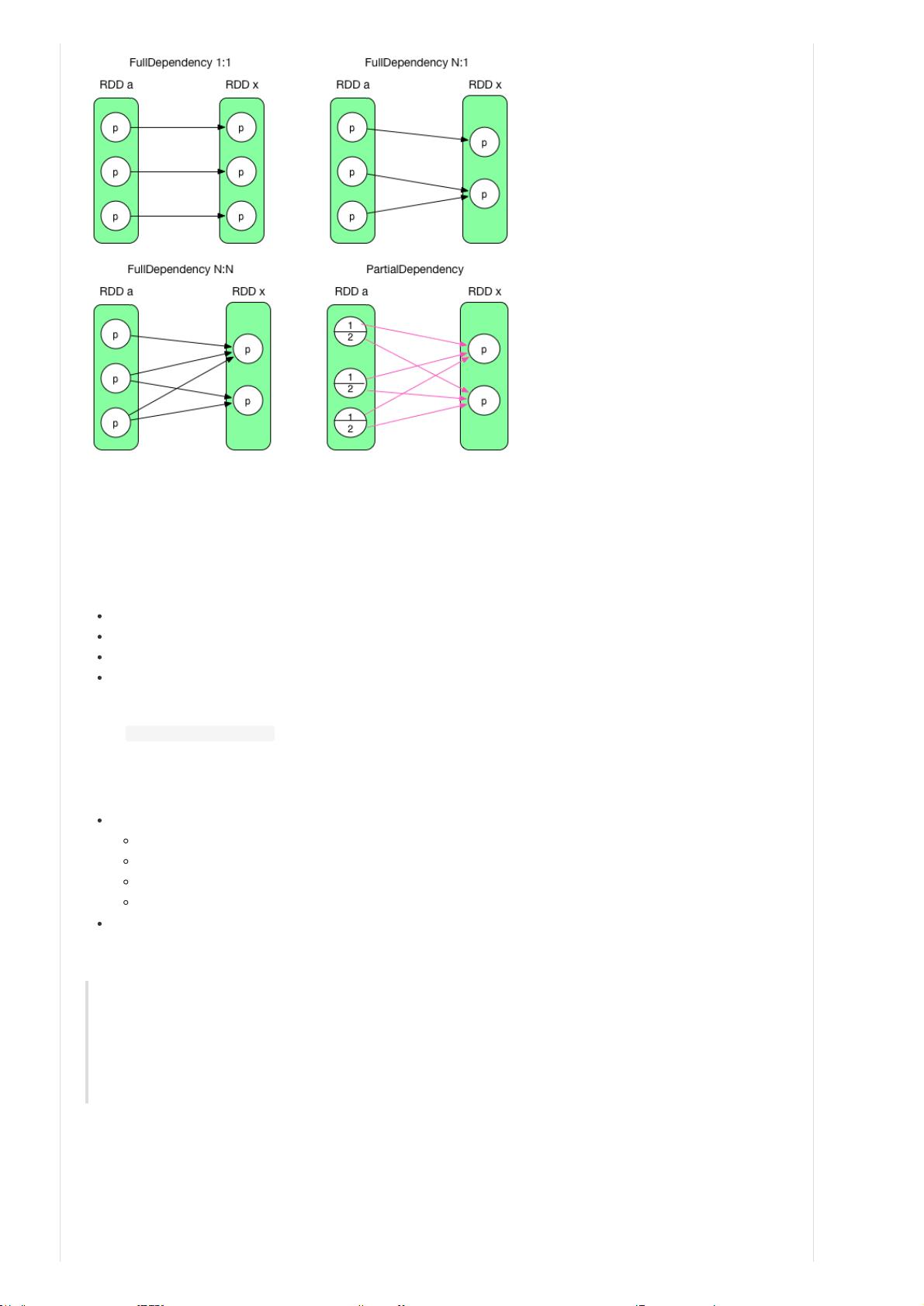

2. **RDD的依赖关系**

- **宽依赖与窄依赖**: RDD间的依赖关系分为两类,宽依赖(全连接依赖)和窄依赖(一对一或一对多依赖)。窄依赖可以在一个分区上并行计算,而宽依赖则需要等待所有父RDD分区计算完毕。理解依赖关系对于优化调度至关重要。

3. **行动操作**

- **行动**: 如`count()`、`collect()`、`saveAsTextFile()`等,它们触发实际的计算并将结果返回给Driver程序或存储到外部系统。`count()`不仅包括`action()`,还包括内部的`sum()`计算。

4. **RDD缓存与检查点**

- **缓存**: `cache()`或`persist()`方法用于将RDD持久化到内存,提高后续重用时的效率。可以选择不同级别的持久化策略,如内存、磁盘甚至跨节点复制。

- **检查点**: `checkpoint()`用于将RDD写入磁盘,提供故障恢复,特别是在大规模数据处理中。

5. **计算逻辑与compute()方法**

- **计算**: 每个RDD都有`compute()`方法,它负责执行来自上一RDD的输入记录的转换操作,并生成输出记录。计算逻辑根据所应用的转换操作来确定。

6. **优化与调度**

- **Stage划分**: Spark通过将宽依赖作为切割点,将任务划分为Stage,每个Stage内的任务可以并行执行,以优化性能。

- **Task调度**: Spark的DAGScheduler和TaskScheduler负责将任务分解为Task并分配到集群的Executor上执行。

理解Spark作业调度的工作原理有助于编写更高效的Spark程序,包括合理安排RDD的创建、转换和行动操作,以及充分利用Spark的并行计算能力和容错机制。通过深入学习和实践,开发者能够更好地控制和优化Spark作业,以满足大数据处理的需求。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-02-29 上传

点击了解资源详情

2024-06-28 上传

2017-03-10 上传

2021-05-16 上传

点击了解资源详情

tianbianlan

- 粉丝: 3

- 资源: 14

最新资源

- ATT7022B-programe,网络验证c语言源码,c语言

- Utils:一些实用程序

- chatomud

- configs:基于UNIX的点文件

- Feminazi a flor-crx插件

- 802.11b PHY Simulink 模型:802.11b 基带物理层的 Simulink:registered: 模型。-matlab开发

- SQLITE

- CpuTimer0,c语言read源码,c语言

- java-projects

- 오늘의 운세-crx插件

- technical-community-builders:雇用技术社区建设者的公司

- csrf_attack_example

- grpar:提取构建引擎组(.grp)文件的工具-开源

- Backjoon

- 每日日记:一种日记应用程序,融合了我在编码过程中所学到的技术

- AT89C2051UPS,c语言输出图形源码,c语言