理解SMO算法:基于KKT条件解决乳腺癌二分类问题

需积分: 0 106 浏览量

更新于2024-08-03

收藏 517KB PDF 举报

"本文介绍了SMO算法以及如何利用KKT条件对乳腺癌数据集进行二分类。SMO算法是解决支持向量机(SVM)优化问题的一种有效方法,它通过分解大问题为一系列小问题来简化计算。在SVM中,KKT条件是求解最优解的关键,它包括可行性条件、梯度条件和互补松弛条件。这些条件在优化过程中指导了支持向量的选择。SMO算法主要包括问题定义、选择变量、优化子问题、更新参数和重复迭代等步骤。在代码实现部分,通常会涉及数据加载、预处理和模型训练等过程。"

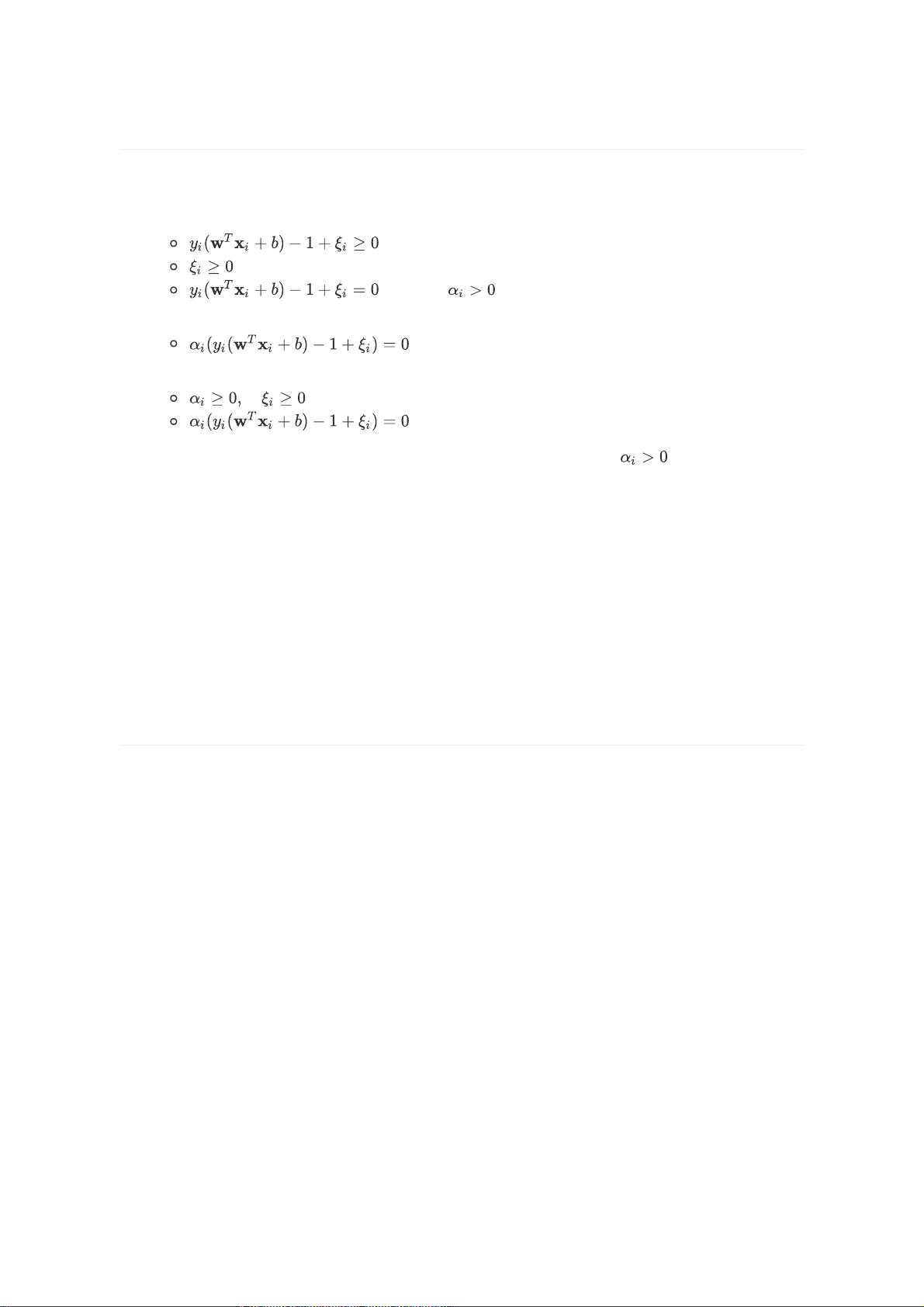

在机器学习领域,支持向量机(SVM)是一种强大的二分类和多分类模型,它利用最大间隔原则来构建决策边界。在SVM的优化过程中,KKT条件(Karush-Kuhn-Tucker conditions)起着至关重要的作用。KKT条件是解决带有约束的优化问题的一组必要条件,确保了找到全局最优解。

1. 可行性条件:所有样本点都要满足SVM的约束,即它们必须位于正确分类的区域,对于线性可分情况,这意味着样本点位于正确边界的正确一侧。

2. 梯度条件:SVM的目标函数(通常是软间隔损失函数加上惩罚项)对拉格朗日乘子的梯度为零,这表示目标函数在最优解处对乘子的微小变化不敏感。

3. 互补松弛条件:支持向量的拉格朗日乘子非零,而其他非支持向量的乘子为零。这表明,只有支持向量影响决策边界的位置。

SMO算法由John Platt提出,是解决SVM二次规划问题的高效算法。其核心思想是每次选择两个变量进行优化,通过迭代逐步逼近最优解。在选择变量时,SMO通常会选择违反KKT条件最严重的乘子,即那些最接近间隔边界的样本点。然后,固定其他变量,将大规模优化问题转化为两个变量的小规模问题,这可以使用解析方法(如高斯-塞德尔迭代)或数值方法求解。

在实际应用中,SMO算法还包括数据预处理、参数调整和模型评估等步骤。例如,数据可能需要进行标准化,以确保特征在同一尺度上。此外,SVM的核函数选择、C参数(正则化参数)和γ参数(影响决策边界的范围)都需要根据问题特性和数据集进行调整。

在代码实现部分,通常会用到Python的pandas库来加载和处理数据,scikit-learn库提供SVM模型和SMO算法的实现。数据集加载后,会进行预处理(如缺失值填充、异常值处理和特征缩放),接着使用SMO算法训练模型,并通过交叉验证来评估模型性能。最后,可能会使用测试集来验证模型的泛化能力。

SMO算法通过KKT条件有效地解决了SVM的优化问题,使得模型能够找到最佳的支持向量并构建出有效的决策边界。在乳腺癌数据集上的应用,可以帮助我们预测患者是否患有癌症,为医学诊断提供有力的辅助工具。

2024-06-27 上传

2024-10-02 上传

2022-07-14 上传

2023-06-02 上传

2023-05-31 上传

2023-06-03 上传

2023-05-16 上传

2023-06-02 上传

2023-06-02 上传

2023-05-31 上传

青州从事521

- 粉丝: 24

- 资源: 7

最新资源

- Python Django 深度学习 小程序

- react-phone-store

- WWDC_SwiftUI_Videos

- Pokedex-PokeAPI

- 计算机软件-编程源码-2万字库的拼音首字母查询,纯pb代码.zip

- Shape-List-Application:这是我 Java 课程的最后一个项目

- pcurl:pcurl是解析curl命令的库,弥补go生态链的一块空白[从零实现]

- hugegraph-computer:大规模图形计算

- Aliexpress的夜间模式-crx插件

- Java框架

- mongoose-data-migrate:使用猫鼬的node.js数据迁移框架

- FireStorm-Bluetooth:CS294 的蓝牙应用程序。 用于发现 BLE 设备并从 firestorm 和其他 BLE 设备接收 RSSI 值

- odsceast2021:R中的现代机器学习代码

- PHPEMS在线模拟考试系统 v6.1

- 电子功用-无氮气保护的电子束固化的涂料油墨、制备及固化方法

- portfolio-final:投资组合的最终版本,包括表格