决策树与随机森林:构建分类树分析

需积分: 0 39 浏览量

更新于2024-08-05

收藏 3.77MB PDF 举报

"决策树和随机森林的介绍及Carseats数据集的分类树构建"

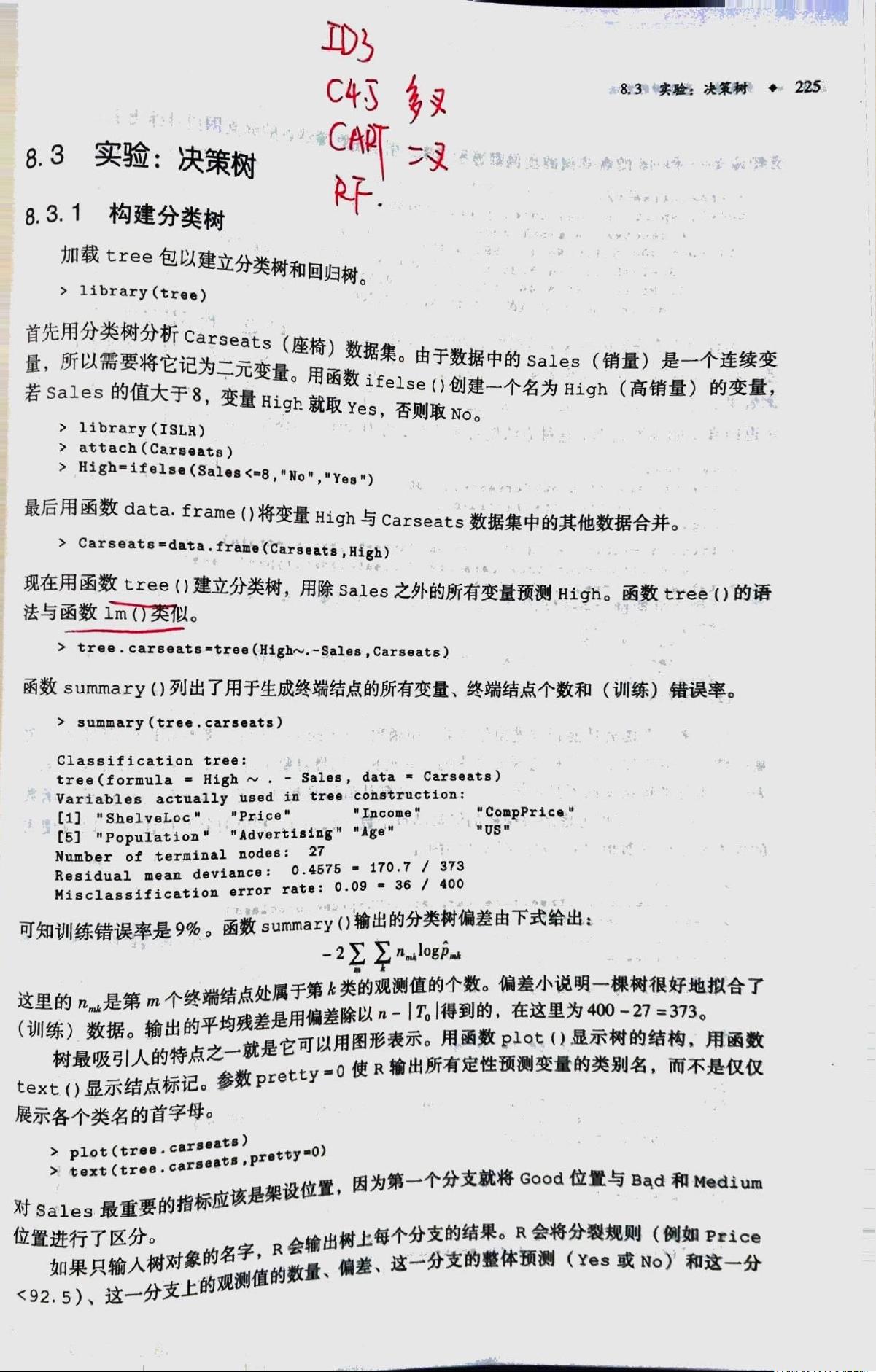

在机器学习领域,基于树的方法是常见的预测模型,包括决策树和随机森林。决策树是一种直观且易于理解的模型,它通过一系列规则(即树枝结构)进行分类或回归。在本章中,我们将探讨如何使用R语言中的`tree`包来构建决策树,并以Carseats数据集为例进行实战演练。

首先,我们加载必要的包`tree`和`ISLR`,`tree`包用于构建决策树,而`ISLR`包包含了Carseats数据集。Carseats数据集包含了关于儿童汽车座椅销售的信息,其中有一个连续变量`Sales`(销售量)和一个分类变量`High`,表示销售量是否高于8单位。为了将`Sales`转化为分类变量,我们创建了一个新的变量`High`,当`Sales`大于8时,`High`取值为"Yes",否则取值为"No"。

接下来,我们将处理后的数据集`Carseats`与`High`变量合并,并使用`tree`函数建立一个分类树,以`High`为目标变量,用`Carseats`中除`Sales`之外的所有其他变量作为预测因子。`tree`函数的输出提供了关于树结构的关键信息,包括用于构建树的变量、终端节点的数量以及训练集上的错误率。

在Carseats数据集的分类树中,`ShelveLoc`(货架位置)、`Price`(价格)、`Income`(收入)、`CompPrice`(竞争价格)和`Population`(人口)等变量被用于划分数据。训练错误率表示的是模型在训练数据上的表现,如果错误率低,说明模型对训练数据的拟合度较高。在这个例子中,训练错误率为9%,表明有9%的样本在树的预测下被错误分类。

决策树的图形表示可以帮助我们直观理解模型的决策过程。通过`plot`函数,我们可以可视化这棵决策树,其中每个内部节点代表一个特征测试,分支表示测试结果,而叶节点(终端节点)则对应于最终的类别预测。星号标记的终端节点表示它们是基于数据自然划分形成的,而非人为设定的阈值。

除了单棵决策树,随机森林是一种集成学习方法,它通过构建多棵决策树并取其平均预测结果来提高预测性能和鲁棒性。在随机森林中,每棵树都在随机子集的特征和样本上构建,这样可以减少过拟合风险并提高泛化能力。虽然本章没有直接涉及随机森林,但了解决策树的基础是进一步学习随机森林的前提。

总结来说,决策树是一种基于树形结构进行预测的算法,易于解释且能处理不同类型的数据。通过`tree`包在R中构建的决策树模型,我们可以直观地看到影响目标变量的重要因素,并评估模型在训练数据上的表现。随机森林则通过集成多棵决策树来增强模型的预测能力和稳定性。在实际应用中,决策树和随机森林常被用来解决分类和回归问题,特别是在数据特征复杂且需要解释性强的模型时。

2021-10-01 上传

2021-10-03 上传

2018-11-05 上传

2023-10-30 上传

2024-09-22 上传

2023-11-18 上传

2023-08-27 上传

2023-02-06 上传

2023-06-08 上传

柏傅美

- 粉丝: 32

- 资源: 325