集成学习Ensemble:提升准确性和多样性的策略

需积分: 0 62 浏览量

更新于2024-08-05

收藏 1.3MB PDF 举报

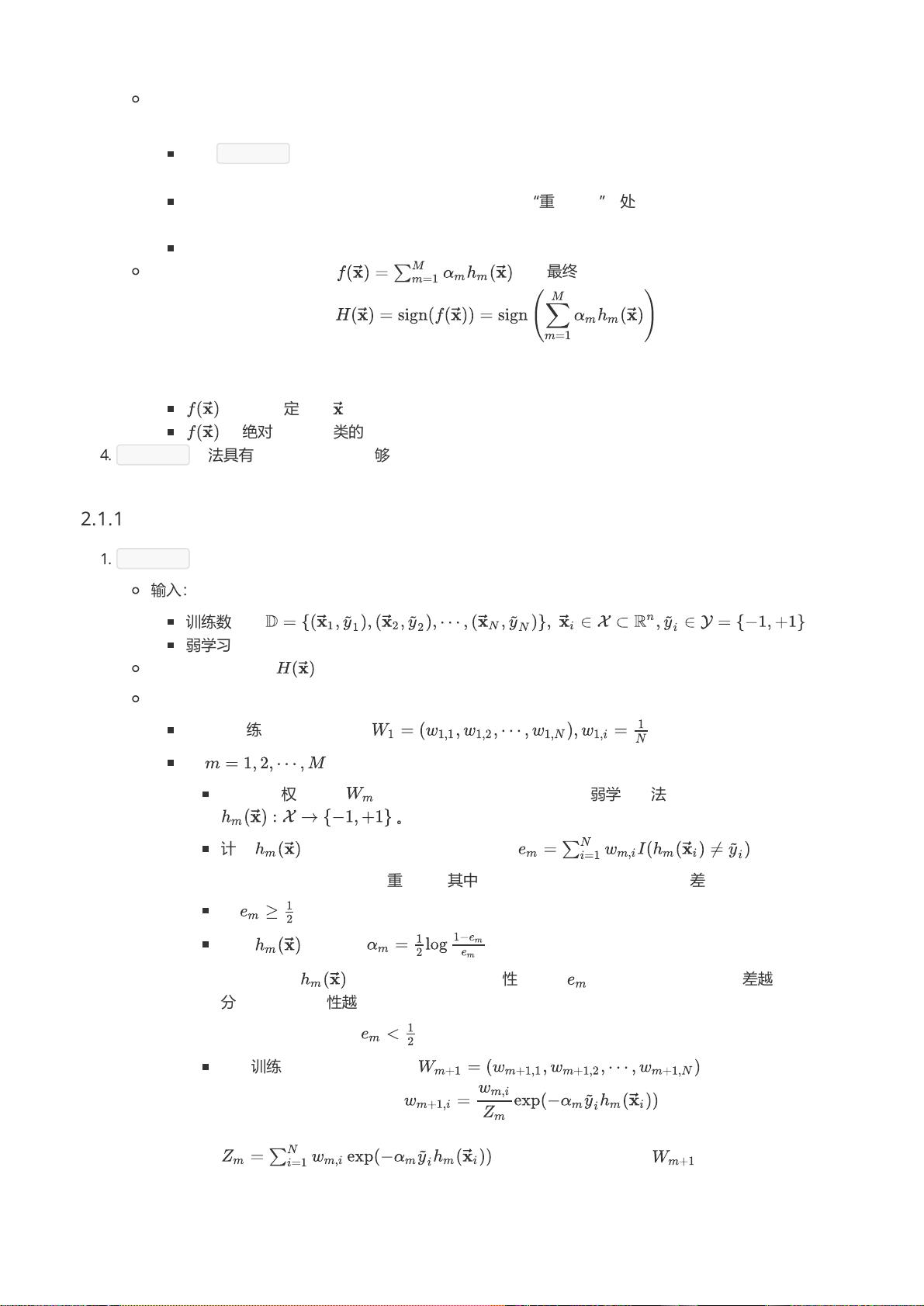

"集成学习是通过构建多个学习器并结合它们来提升整体学习性能的方法。它分为同质的(所有个体学习器来自同一学习算法)和异质的(个体学习器来自不同学习算法)。选择个体学习器时,既要考虑其准确度,也要确保多样性。集成学习通常使用强学习器,因为它们能以较少的数量实现更好的效果。集成学习主要分为两种类型:依赖性强、串行生成的Boosting,以及无强依赖、并行生成的Bagging和Random Forest。集成学习的误差分析显示,随着基学习器数量增加,整体错误率会下降。"

集成学习是机器学习领域的一个重要概念,旨在通过组合多个学习器(或称为分类器)来提高最终预测的准确性和鲁棒性。这种策略通常比单独使用一个学习器更能抵抗过拟合,并且在处理复杂数据集时特别有效。

在集成学习中,个体学习器可以是同质的,这意味着它们都是通过相同的学习算法(如决策树或支持向量机)训练得到;也可以是异质的,意味着它们可能来自不同的学习算法,增加了学习器之间的多样性和互补性。多样性是集成学习的关键因素,因为它有助于减少整个系统的错误率。如果所有学习器都做出相同的错误,那么集成可能无法提供改进。

个体学习器的选择标准是准确性和多样性。首先,学习器必须具有一定的预测能力,不能过于糟糕。其次,它们之间需要有一定的差异,以确保在面对不同情况时能有不同的响应。例如,如果所有学习器对某一类样本都犯同样的错误,那么集成可能不会改善这个错误。

集成学习分为两大类:序列化方法,如Boosting,以及并行化方法,如Bagging和随机森林。Boosting方法通过连续迭代生成个体学习器,每个新学习器专注于纠正前一轮的错误,从而逐步优化整个集成。而Bagging和随机森林则允许并行生成个体学习器,每个学习器在随机子集(Bootstrap抽样)或特征子集上训练,增加多样性。

误差分析表明,当集成中的基学习器数量增加时,由于错误率的独立性,集成学习的整体错误率趋于下降。这可以通过Hoeffding不等式来理解,该不等式描述了独立事件的期望错误率随样本数量的增加而减小的情况。因此,集成学习能够利用多个学习器的集体智慧,降低整体的泛化误差。

在实际应用中,集成学习已经被广泛用于各种任务,包括分类、回归和排序等,而且在许多机器学习竞赛和实际项目中,集成方法常常表现出色。通过精心设计和调整学习器的组合方式,可以构建出强大的预测模型,从而在复杂数据挑战中取得优异的性能。

2020-10-18 上传

2023-06-07 上传

2023-05-22 上传

2023-06-02 上传

2023-07-11 上传

2024-07-31 上传

2024-06-05 上传

2023-04-03 上传

2023-06-13 上传

熊比哒

- 粉丝: 33

- 资源: 292

最新资源

- Hadoop生态系统与MapReduce详解

- MDS系列三相整流桥模块技术规格与特性

- MFC编程:指针与句柄获取全面解析

- LM06:多模4G高速数据模块,支持GSM至TD-LTE

- 使用Gradle与Nexus构建私有仓库

- JAVA编程规范指南:命名规则与文件样式

- EMC VNX5500 存储系统日常维护指南

- 大数据驱动的互联网用户体验深度管理策略

- 改进型Booth算法:32位浮点阵列乘法器的高速设计与算法比较

- H3CNE网络认证重点知识整理

- Linux环境下MongoDB的详细安装教程

- 压缩文法的等价变换与多余规则删除

- BRMS入门指南:JBOSS安装与基础操作详解

- Win7环境下Android开发环境配置全攻略

- SHT10 C语言程序与LCD1602显示实例及精度校准

- 反垃圾邮件技术:现状与前景