信息论实验:计算信源熵与交互熵

需积分: 20 153 浏览量

更新于2024-07-25

收藏 682KB DOC 举报

"信息论实验,涉及编码和流程图,计算信息量、信源熵、条件熵、联合熵和交互熵"

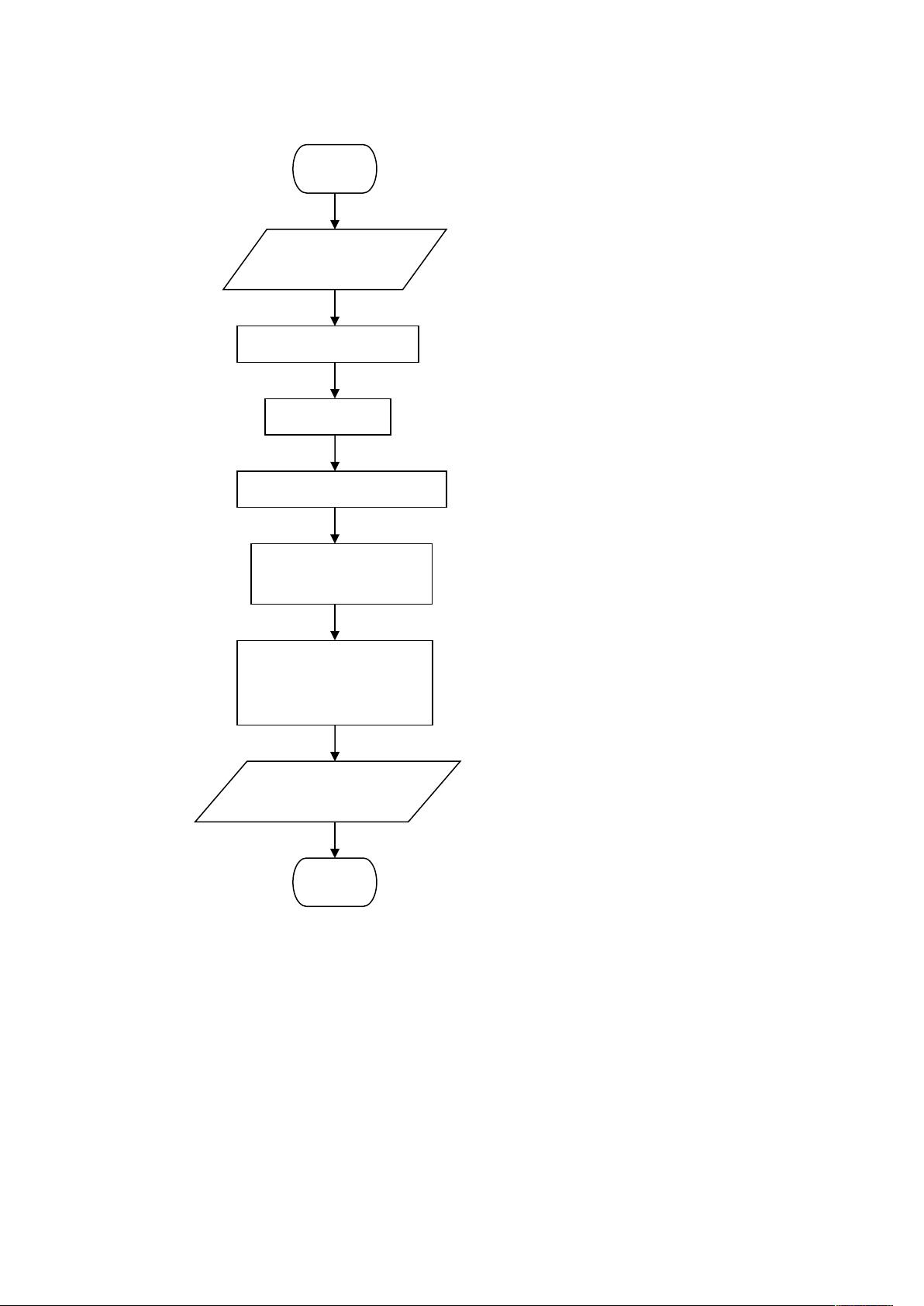

在信息论中,我们关注的是数据和信息的量化以及它们如何通过通信系统传输。本实验是关于信息论的基础概念实践,主要涉及到信息量、信源熵、条件熵、联合熵以及交互熵的计算。这些概念是理解信息传输效率和通信系统性能的关键。

首先,信息量是单个事件发生时所携带的信息量,通常用比特(bits)来衡量。在给出的代码中,求信息量的过程没有直接展示,但可以理解为基于事件发生的概率来计算。一个事件发生的概率越小,其信息量越大。

接下来,信源熵(Entropy)是描述信源随机性的一个度量,表示平均每个符号的信息量。对于离散信源,信源熵H(X)的计算公式是:H(X) = -∑(p_i * log2(p_i)),其中p_i是信源符号i出现的概率。在提供的代码中,`hX`是通过这个公式计算得出的。

条件熵(Conditional Entropy)H(Y|X)表示在已知X的情况下,Y的不确定性。它是联合熵H(XY)减去信源熵H(X),即H(Y|X) = H(XY) - H(X)。代码中计算了H(Y|X)和H(X|Y)。

联合熵(Joint Entropy)H(XY)是两个变量X和Y一起出现时的不确定性,计算公式为:H(XY) = -∑∑(p_ij * log2(p_ij)),其中p_ij是事件X=i且Y=j的概率。

交互熵(Mutual Information)I(X;Y)或I(Y;X)是描述两个变量之间相互依赖程度的度量,表示知道一个变量可以减少另一个变量的不确定性。交互熵等于条件熵的差,即I(X;Y) = H(X) - H(X|Y)。在实验代码中,`iXY`是交互熵的计算结果。

最后,香农编码(Shannon Coding)是信息论中的一个重要概念,用于无损数据压缩。虽然这部分内容未提供详细代码,但通常香农编码的目标是为信源符号分配长度与它们的逆概率成比例的二进制码字,以达到最小化平均码长并保持无损传输。

通过这些实验,学习者可以深入理解信息论的基本原理,并能应用到实际的编码和通信系统设计中。实验中涉及的计算过程和流程图有助于将理论知识转化为实践操作,从而增强对信息论概念的理解。

236 浏览量

点击了解资源详情

157 浏览量

342 浏览量

2016-06-09 上传

492 浏览量

139 浏览量

216 浏览量

236 浏览量

u010973183

- 粉丝: 0

- 资源: 2

最新资源

- 网络蜘蛛基本原理和算法

- 搜索引擎基本原理和算法介绍

- 计算机网络第四版(谢希仁)习题详细答案.doc

- Efficient C++ Performance Programming TechniquesAddison.Wesley.Efficient.C...Performance.Programming.Techniques.pdf

- CISCO路由器配置手册.doc

- IAR-AVR C编译器指南.pdf

- 软件工程学习书《人月神话》

- 40种网页常用小技巧

- rose ha 配置文档

- Software Architecture4+1

- 索引的SQL语句优化

- C++实现人工神经网络的类

- Qt嵌入式图形开发(入门篇)

- J2EE中文教材.doc

- 实战XML第二版.pdf

- Qt嵌入式图形开发(基础篇).pdf