深度学习实战:TensorFlow驱动的DCNN与ImageNet模型解析

73 浏览量

更新于2024-08-29

收藏 594KB PDF 举报

"深度学习利器:TensorFlow与深度卷积神经网络"

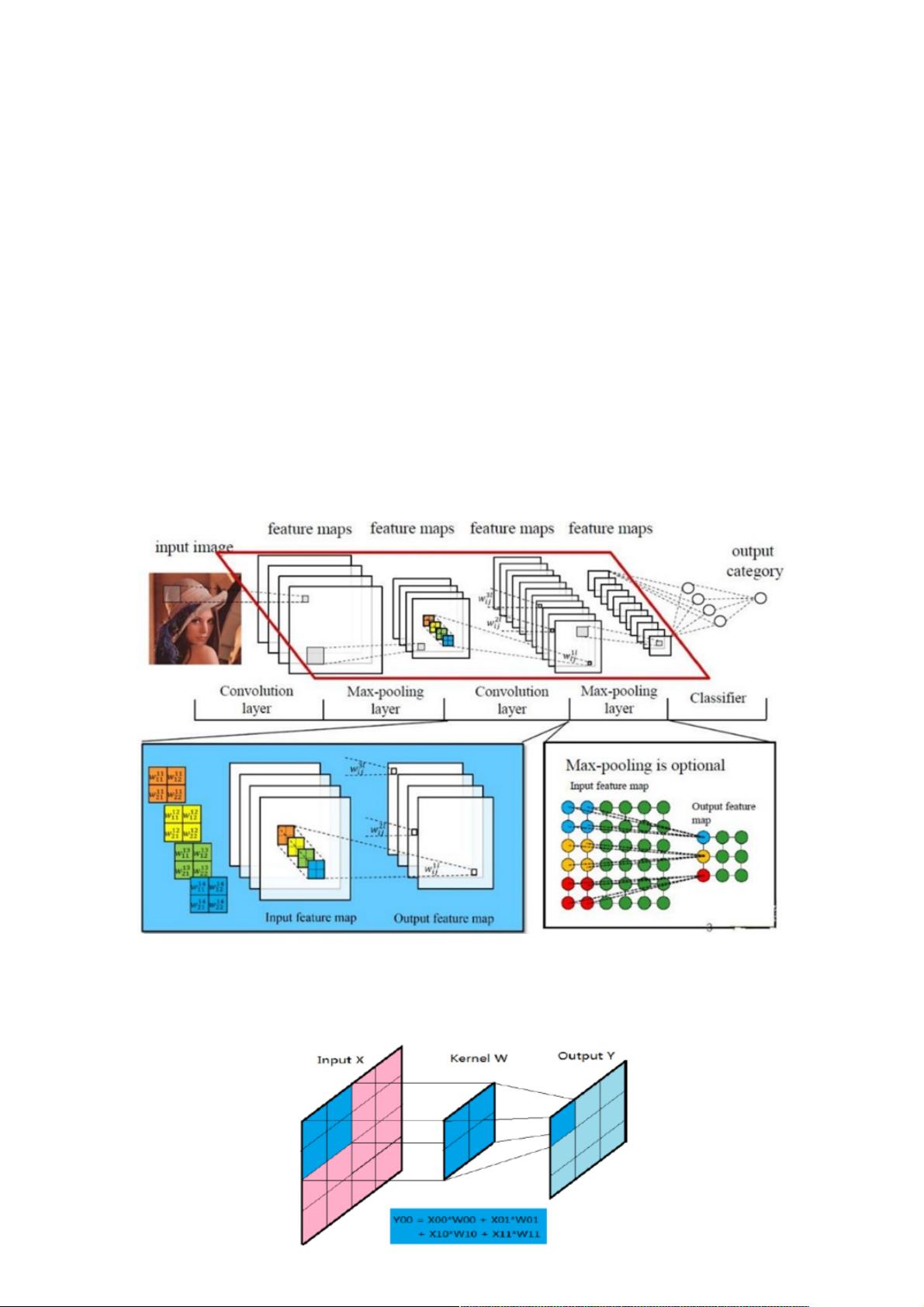

深度学习是现代人工智能领域的一个重要分支,尤其在图像识别技术中发挥了关键作用。深度卷积神经网络(Deep Convolutional Neural Networks, DCNNs)是实现这一目标的核心工具。DCNNs的设计灵感来源于人脑视觉皮层的结构,通过多层的卷积和池化操作,能够自动学习到图像中的特征,从而实现高效准确的图像分类和识别。

TensorFlow是一个由Google开发的开源深度学习框架,它为构建和训练复杂的神经网络提供了便利。TensorFlow支持分布式计算,使得大规模模型的训练成为可能。在图像识别任务中,TensorFlow 提供了多种预训练的卷积神经网络模型,如Cifar10、InceptionV3和Vgg19,这些模型已经在大型数据集如ImageNet上进行了预训练,具有很高的识别准确率。

Cifar10是一个常用的小型数据集,包含10个类别的彩色图像,常用于验证和比较不同的CNN架构。InceptionV3则是一个更为先进的模型,它通过多尺度信息处理和减少计算复杂度实现了更高效的特征提取,其在ImageNet上的表现显著优于早期的AlexNet。Vgg19则是由牛津大学Visual Geometry Group提出的,以深而窄的卷积层著称,尽管计算量大,但能捕获非常丰富的图像特征。

对于业务场景下的图像识别,例如花、人物、车辆或医学图像的识别,可以利用这些预训练模型进行迁移学习。首先,用户可以将业务图片数据输入到预训练模型中,通过微调(fine-tuning)来适应特定领域的任务。微调是指在预训练模型的基础上,针对新的数据集进行少量的额外训练,以优化模型对新任务的性能。此外,还可以通过调整超参数、增加层数或者使用正则化等技术进行模型优化,以提高识别的准确性和效率。

卷积神经网络的运作原理包括以下几个关键组成部分:

1. **卷积层**:这是CNN的基础,通过对输入图像应用卷积核来提取特征。每个卷积核会在输入图像上滑动,产生一个新的特征图。

2. **池化层**:池化层用于减小数据的空间维度,通常采用最大池化或平均池化,以减少计算量并防止过拟合。

3. **全连接层**(或称为分类层):在特征抽取阶段之后,将所有特征图展平为一维向量,并连接到全连接层,用于最终的分类决策。

4. **损失函数**:在训练过程中,损失函数衡量模型预测与实际标签之间的差异,常见的有交叉熵损失。

5. **优化器**:如梯度下降和反向传播算法,用于更新网络权重以最小化损失函数。

6. **批量归一化**(Batch Normalization, BN):一种加速训练和改善模型稳定性的技术,通过标准化每一层的输入,使得训练过程更加平滑。

7. **激活函数**:如ReLU(Rectified Linear Unit),用于引入非线性,使得网络能够学习复杂的模式。

通过理解和应用这些基本概念,开发者可以使用TensorFlow构建和优化自己的深度学习模型,以解决各种实际的图像识别问题。随着硬件的进步和算法的优化,深度学习和卷积神经网络在图像识别领域的应用将更加广泛,为人工智能的应用带来更多的可能性。

397 浏览量

点击了解资源详情

点击了解资源详情

251 浏览量

688 浏览量

点击了解资源详情

146 浏览量

141 浏览量

点击了解资源详情

weixin_38713586

- 粉丝: 3

最新资源

- iBatis 2.0 开发指南:快速上手与高级特性

- Linux USB内核学习笔记

- J2EE电商系统入门精通:Struts+Hibernate实战教程

- JUnit测试框架:简化Java开发的利器

- 使用Struts2构建Web 2.0项目的实战指南

- 软件开发笔试试题解析与解答

- SWT图形用户界面教程:Java GUI开发

- 华为面试题解析:JAVA面试焦点

- Cisco路由器密码恢复步骤详解

- 面向对象分析与设计实战指南

- Quest Software's TOAD for Oracle 演示与介绍

- 《Struts in Action》中文版详解:Java Web框架深度解析

- 软件工程模式与项目管理探讨

- UML设计与软件工程实践:案例分析与工具详解

- 面向对象技术与UML方法:软件工程访谈与实践

- Core J2EE模式:最佳实践与设计策略