Flink+Iceberg+对象存储:构建阿里数据湖实践

需积分: 24 184 浏览量

更新于2024-08-04

收藏 1.59MB PDF 举报

本文主要探讨了如何利用Apache Flink(流处理框架)与Apache Iceberg(开源数据湖管理系统)结合对象存储构建高效且灵活的数据湖解决方案。阿里巴巴云栖号在2021年7月16日发布的这篇文章,由Dell科技集团高级软件研发经理孙伟在FlinkMeetup活动中分享。

首先,文章对数据湖生态进行了概述。一个成熟的数据湖应具备以下关键特性:1)海量的存储能力,如对象存储、公有云存储和Hadoop分布式文件系统(HDFS);2)支持多种数据类型,包括非结构化的图像和视频,半结构化的CSV、XML和日志,以及结构化的数据库表;3)高效的元数据管理,确保计算引擎能够轻松访问和分析各类数据;4)兼容多样的计算引擎,如Flink、Spark、Hive和Presto,以适应企业现有的应用架构。

接着,作者重点讨论了在数据湖中使用结构化数据的应用场景。例如,来自不同数据源(如事务数据、日志、事件跟踪和物联网数据)的多样化数据通过流处理后,需要一个结构化的存储方案,既能实时处理,又能支持灵活的数据修改,如增加列或更改格式,而无需完全重构整个数据集。

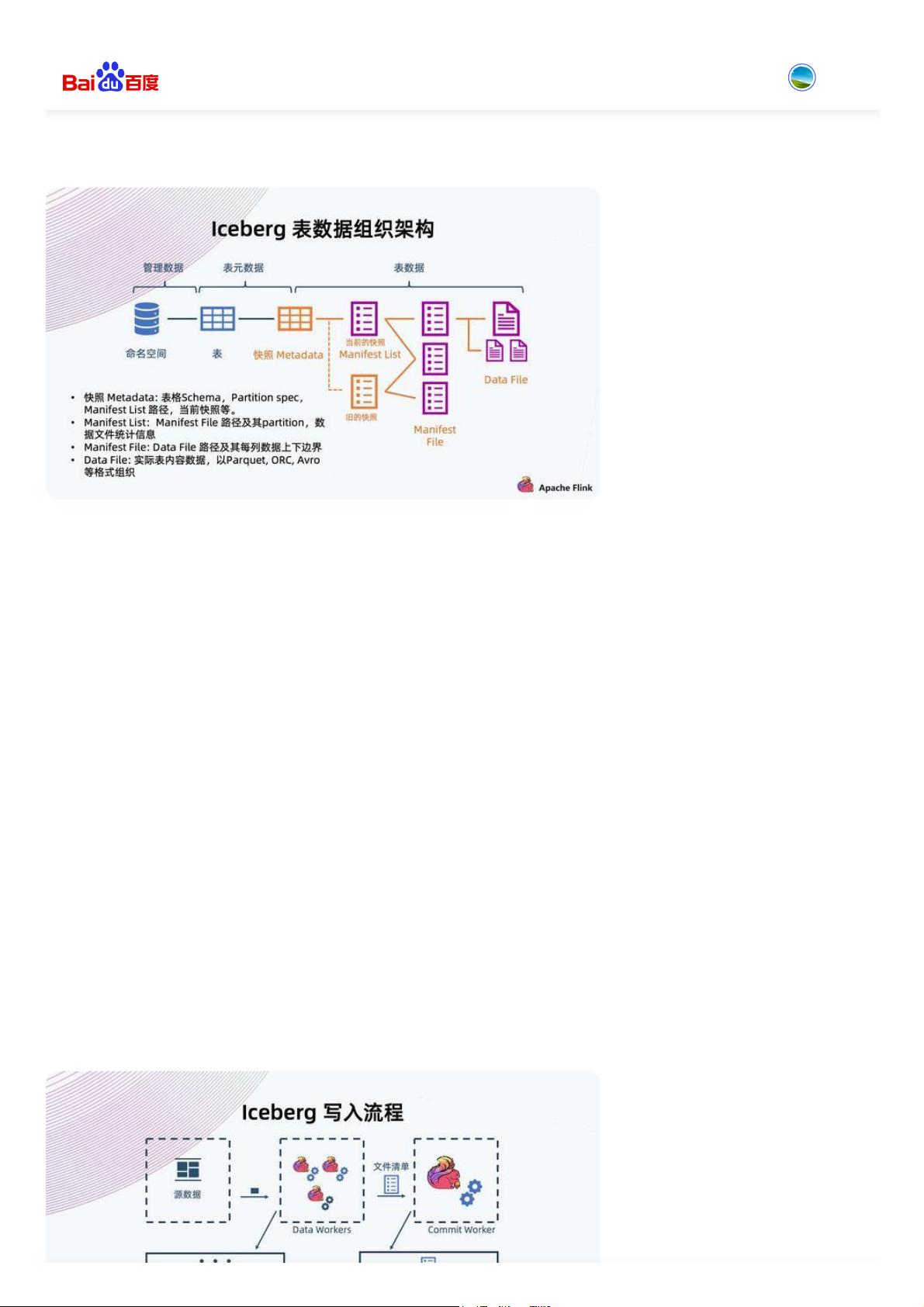

为了实现这些目标,文章介绍了Flink与Iceberg的结合。Flink的强大实时处理能力与Iceberg的动态列式存储和可验证数据变更历史相结合,提供了高性能的数据写入和查询。同时,借助对象存储(如阿里云的OSS),数据湖可以实现低成本、高扩展性的存储,并且能轻松地跨区域复制和备份数据。

存储优化方面,文章提出了几点思考:如何在保证数据一致性(ACID)的同时,处理实时数据流,避免读取脏数据;如何通过Iceberg的特性减少数据转换的成本,实现灵活的数据更新;以及如何在大规模数据处理中实现高效的性能和成本效益。

总结来说,这篇文章提供了一个实用的框架,展示了如何通过Flink、Iceberg和对象存储技术构建高效的数据湖解决方案,以满足现代企业对数据处理和存储的需求,实现数据价值的快速提取和分析。

143 浏览量

344 浏览量

143 浏览量

2024-02-29 上传

270 浏览量

270 浏览量

133 浏览量

103 浏览量

136 浏览量

心有猛虎-细嗅玫瑰

- 粉丝: 0

- 资源: 10