文本分类中的特征选择策略与常用评估方法

需积分: 19 12 浏览量

更新于2024-09-13

收藏 247KB DOC 举报

文本分类是一项关键任务,其目标是自动将文本数据归类到预定义的类别中。在处理大规模文本数据时,特征选择是至关重要的一步,它旨在从原始文本中筛选出最具代表性和区分度的特征,以提高分类器的性能和效率。本文主要探讨了两种主要的特征选择方法:基于独立评估和基于综合评估。

基于独立评估的特征选择方法:

这种方法首先通过构建一个评估函数,例如卡方检验(CHI)或x2统计量,对文本中的每个词或特征进行单独打分。这些评估函数衡量一个特征与类别之间的关联强度,得分较高的特征被认为更能区分不同的类别。评估后,特征按照得分高低排序,然后根据预设的阈值或选择数量确定最佳特征子集。

文档频率(DF):

这是一种基于统计的简单方法,计算一个特征在特定类别中的出现频率。文档频率高的特征可能更常见,但不一定有很好的区分性。因此,设置最小和最大文档频率阈值有助于剔除非关键的词语,保留具有较高区分度的词。

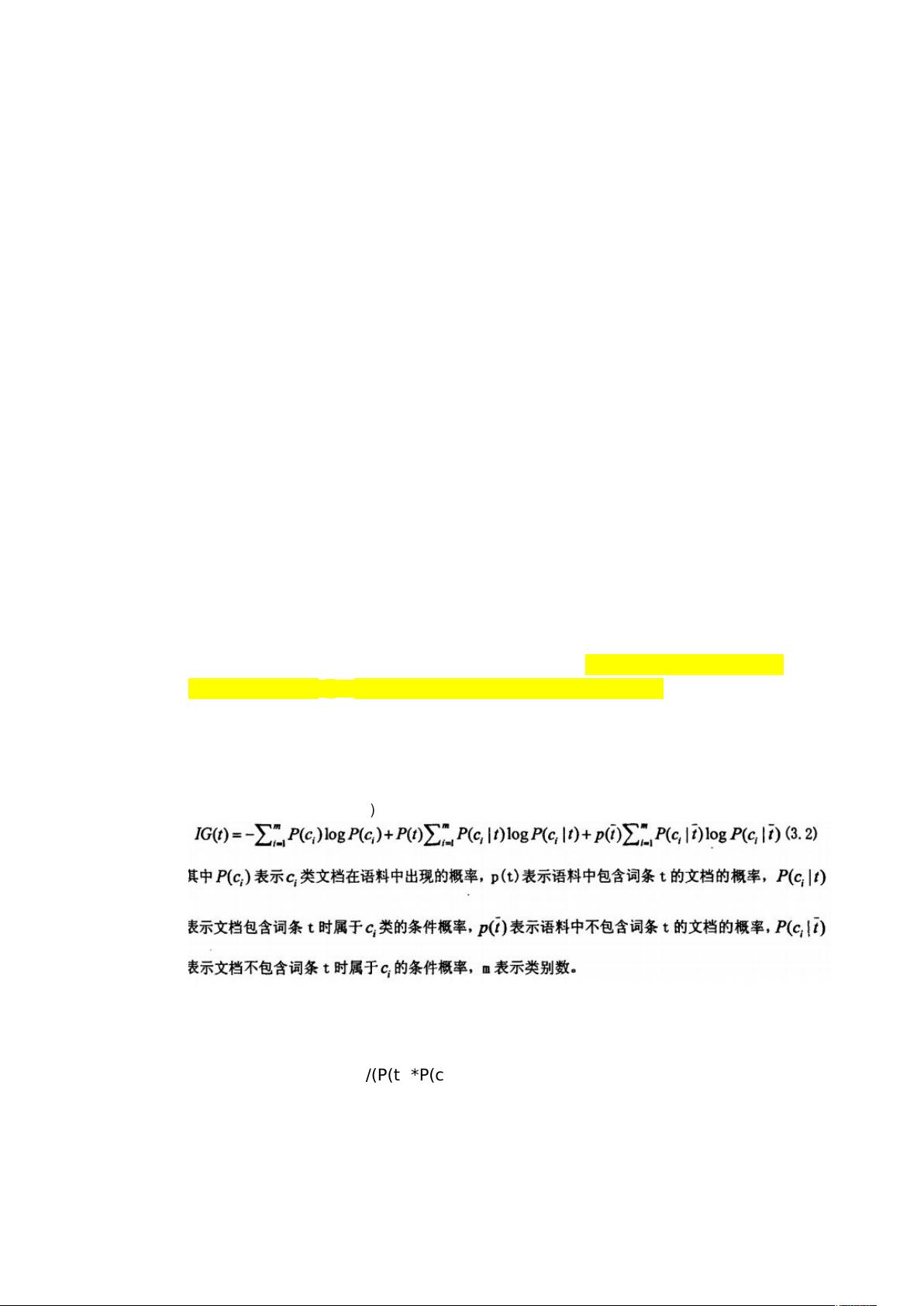

信息增益(IG):

信息增益是另一种基于熵的评估方法,它衡量某个特征引入后系统信息熵的减少。这个概念源自物理学的熵增原理,但在信息检索和机器学习中,信息增益用于度量特征对分类决策的贡献。高信息增益的特征对预测结果的影响更大,因此会被优先选择。

互信息(MI):

互信息衡量两个变量(特征和类别)之间共享的信息量,它是基于概率的度量。计算公式涉及特征ti在类别cj中出现的概率和特征ti在整个数据集中独立出现的概率。互信息越高,表明特征ti和类别cj之间的关联越强,因此在特征选择中,高互信息的特征被保留。

这两种综合评估方法不仅考虑了单个特征的重要性,还考虑了特征之间的相互作用,从而提供了一个更为全面的特征子集,以提升文本分类的准确性和效率。在实际应用中,这些方法经常结合使用,或者与其他技术(如基于模型的特征选择)相结合,以获得最佳的特征子集,进一步优化文本分类器的性能。

2019-09-13 上传

点击了解资源详情

点击了解资源详情

2011-05-25 上传

2009-12-06 上传

2011-05-25 上传

2021-05-23 上传

2021-03-19 上传

2019-07-22 上传

赫本1953

- 粉丝: 2

- 资源: 3

最新资源

- Fisher Iris Setosa数据的主成分分析及可视化- Matlab实现

- 深入理解JavaScript类与面向对象编程

- Argspect-0.0.1版本Python包发布与使用说明

- OpenNetAdmin v09.07.15 PHP项目源码下载

- 掌握Node.js: 构建高性能Web服务器与应用程序

- Matlab矢量绘图工具:polarG函数使用详解

- 实现Vue.js中PDF文件的签名显示功能

- 开源项目PSPSolver:资源约束调度问题求解器库

- 探索vwru系统:大众的虚拟现实招聘平台

- 深入理解cJSON:案例与源文件解析

- 多边形扩展算法在MATLAB中的应用与实现

- 用React类组件创建迷你待办事项列表指南

- Python库setuptools-58.5.3助力高效开发

- fmfiles工具:在MATLAB中查找丢失文件并列出错误

- 老枪二级域名系统PHP源码简易版发布

- 探索DOSGUI开源库:C/C++图形界面开发新篇章