Spark编译与Hadoop部署:从环境搭建到实战指南

需积分: 50 96 浏览量

更新于2024-07-19

收藏 1.86MB PDF 举报

本篇文章详细介绍了Spark编译与Hadoop部署的中间步骤,主要包括以下几个关键部分:

1. **Hadoop编译**:

- 第一部分首先从安装和配置开发环境开始,包括:

- 安装并设置Maven:Maven是一个构建工具,用于管理和依赖管理Java项目,对于Hadoop的构建至关重要。

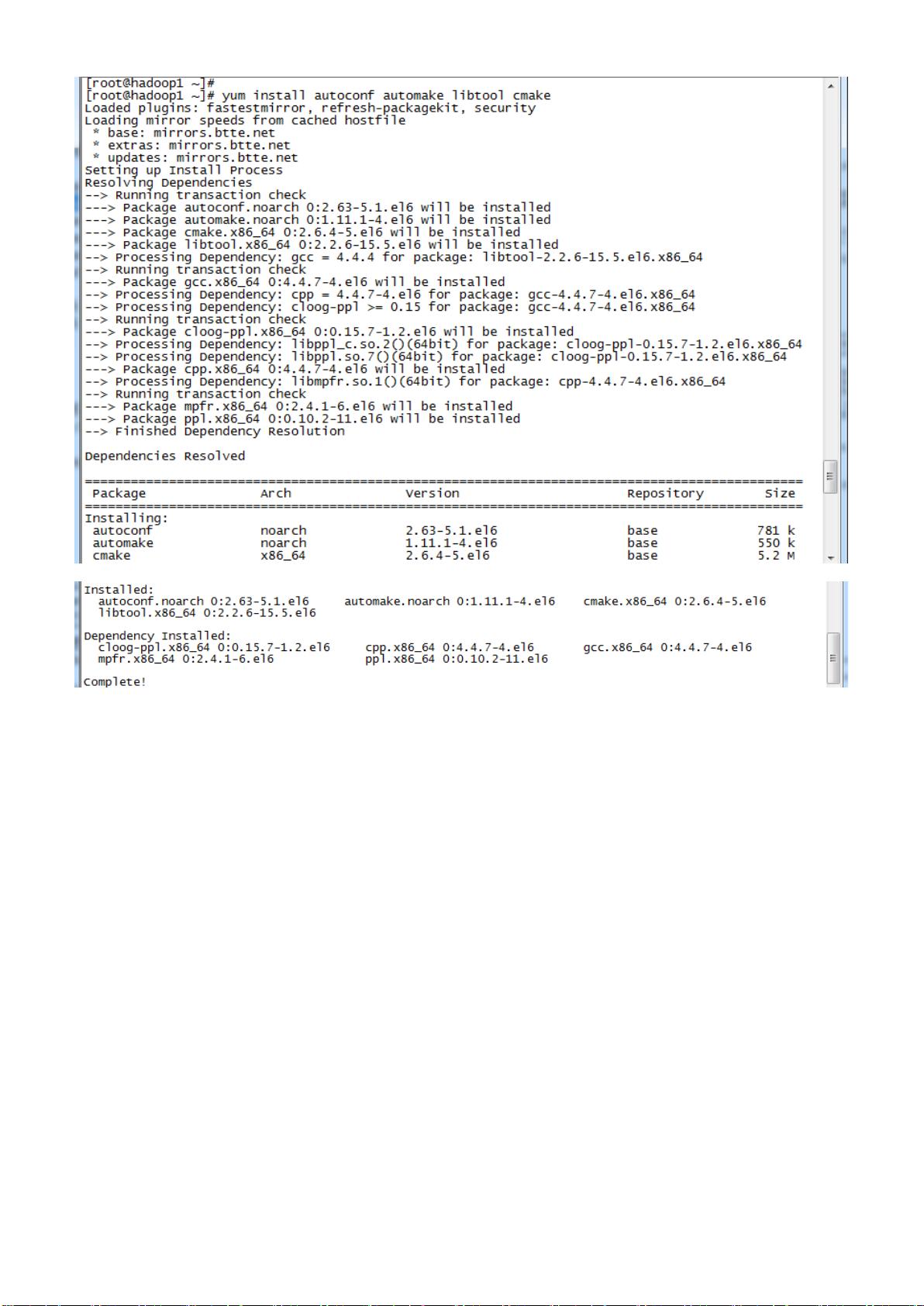

- 使用yum命令安装必要的系统库,如:svn(版本控制系统)、autoconf、automake、libtool、cmake(编译工具)、ncurses-devel(控制台输入输出处理)、openssl-devel(安全协议支持)以及GCC(C语言编译器)。

- 安装protobuf:protobuf是一种数据序列化方案,常用于Hadoop的数据通信。

2. **Hadoop源代码编译**:

- 用户下载Hadoop 2.2.0的源代码进行编译,这是一个重要的步骤,因为编译源代码能够确保对特定版本的Hadoop有深入的理解,并且可以针对特定需求进行定制。

- 编译过程分为下载、编译源码和验证编译结果,确保没有错误或冲突。

3. **Hadoop安装**:

- 配置阶段涉及上传Hadoop安装包、创建必要的目录、配置多个环境变量文件(如hadoop-env.sh、yarn-env.sh等),以及核心、HDFS、MapReduce和YARN的配置文件(core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml 和 Slaves 文件)。

- 向各节点分发Hadoop程序,这是集群部署的重要步骤。

- 启动部署包括格式化NameNode、启动HDFS、检查其运行状态、启动YARN以及验证YARN的运行效果。

4. **问题解决**:

- 文章还提到了在 CentOS 64位系统上安装Hadoop 2.2.0时可能会遇到的一些问题,例如文件编译位数异常、代码编译异常和找不到/etc/hadoop目录的异常,这些问题可能是由于环境设置、依赖不匹配或者权限问题导致的,文章会提供可能的解决方案或排查思路。

这篇文章对于想要深入了解Hadoop和Spark编译部署流程,尤其是遇到问题需要调试的开发者来说,是一份非常实用的指南。通过阅读和实践,读者可以掌握从基础环境配置到实际部署的完整过程。

2018-04-04 上传

2018-07-27 上传

2016-10-25 上传

2023-07-02 上传

2023-07-27 上传

2023-05-26 上传

2023-05-26 上传

2023-04-30 上传

l691635239

- 粉丝: 0

- 资源: 5

最新资源

- zlib-1.2.12压缩包解析与技术要点

- 微信小程序滑动选项卡源码模版发布

- Unity虚拟人物唇同步插件Oculus Lipsync介绍

- Nginx 1.18.0版本WinSW自动安装与管理指南

- Java Swing和JDBC实现的ATM系统源码解析

- 掌握Spark Streaming与Maven集成的分布式大数据处理

- 深入学习推荐系统:教程、案例与项目实践

- Web开发者必备的取色工具软件介绍

- C语言实现李春葆数据结构实验程序

- 超市管理系统开发:asp+SQL Server 2005实战

- Redis伪集群搭建教程与实践

- 掌握网络活动细节:Wireshark v3.6.3网络嗅探工具详解

- 全面掌握美赛:建模、分析与编程实现教程

- Java图书馆系统完整项目源码及SQL文件解析

- PCtoLCD2002软件:高效图片和字符取模转换

- Java开发的体育赛事在线购票系统源码分析