RLHF揭秘:ChatGPT背后的强化学习算法及12篇关键论文

抱抱脸:ChatGPT背后的算法——RLHF(Reinforcement Learning from Human Feedback,人类反馈强化学习)是近期引起广泛关注的技术,用于训练像ChatGPT这样的生成式人工智能模型。传统的语言模型如循环解码器通过逐词预测和交叉熵损失进行训练,但这无法充分考虑整体输出的质量,因为模型仅依据局部上下文信息优化。

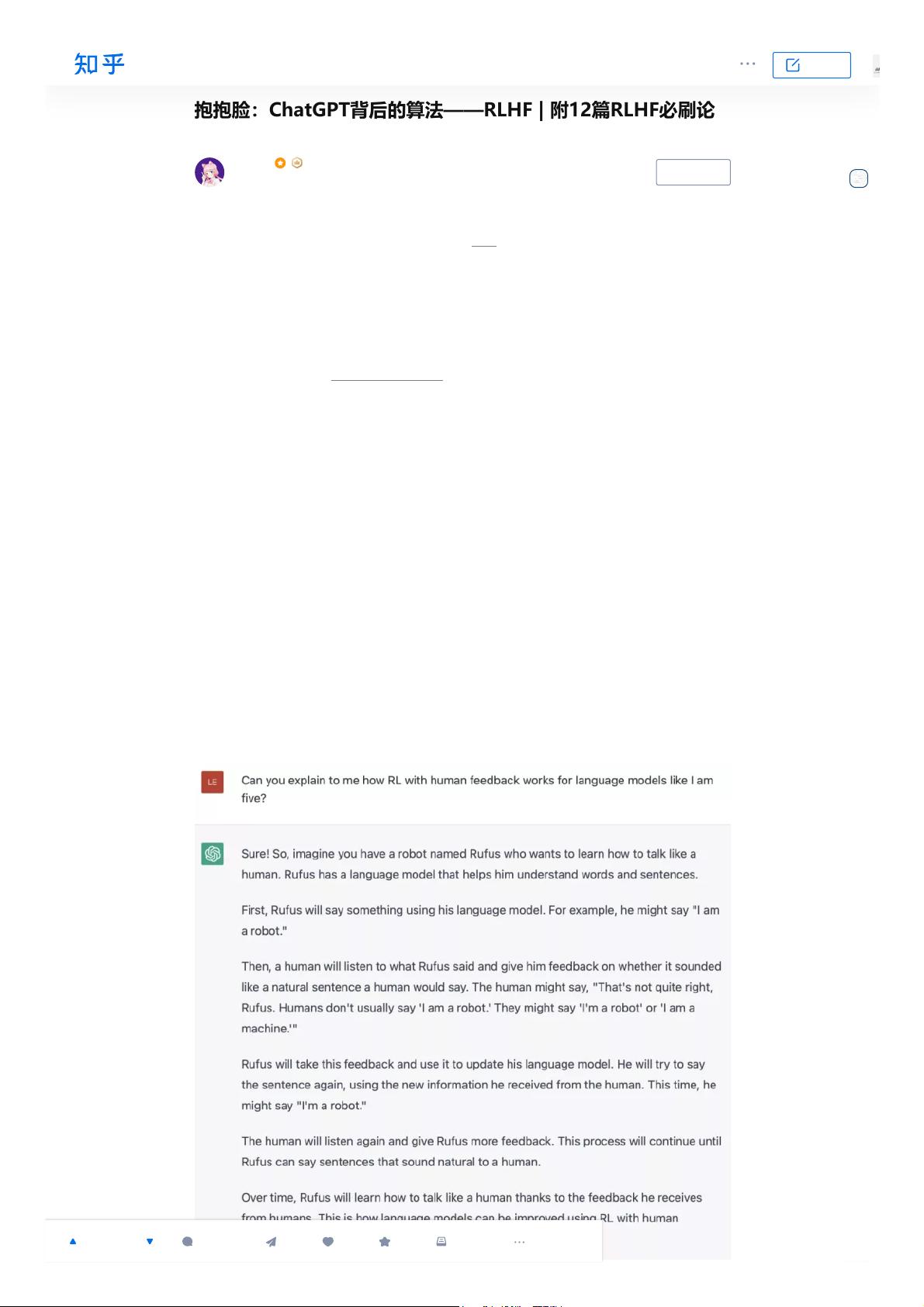

RLHF的核心思想是利用人类的直接反馈作为强化学习中的奖励信号,来调整模型的行为。这种方法允许模型在生成文本时更加接近人类的预期,从而提高生成内容的自然度、连贯性和准确性。ChatGPT的训练过程中,开发者通过设计一系列任务和评估机制,让用户对模型的回答给出满意或不满意的意见,然后将这些反馈转化为强化学习环境中的奖励,驱动模型学习更符合人类价值观的语言模式。

在实际操作中,RLHF涉及以下关键步骤:

1. **定义任务和评估标准**:创建一系列情境,让模型生成响应,用户给出评估。

2. **收集反馈**:通过问卷、对话或交互方式获取用户的满意度评分。

3. **奖励函数设计**:根据用户反馈,制定奖励规则,比如给正面反馈高的回复高分,负面反馈低分。

4. **强化学习过程**:在训练过程中,模型根据奖励调整参数,优化生成策略。

5. **迭代和调整**:反复进行上述步骤,直到达到满意的性能。

为了深入理解RLHF,以下是推荐的12篇必读论文:

- [1] "Incorporating Human Preferences in Machine Translation with Reinforcement Learning" (2016) - 提供了早期的RLHF在机器翻译中的应用案例。

- [2] "Deep Reinforcement Learning for Dialogue Generation" (2017) - 探索如何用深度强化学习改进对话生成模型。

- [3] "Hierarchical Reinforcement Learning for Text Generation" (2018) - 研究了层次化的RL在文本生成中的作用。

- [4] "Learning to Talk by Imitating Humans" (2019) - 针对对话系统,探讨模仿人类对话的RL方法。

- [5] "Language Models are Unsupervised Multitask Learners" (2020) - 提出无监督学习与多任务学习在生成模型中的重要性。

- [6] "Improving Language Models via In-context Learning" (2022) - 具体阐述了在Contextualized Pre-training中的RL应用。

- [7] "The Training of OpenAI's GPT-3" (内部文档) - 关于OpenAI GPT-3的训练方法,可能包含RLHF细节。

- [8] "Language Models are Few-Shot Learners" (2022) - 强调少样本学习在RLHF中的价值。

- [9] "Fine-tuning with Human Feedback: A Case Study on Large Language Models" (2023) - 专门针对大规模语言模型的RLHF案例研究。

- [10] "Guided Diffusion Models for Creative Text Generation" (2023) - RLHF在扩散模型中的应用。

- [11] "Adaptive Reward Shaping for Text Generation" (2023) - 适应性奖励塑造技术在RLHF中的优化策略。

- [12] "Ethics and Bias in Large Language Models" (2023) - 关注伦理和偏见问题,讨论如何在RLHF中平衡生成质量与道德责任。

阅读这12篇论文可以帮助你深入了解RLHF在实际应用中的挑战、创新和最佳实践,以及它如何推动了现代生成式AI技术的发展,特别是像ChatGPT这样具有广泛影响力的模型。

114 浏览量

205 浏览量

282 浏览量

185 浏览量

175 浏览量

235 浏览量

271 浏览量

167 浏览量

2024-12-26 上传

2013crazy

- 粉丝: 1163

最新资源

- 富文本编辑器图片获取与缩略图设置方法

- 亿图画图工具:便捷流程图设计软件

- C#实现移动二次曲面拟合法在DEM内插中的应用

- Symfony2中VreshTwilioBundle:Twilio官方SDK的扩展包装器

- Delphi调用.NET DLL的Win32交互技术解析

- C#基类库大全:全面解读.NET类库与示例

- 《计算机应用基础》第2版PPT教学资料介绍

- VehicleHelpAPI正式公开:发布问题获取使用权限

- MATLAB车牌自动检测与识别系统

- DunglasTorControlBundle:Symfony环境下TorControl的集成实现

- ReactBaiduMap:打造React生态的地图组件解决方案

- 卡巴斯基KEY工具:无限期循环激活解决方案

- 简易绿色版家用FTP服务器:安装免、直接配置

- Java Mini Game Collection解析与实战

- 继电器项目源码及使用说明

- WinRAR皮肤合集:满足不同风格需求