支持向量机训练算法:Sequential Minimal Optimization(SMO)

需积分: 14 50 浏览量

更新于2024-07-15

收藏 90KB PDF 举报

"Sequential Minimal Optimization: A Fast Algorithm for Training Support Vector Machines"

本文主要介绍了一种用于训练支持向量机(Support Vector Machines, SVM)的新算法——Sequential Minimal Optimization(SMO)。SMO是由John C. Platt在1998年提出的,旨在解决支持向量机训练中的大规模二次规划(Quadratic Programming, QP)优化问题,从而提高训练速度和模型的准确性。

支持向量机是一种广泛应用于分类和回归任务的监督学习模型,其核心在于寻找一个超平面,使得不同类别的样本点距离这个超平面的距离最大化。在训练过程中,需要求解一个复杂的QP问题,这通常涉及到大量的计算和内存需求。SMO算法通过将大问题分解成一系列最小的QP子问题来解决这一难题。

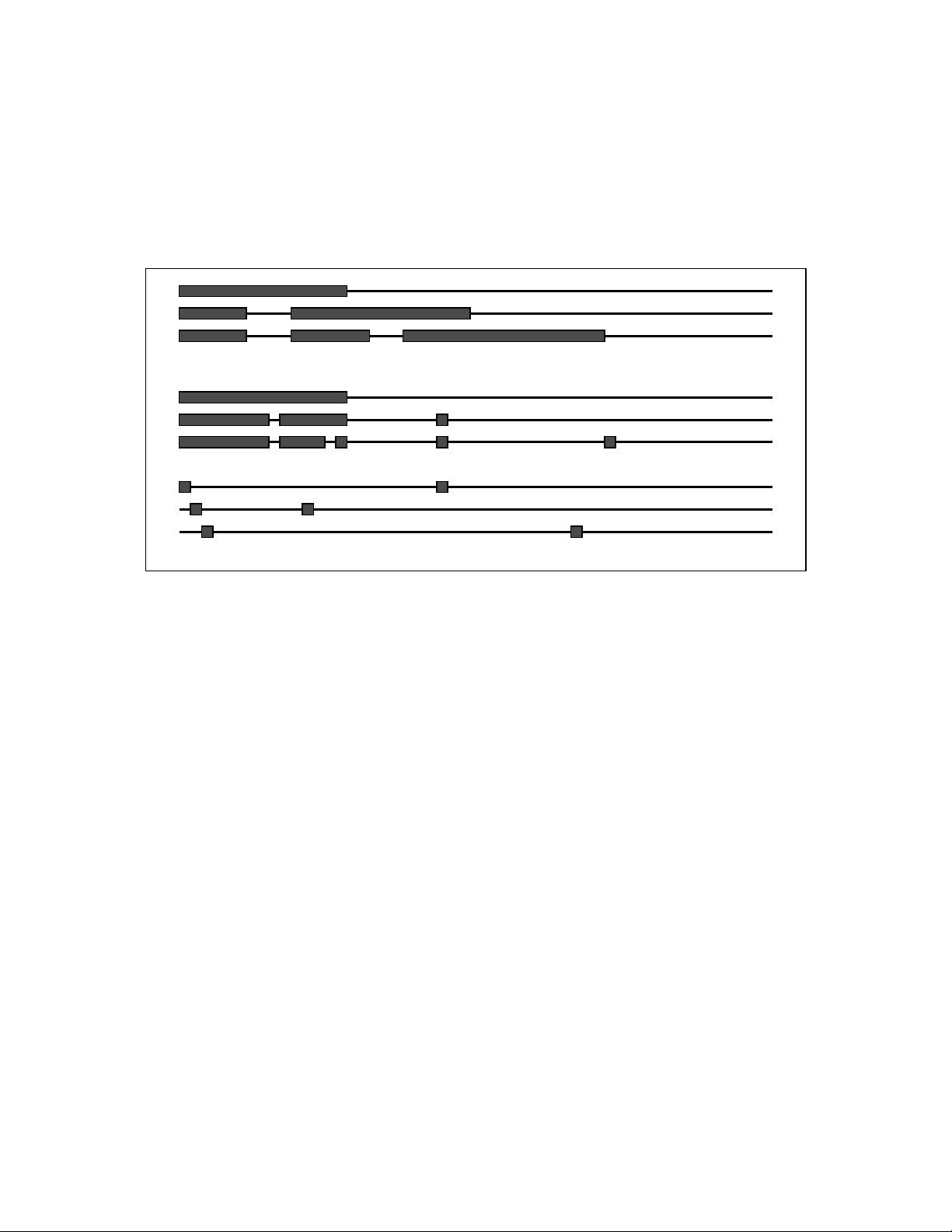

SMO算法的独特之处在于它将大QP问题分解为两个变量的优化问题,然后通过解析解求解这些小问题,避免了使用数值优化方法作为内部循环,从而显著减少了计算时间。这种策略使得SMO对内存的需求线性依赖于训练集的大小,因此可以处理大规模的训练数据。

在实际应用中,SMO的运行时间主要由支持向量的评估决定。对于线性SVM和稀疏数据集,SMO表现得尤为高效,因为这类问题中的支持向量评估更快。相比之下,标准的分块SVM算法的复杂度在训练集大小上介于线性和立方之间,对于大规模数据集来说,SMO的效率优势更为明显。

此外,SMO的性能在不同的测试问题中表现出介于线性与二次之间的扩展性,而传统的SVM算法则在最坏情况下可能达到三次方的复杂度。这意味着,对于大规模数据,SMO在保持高效的同时,也能保证较高的精度,对于机器学习领域,尤其是需要处理大量数据的问题,SMO算法的提出是一个重要的进步。

256 浏览量

116 浏览量

点击了解资源详情

123 浏览量

163 浏览量

2021-10-01 上传

130 浏览量

2013-09-07 上传

159 浏览量

不仅自己可见

- 粉丝: 23

最新资源

- MATLAB实现ART与SART算法在医学CT重建中的应用

- S2SH整合版:快速搭建Struts2+Spring+Hibernate开发环境

- 托奇卡项目团队成员介绍

- 提升外链发布效率的SEO推广神器——搜易达网络推广大师v2.035

- C#打造简易记事本应用详细教程

- 探索虚拟现实地图VR的奥秘

- iOS模拟器屏幕截图新工具

- 深入解析JavaScript在生活应用开发中的运用

- STM32F10x函数库3.5中文版详解与应用

- 猎豹浏览器v6.0.114.13396 r1:安全防护与网购敢赔

- 掌握JS for循环输出的最简洁代码技巧

- Java入门教程:TranslationFileGenerator快速指南

- OpenDDS3.9源码解析及最新文档指南

- JavaScript提示框插件:鼠标滑过显示文章摘要

- MaskRCNN气球数据集:优质图像识别资源

- Laravel日志查看器:实现Apache多站点日志统一管理